News Année 2006

Mois de Novembre/Décembre 2006

1/3 Les sommets politiques internationaux et l’Observation de la Terre, du climat et de l’Océan

Depuis quelques années les grandes rencontres internationales au niveau des chefs d’États commencent enfin à prendre en compte la question de l’environnement et du climat, ainsi que la nécessité d’établir des systèmes permanents d’observation de la Terre pour suivre et prévoir l’évolution de notre environnement.

On peut faire débuter l’historique de ces préoccupations aux travaux de la Commission Mondiale sur l’Environnement et le Développement (Commission Bründtland) mise en place par l’ONU en 1983. C’est cette Commission qui, dans son rapport de 1987 introduisit la notion de développement durable. Elle demanda au PNUE et à l'OMM d’entreprendre des actions dans le domaine des changements climatiques. De là naîtra en 1988 le GIEC (Groupe d’Experts Intergouvernemental sur l’Évolution du Climat) qui remettra son premier rapport lors d'une conférence intergouvernementale sur le climat, qui s’est tenue à Genève en novembre 1990, où il fut convenu d’inviter les chefs d’États à s’exprimer formellement sur ces questions.

C’est ainsi que fut organisée, à Rio de Janeiro en 1992, une Conférence des Nations Unies sur l’Environnement et le Développement (CNUED), plus connue sous son vocable anglais : «United Nations Conference on environment and Development - UNCED», encore appelée «Le sommet de la Terre», . Un document appelé «Agenda 21» représentant un plan d’action pour mettre en place le développement durable, et trois conventions-cadres, ont été signée par les plus hauts dirigeants de la centaine de pays représentés. Ces conventions sont les suivantes :

La convention cadre-sur le changement climatique

La convention cadre-sur la biodiversité

La convention cadre-sur la désertification

C’est la convention sur le changement climatique, plus connue

sous son acronyme anglo-saxon : «United Nations Framework Convention on

Climate Change - UNFCCC» qui a conduit au protocole de Kyoto, un

traité international, visant à réduire les émissions de gaz à effet de serre

pour un certain groupe de pays, et signé actuellement par 166 États

souverains.

Les parties prenantes à cette convention se réunissent régulièrement et

s'appuient sur les travaux des experts du GIEC dont on attend le quatrième

rapport en 2007.

Dix ans après le sommet de Rio, une deuxième conférence des Nations Unies

sur le développement durable, appelée «World Summit on Sustainable Development

- WSSD», qui s’est tenue à Johannesburg en Afrique du Sud en 2002, a

formellement reconnu un besoin urgent d’établir un système permanent

d’observations coordonnées de l’état de la Terre.

Un peu plus tard, en juin 2003, les chefs d’États présents à la réunion du G8 à

Evian, reprenant les recommandations du sommet de Johannesburg, ont réaffirmé

la haute priorité à donner à l’observation de la Terre.

A la suite de cette recommandation du G8, le premier sommet sur

l’observation de la Terre : «Earth Observation Summit - EOS» fut organisé

en juillet 2003 à Washington. Celui-ci mit en place immédiatement un «Group on

Earth Observations - GEO» et lança une action destinée à réaliser un

«Global Earth Observation System of Systems - GEOSS» dont la mission

est :

de prendre en compte les systèmes d’observation préexistants - tels que le «Global Climate Observing System - GCOS» mis en place pour le climat en 1992 par l’OMM (Organisation météorologique mondiale), le PNUE (Programme des Nations Unies pour l'environnement) et l’ICSU (International Council for Science),

de susciter de nouveaux "observatoires" pour les domaines non encore couverts, (océan et climat), et

d'assurer la coordination de l’ensemble.

Deux autres sommets sur l’observation de la Terre (EOS) suivirent, l'un à Tokyo en avril 2004, et le troisième à Bruxelles en février 2005 . Un plan décennal pour l’établissement du système global d’observation de la Terre a été adopté à l'issue de ces trois réunions.

De son côté L’Union Européenne a pris en 2000 l’initiative

d’un «Global Monitoring for Environment and Security - GMES», dont le

but est d'acquérirune capacité de surveillance globale et régionale de

l’environnement en coordonnant plus efficacement les infrastructures, les

technologies, et les systèmes d’observations (notamment spatiaux), actuels ou

futurs. GMES constitue la contribution européenne à l'initiative GEOSS.

Enfin plus récemment, en novembre 2006, ces recommandations ont été prises en

compte et réactualisées, sans que des progrès importants aient été notés depuis

2003, à l’occasion de deux conférences tenues à Nairobi :

La douzième réunion de l’UNFCCC

La deuxième réunion des pays signataires du protocole de Kyoto.

Il est difficile de suivre l’avancement des travaux de ces instances issues du plus haut niveau politique et de s’assurer qu’elles œuvrent efficacement au développement effectif d’une pluralité coordonnée de systèmes d’observations de la Terre et du climat, tant le nombre et l’imbrication de ces structures (Comités, Groupes de travail…etc.) sont complexes ! Par ailleurs de nombreux systèmes d’observations de la Terre, pour la plupart issus de la recherche, ont déjà été mis en place depuis plusieurs décennies. Il ne faut pas les fragiliser mais, au contraire, les renforcer, les coordonner, et surtout les pérenniser.

Qu’elle que soit l’efficacité des nouvelles instances internationales, "venues du sommet", il faut noter que pour la première fois, depuis 1992 et le sommet de la Terre de Rio, un grand nombre de chefs d’États ont signifié leur préoccupation et leur désir de prendre des mesures en faveur de l’organisation d’une observation continue de la Terre. Il existe une Veille Météorologique Mondiale qui s'occupe en premier lieu d'observations météo, il reste à créer l'équivalent pour l'océan et le climat : la Veille Mondiale Océan et Climat.

Cet intérêt récent des plus hauts niveaux politiques pour ces questions, augure peut-être, si l’on est optimiste, une ère nouvelle où enfin l’espèce humaine se montrera capable de s’organiser pour observer, comprendre, et conserver ce qui lui a servi de berceau.

Pour en savoir plus :

2/3 La vérité sur le changement climatique grâce aux rapports du Groupe intergouvernemental sur l’évolution du Climat (GIEC)

Le groupe intergouvernemental sur l’évolution du climat, plus connu dans le monde sous son nom anglais, Intergovernmental Panel on Climate Change (IPCC) est une création conjointe de l’Organisation Météorologique Mondiale (OMM) et du Programme des Nations Unies pour l’Environnement (PNUE). Il regroupe tous les états-membres de l’une ou l’autre des ces deux organisations.

Les rapports qu'il élabore sont publics et consultables sur le site internet de l' IPCC.

Les deux premiers rapports ont été publiés respectivement en 1990 et 1995. Le troisième a été approuvé en 2001. Un quatrième rapport est en cours d'élaboration et sera publié début 2007.

Ces rapports font état de scénarios possibles d'évolution du climat en fonction de diverses hypothèses portant d'une part sur la sensibilité de notre système climatique, et d'autre part sur la plus ou moins grande sagesse de l'humanité.

Les estimations qui résultent de ces diverses hypothèses, comportent toujours des barres d’incertitude. Alors que certains se complaisent à parler d'un processus diplomatique produisant de “la bouillie pour les chats”... chacun peut constater qu'il n'en est rien. Résultat de plusieurs années de travail, ces rapports sont établis par des scientifiques bénévoles après un processus rigoureux d'analyse, de consultations, et si nécessaire de débats contradictoires. Tous ces élément sont publics et l'enchaînement des hypothèses et de leurs effets est clairement expliqué.

Dans l'année qui précède la publication, le résultat de tout ce travail scientifique est soumis à une double évaluation ouverte d'une part à l'ensemble des scientifiques qu'ils soient ou non membres du GIEC et d'autre part aux experts désignés par leurs gouvernements.

On peut trouver des imperfections à ce processus, mais dans l'état actuel du débat sur les relations entre science et société, on n'en connaît pas de meilleur !

Pour en savoir plus :

Voir dans notre dossier "Changement Climatique" le détail du processus d'élaboration et de publication de ces rapports", mais aussi les FAQ sur le Climat et le site internet de l'IPCC : http://www.ipcc.ch/

3/3 Le Club des Argonautes présent au Salon Nautique avec son message sur l'Énergie Thermique des Mers (ETM)

Le Poster sur l'ETMet un Argonaute en pleine action !

Une équipe de vrais marins plutôt intrépides réunis autour d'Alain Guillard, n'a pas craint de traverser l'Atlantique dans les deux sens, sur une embarcation pas vraiment manœuvrante : un prao.

Invités par les organisateurs du SaIon Nautique, ces rudes gaillards nous ont aimablement proposé l'hospitalité. Sans partager toutes les opinions de ces militants de l'Énergie équitable, le Club de Argonautes éprouve du respect et même de l'admiration pour leur engagement et leur souhaite bonne chance pour leur prochaine entreprise.

Nota : pour ceux qui veulent imprimer ce poster : version .ppt

Mois d'Octobre 2006

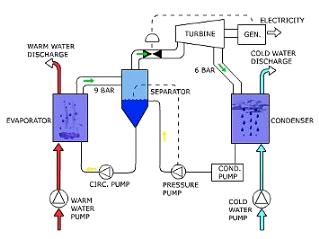

1/2 Énergie Thermique des Mers (ETM): Plaidoyer pour une contribution européenne.

Une majorité de scientifiques s'accordent aujourd'hui sur :

le lien entre les activités humaines, notamment les émissions de CO2, et le réchauffement global de la planète,

l'urgence des mesures à prendre. (Plus tôt on commence... plus grandes seront nos marges futures !)

Même si certains polémiquent encore, les "politiques" se sont saisis du problème, au plan international avec le Protocole de Kyoto, au plan européen avec l'élaboration de documents stratégiques et de directives, au plan national dans divers pays.

Par exemple, en France on peut citer la Mission Interministérielle sur l'Effet de Serre, le Plan Climat, ainsi que diverses missions spécifiques de l'Assemblée Nationale, du Sénat.

Au moment où l'on sent une prise de conscience réelle dans l'opinion publique, on peut se demander si l'efficacité des mesures prises jusqu'à présent est à la hauteur des enjeux.

Compte tenu du développement rapide de pays comme la Chine et l'Inde, la nécessité de réduire à terme d'un facteur 4 les émissions de CO2 des pays industrialisés est reconnue par la plupart d'entre eux, ce qui implique dans l'ordre: Sobriété volontaire, Efficacité énergétique, et Énergies Renouvelables, la "recette incontournable" , prônée entre autres par l'association Negawatt, pour éviter une réduction "subie" de notre niveau de vie.

Ainsi le Livre Vert de la Commission Européenne sur la politique énergétique, (consultation clôturée en septembre dernier), traite en grande partie de la sécurité énergétique, mais il propose aussi une série de mesures liées au réchauffement climatique. Outre des mesures "économie d'énergie", pour puiser dans l'immense gisement des gaspillages actuels, la Commission propose une Feuille de route pour les sources d'énergie renouvelable "qui fixerait des objectifs réalisables à l'horizon 2020 et au-delà afin de créer un climat de stabilité pour les investissements et d’améliorer la compétitivité de l’énergie renouvelable en Europe". Force est de constater que parmi les énergies marines citées, l'Énergie Thermique des Mers est complètement absente.

Un autre Livre Vert, consacré celui là à la politique maritime de l'Union, (consultation en cours jusqu'en juin prochain), mentionne dans son chapitre sur l'industrie maritime:

"Le vent offshore, les courants océaniques, les vagues et les marées constituent une source d’énergie renouvelable importante. Convenablement exploitée, elle pourrait représenter une grande partie de l'approvisionnement en électricité de nombreuses zones côtières européennes. Elle pourrait également soutenir le développement économique et la création d’emplois durables dans ces régions."

Le Club des Argonautes a déjà montré que le potentiel de l'Énergie Thermique des Mers peut être estimé à cent fois celui de la marée et cinq à dix fois celui du vent !

Cette ressource exploitant l'écart de température entre la surface et la profondeur n'est bien sur disponible que dans la zone inter tropicale. Avec la seconde Z E E (après celle des USA), l'Union Européenne y a largement accès, notamment dans ses Régions Ultra Périphériques. Pourquoi continuer à négliger cette chance ?

Un nouvel article "Plaidoyer pour l'ETM" vient d'être publié sur notre site, afin de mettre l'accent sur cette ressource abondante, non intermittente, et durable.

Livre vert : Une stratégie pour une énergie sûre, compétitive et durable

Livre vert: Vers une politique maritime de l'Union, une vision Européenne des Océans et des Mers (traduction qui comporte quelques erreurs, notamment "Vents de terre" pour "Offshore winds"....) Le lien avec ce livre vert a disparu du site officiel de la Commission Européenne

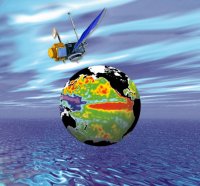

2/2 Le premier satellite Européen de météorologie MetOp a été lance avec succès le 19 octobre

Après 4 tentatives

infructueuses, (incidents, puis doutes, sur le lanceur Soyouz utilisé), la mise

en orbite du premier satellite météorologique européen défilant, MetOp, a été effectuée avec succès le 19 octobre, de Baïkonour,

sur un lanceur Soyouz.

Après 4 tentatives

infructueuses, (incidents, puis doutes, sur le lanceur Soyouz utilisé), la mise

en orbite du premier satellite météorologique européen défilant, MetOp, a été effectuée avec succès le 19 octobre, de Baïkonour,

sur un lanceur Soyouz.

Metop est le produit de la collaboration entre l’Agence Spatiale Européenne (ESA) et l’organisation pour l’exploitation des satellites météorologiques européens (EUMETSAT). La Veille Météorologique Mondiale comprend des satellites en orbite géostationnaire, (comme Meteosat, altitude 36000 km), et des satellites "à défilement", (en orbite polaire, altitude proche de 800 km), qui constituent le segment polaire du système de satellites météorologiques.

MetOp est le premier d’une série de trois satellites qui vont

se succéder au cours des quinze années à venir, et fournir aux services

météorologiques du monde entier les données indispensable à l’établissement des

prévisions et à la surveillance de l’évolution du climat. Complémentaire des

satellites lancés par la NOAA, il est la composante européenne d’une nouvelle

coopération avec les Etats-Unis d’Amérique qui, pendant les derniers quarante

ans, ont assuré seuls le service en orbite polaire.

MetOp vole sur une orbite

héliosynchrone à une altitude moyenne de 817 Km, tandis que les deux

polaires américains volent sur des orbites complémentaires. Dans ces

conditions, le satellite américain dit « du matin », (à cause de l'heure

solaire locale des zones survolées), ne sera pas remplacé, lorsqu'il atteindra

sa fin de vie: seul demeurera celui de l’après midi, assurant ainsi, grâce au

relais pris par la série MetOp, la couverture à deux satellites.

Les données sont disponibles pour les usagers dans les 2 heures et 15 minutes

qui suivent la mesure.

Grâce à l’usage combiné d’instruments nouveaux, MetOp améliore considérablement

les mesures météorologiques, tant en richesse qu'en précision: température et

humidité de l’atmosphère, direction et force du vent soufflant à la surface des

océans. De plus, il fournit les concentrations en ozone et autres gaz

minoritaires dans l’atmosphère, données essentielles pour une surveillance de

l’évolution du climat.

Dans le cadre de la coopération Europe États Unis, 5 instruments dits

"Héritage", (c. a d . ceux qui, fournis par la NOAA ou le CNES, se

trouvent déjà sur les satellites actuels), voleront sur les MetOps (ainsi que

sur les NOAA):

Le sondeur micro-onde de la NOAA (AMSU-A1 et A2) qui, en combinaison avec le sondeur haute définition infrarouge HIRS, fournit le profil vertical de température et d’humidité de l’atmosphère entre la surface et la haute stratosphère et permet d’obtenir les précipitations, la couverture neigeuse et l’humidité du sol et l’état des glaces de mer,

Le sondeur haute définition infrarouge HIRS/4, de la NOAA qui en plus de l’usage déjà cité permet d’obtenir la température de surface de l’océan, la masse totale d’ozone, la quantité d’eau précipitable, la quantité de nuages et leur hauteur ainsi que les radiances de surface,

Le radiomètre avancé de très haute résolution (AVHRR/3) de la NOAA qui fournit, nuit et jour, des images de la surface du globe, sa couverture en glace, neige et végétation ainsi la température de surface des océans,

ARGOS Next: En plus des mesures de divers paramètres atmosphériques et des images de la surface du globe, ce satellite assure la collecte et la retransmission de données au sol, (par exemple, les mesures In Situ faites à bord de bouées fixes et dérivantes), dans le cadre du système Argos mis au point par le CNES.

Il permet également la détection de navires ou d’aéronefs en détresse grâce, en particulier au Search And Rescue Processor (SARP-3), fourni par le CNES.

A ces 5 instruments "classiques" s’en ajoutent 5 nouveaux, tous européens:Le sondeur atmosphérique par interférométrie infrarouge (IASI), résultat d’une collaboration entre Eumetsat et le CNES, concepteur de l’instrument, est l’instrument embarqué le plus avancé. Il permet, à partir du rayonnement infrarouge émis par la surface du globe, de reconstituer le profil de température et d’humidité dans la troposphère et la basse stratosphère avec une résolution verticale d’1 Km et une précision de 1°C pour la température et de 10 % pour l’humidité,

Le Sondeur micro-onde d’humidité (MHS), qui permet la mesure de l’humidité à différents niveaux de l’atmosphère ceci incluant la pluie la neige et la grêle,

Le système de récepteur du système de navigation globale satellitaire (GRAS) qui à l’aide d’un récepteur GPS permet d’obtenir 500 profils atmosphériques par jour,

Le diffusiomètre avancé (ASCAT), version plus avancée de celui volant sur ERS2, qui fournit la force et direction du vent à la surface des mers et permet un suivi de l’état de la surface: glace, humidité du sol etc.

Le spectromètre de suivi de l’ozone (GOME-2) qui fournit le profil vertical détaillé de l’ozone, du dioxyde d’azote, de la vapeur d’eau, de l’oxygène, des oxydes de brome et de divers autres gaz minoritaires.

Le Club des Argonautes se réjouit du lancement réussi de

Metop-A . Pour la prochaine génération d'un tel programme, il souhaite qu'elle

puisse être réalisée en ayant recours a une flottille de microsatellites

qui ont l'avantage, par rapport aux grosses plate formes, de ne pas mettre

"tous les oeufs dans le même panier", (10 instruments, aux exigences parfois

contradictoires, cohabitant sur un seul et même bus...), ce qui conduit à un

risque important lors des phases critiques, (lancement, en particulier).

En effet, la technologie spatiale offre désormais une autre option: de petits

satellites dédiés comportant seulement 2 ou 3 instruments: ces engins, moins

lourds et moins coûteux, (Envisat a une masse, et un coût, comparables à celle

de 18 "Mini-sats" comme Jason-2...), peuvent, être fabriqués et lancés

indépendamment; la maîtrise des techniques du "R.V. en

orbite" permet ensuite de retrouver, grâce au vol

en formation, le bénéfice de mesures co-localisées, qui est la seule

justification des gros satellites.

Au terme des vérifications prévues, MetOp sera opérationnel dans six mois

environ. En plus de son emploi pour le suivi et la compréhension de l’évolution

du climat, MetOp sera surtout un outil fondamental pour la prévision

météorologique. Le gain doit être d’abord dans la prévision à courte et moyenne

échéance, moins de deux semaines, où l’on espère un accroissement de la

prédictibilité d’une demi journée au cours des trois ans à venir. Pour mémoire

l’amélioration au cours des vingt dernières années a été d’un jour et demi. La

qualité des données ainsi que l’obtention de nouvelles mesures devrait aussi

permettre d’améliorer la prévision à longue échéance, mensuelle et

saisonnière.

Les satellites d'Eumetsat et de la NOAA s’inscrivent dans le

cadre de la Veille Météorologique Mondiale (VMM) et de la Veille de

l’Atmosphère Globale (VAG) de l’OMM. Il s'agit d'un tissu d'engagements

gouvernementaux (185 Etats) qui permet, entre autres, d'éviter toute

interruption des observations Météo. Rappelons que depuis sa création, le

Club des Argonautes prône la mise en place d'un mécanisme analogue: une "Veille

Mondiale Océan et Climat".

Pour en savoir plus :

· Site de l'ESA : http://www.esa.int/esaLP/LPmetop.html

· Site des Argonautes : La Géoscopie,

outil de base de la « Géonautique ».

Mois de Septembre 2006

1/1 Océan et climat, nouveau livre de Jacques Merle..

Bien que, depuis plusieurs millénaires, de hardis navigateurs

aient parcouru sa surface à la recherche de terres nouvelles, l'océan est

demeuré longtemps le plus mal connu des milieux naturels terrestres. Au cours

des dernières décennies du XX ème siècle la préoccupation climatique a

précipité son étude, ouvrant la voie à son observation opérationnelle et à la

prévision du climat. C'est ce que les Argonautes, qui n'ont pas peur des

néologismes, appellent " Géoscopie".

Bien que, depuis plusieurs millénaires, de hardis navigateurs

aient parcouru sa surface à la recherche de terres nouvelles, l'océan est

demeuré longtemps le plus mal connu des milieux naturels terrestres. Au cours

des dernières décennies du XX ème siècle la préoccupation climatique a

précipité son étude, ouvrant la voie à son observation opérationnelle et à la

prévision du climat. C'est ce que les Argonautes, qui n'ont pas peur des

néologismes, appellent " Géoscopie".

En effet l'océan joue un rôle essentiel dans les mécanismes complexes qui régissent le climat. L'océan est, avec l'atmosphère, une enveloppe fluide de notre Terre qui assure trois fonctions essentielles : il stocke la presque totalité de l'énergie reçue du soleil, il échange cette énergie avec l'atmosphère et surtout il transporte cette énergie, principalement sous forme thermique, au delà des aires de stockage initiales que sont les tropiques rendant ainsi notre planète habitable.

Après un bref récit de la découverte des océans, en surface et en profondeur, et des premiers pas de la science océanographique, l'ouvrage nous fait pénétrer dans " l'ère géophysique" contemporaine qui a pris naissance autour des grandes questions scientifiques posées aux océanographes au cours de ces dernières décennies par la nécessité de comprendre le rôle de l'océan dans le climat.

Ces questions sont regroupées et traitées autour de trois thèmes principaux :

Quel est le rôle de l'océan dans l'équilibre énergétique planétaire ?

Quelle est la nature et l'importance de la singularité équatoriale dans la circulation océanique ?

Comment l'océan et l'atmosphère interagissent-ils, spécialement dans les basses latitudes ?

L'ambition de l'ouvrage est de mettre en évidence un moment charnière d'une discipline scientifique mal connue du public, l'océanographie physique, qui, en moins de 50 ans, est passée d'une approche descriptive et géographique à une approche géophysique.

Jacques Merle souhaite apporter une contribution à l'histoire de l’avancée rapide des connaissances de ce domaine scientifique à la fin du XX ème siècle, porté par des technologies nouvelles telles que les engins autonomes, l’observation spatiale et la modélisation numérique.

Cette histoire est jalonnée par les questions et les réponses qui progressivement ont émergé à l’issue de grands programmes internationaux, de conférences, de réunions de groupes de travail, d'écoles d'été etc...

Ce brassage de chercheurs de toutes origines disciplinaires et nationales, météorologues et océanographes confondus, incluant théoriciens et observateurs, était motivé par une ambition commune : comprendre comment la dynamique de l'océan interagit avec l'atmosphère pour déterminer le climat et sa variabilité.

Cette épopée scientifique fut aussi remarquable par sa dimension humaine. Ignorant les frontières nationales, linguistiques ou culturelles, des relations professionnelles et amicales d'une exceptionnelle qualité ont lié les acteurs de ces programmes de recherche, en dépit de la compétition inhérente à toute activité de recherche.

C'est une "photographie humaine" de cette époque, caractérisée par les premiers grands rassemblements scientifiques à l'échelle planétaire, que l'auteur veut aussi donner en souhaitant que cette communion scientifique soit le prélude à une prise de conscience des nations de la nécessité d'effacer les frontières pour gérer le risque climatique au bénéfice de tous.

Mois de Juillet/Août 2006

1/3 Pour les amoureux de la mer.... et de la planète...

Le N°6 de Nautilus... un dossier fort intéressant sur "La mer et le Climat"

"C'était une sorte de principe : à Nautilus, on montre comme la mer est belle. Alors, pour aborder le climat, il était simple de montrer que la vie sur Terre serait invivable sans océan; que sans les courants marins, l'Europe n'aurait pas cette douceur; et que c'est encore grâce aux océans que les énormes rejets de C02 de notre civilisation industrielle n'ont pas encore davantage affecté notre planète....." Extrait de l'Éditorial de Christophe Agnus.

Voir entre autres les articles de Bruno Voituriez : "Quand l'océan influence le climat" et "Les mystères du Gulf Stream", mais aussi La mer acide, Noirmoutier, Ré, Oléron, Banneg, les îles assiégées, Albert 1er: le prince océanographe.

Voir aussi dans le n° 476 de la Revue Maritime, deux articles sur le thème "Océan et Climat :

"Le niveau moyen des mers" de Jean-François Minster et "Le Gulf Stream et le Climat" de Bruno Voituriez.

2/3 Circulation océanique et production littéraire... Nouvel ouvrage sur le Gulf Stream de Bruno Voituriez.

Il y a un peu plus d'un

an, dans son livre : "Portrait du

Gulf Stream, éloge des courants", Erik Orsenna nous invitait à une

promenade autour du monde. Le promeneur curieux traquait toutes les bizarreries

liées aux courants marins, se demandait si le Gulf Stream était un imposteur et

apportait quelques éléments de réponses, donnant ainsi au lecteur l'envie d'en

savoir plus.

Il y a un peu plus d'un

an, dans son livre : "Portrait du

Gulf Stream, éloge des courants", Erik Orsenna nous invitait à une

promenade autour du monde. Le promeneur curieux traquait toutes les bizarreries

liées aux courants marins, se demandait si le Gulf Stream était un imposteur et

apportait quelques éléments de réponses, donnant ainsi au lecteur l'envie d'en

savoir plus.

Dans un partage de taches bien compris et comme il convient pour des

Argonautes, aujourd'hui, Bruno Voituriez achève de répondre scientifiquement

aux interrogations si fréquentes que suscite ce courant : son rôle dans le

climat et son évolution liée au changement climatique, son impact sur les

écosystèmes marins de l'Atlantique Nord....

Erik et Bruno sont tous les deux des "amoureux de la mer" et des "obsédés du

Gulf Stream" et leurs deux livres se complètent admirablement.

3/3 L'eau de mer profonde: une richesse encore peu connue...

Après la climatisation et l'énergie thermique des mers... de l'eau douce, une eau minérale qui vient des profondeurs !

Crédit CHC

«Suite à la demande croissante des acheteurs

japonais, les exportations d’eau de boisson produite à Hawaii par dessalement

d’eau de mer profonde ont brusquement augmenté de 700 % pour atteindre 8,8

millions de US dollars au cours du premier trimestre de l’année 2006 »

.

Les travaux américains de recherche pour le développement de l’énergie

thermique des mers – ETM - sont en grande partie réalisés au Natural Energy

Laboratory of Hawaï, le NELHA, créé en 1974 à l’initiative de l’État d’Hawaï.

Ces travaux ont eu pour premier objectif la mise au point des technologies

adaptées à la production de cette énergie marine propre, stable et abondante,

puis s’y est ajouté, dans la décennie 1980 celui visant la valorisation de

produits dérivés du procédé ETM qui utilise le gradient thermique créé en

région tropicale entre l’eau de mer de surface chauffée par le soleil et l’eau

de mer froide pompée sous la thermocline.

Cette eau profonde qui est une composante fondamentale de la circulation

générale des océans et de l’équilibre climatique de notre biosphère est à la

fois froide, et riche en nutriments. C’est à partir de ce constat que le NELHA,

doté d’infrastructures de pompage ad hoc, les à mise à disposition d’une

pépinière d’entreprises, publiques et privées, utilisant cette eau profonde

pour la production de services et de produits divers, notamment pour la

climatisation des locaux, la production aquacole, et la production d’eau

douce.

La production d’eau douce associée à la production d’électricité par ETM est

directe dans la variante du procédé dite à cycle ouvert. Dans cette

variante, c’est le condensat de la vapeur d’eau recueillie dans un condenseur à

surface qui peut être valorisé. Les premières tentatives d’application

commerciale de ce procédé ont été réalisées par G.Claude dans les années

1930.

Un autre procédé de production d’eau douce à partir de l’eau froide profonde

et plus directement destiné à l’irrigation a été proposé par la société «

Common Heritage » et expérimentée au NELHA. Il consiste à faire circuler l’eau

de mer froide dans un réseau de tuyaux enterrés près de la surface. La

condensation de l’air humide sur la paroi externe de la tuyauterie suffit dans

certaine configuration à assurer le besoin des plantations (Photo de

gauche).

Ces procédés n’ont pas atteint le seuil de rentabilité économique... mais

paradoxalement... c’est le succès d’une innovation "exotique" (Photo de

droite) qui fait la fortune des sociétés productrices d’eau douce obtenue

en dessalant l’eau de mer profonde ! Dotée de vertus associées à une eau

dont la circulation dans les bassins océaniques profonds est plusieurs fois

séculaire, cette nouvelle boisson est particulièrement appréciée par les

consommateurs japonais.

Avec plus de cent emplois créés et des investissements supérieurs à 100

millions de US dollars, la valeur des exportations de cette eau extraite de

l’eau de mer profonde était de 16,8 millions de US $ en 2005. Elle aurait déjà

atteint près de 9 millions de US $ au cours du premier trimestre 2006 !

Pour en savoir plus :

http://the.honolulu...1.html

http://www.hawaii...water.com/

Mois de Juin 2006

1/2 - Oui, le niveau moyen des mers augmente ! Pourquoi ? Comment ? ET OU ?

Du 6 au 9 juin, s'est tenu à l'Unesco, un "Workshop" sur les variations du niveau des mers, réunissant la fine fleur des Sciences de la Terre : océanographie, climat, géodésie, glaciologie... Pas moins de 42 sponsors et organismes participants invitaient au débat sur l'avancement des programmes de recherches en cours, et des actions à mener d'ici 2015. Comme l'indique le programme, c'était : "A World Climate Research Programme (WCRP) contribution to the Global Earth Observation System of Systems (GEOSS)".

Le GEOSS, proposé par les USA en Juillet 2003, rassemble aujourd'hui 55 nations et 30 organisations internationales. L'objectif est de fédérer toutes les recherches et applications de l’observation de la Terre, afin de mettre en place à terme un «réseau mondial de systèmes d’observation de la Terre» pour mieux comprendre notre climat et notre environnement.

Dans le triangle "Océan-Climat-Énergie", (et les relations sur les cotés de ce triangle, que le Club s'efforce de montrer), le "niveau moyen des mers" occupe une place centrale. Par exemple, l'Énergie Thermique des Mers, pratiquée sur une grande échelle n'exploiterait qu'une infime partie de la chaleur qui dilate certaines régions de l'océan !

Loin des idées fausses qui circulent sur le sujet, Le Club des Argonautes s'est passionné pour cette conférence.

L'élévation du niveau des mers est liée au réchauffement de la planète. Elle a deux causes principales :

la dilatation thermique de l'eau (effet stérique), et la fonte des glaces continentales. Son évolution peut avoir des conséquences dramatiques dans certaines régions, ("Savoir-Terre pour Savoir-vivre", c'est l'idée de base d'une Géoscopie pérenne !)

L'altimétrie et la géodésie satellitaires, conjuguées avec les meilleures mesures In Situ (marégraphes sélectionnés), donnent l'évolution du niveau moyen par provinces océaniques, avec une précision de l'ordre du mm / an. (à condition qu'il n'y ait pas d'interruption dans les séries temporelles). L'effort sans précédent depuis 20 ans, (WOCE, suivi de CLIVAR, GOOS, et GODAE, entre autres...), montre 2 résultats essentiels :

alors que l'on savait de façon théorique combien la diffusion de la chaleur dans un océan plus ou moins stratifié est un processus complexe, (lié à la "géographie 3D" des courants...), la surveillance continue des variations du niveau de l'océan grâce aux mesures d'altimétrie satellitaire, nous "montre le film" ! Il existe des régions ou le niveau de la mer baisse, tandis que dans d'autres, il monte 4fois plus vite que la moyenne». !

globalement, sur 10 ans, on observe une accélération du niveau moyen: 3 mm / an, (au lieu de 2 mm /an sur les 50 dernières années), valeur que l'effet stérique ne suffit plus à expliquer ! Constat considérable, vue la controverse sur l'évolution de la cryosphère, (une croissance de la partie Est de la calotte Antarctique pourrait contrebalancer, en totalité ou en partie, la fonte de certains glaciers et du "littoral" du Groënland) !

Comme toute mesure physique, le chiffre de 3 mm /an n'a aucun sens si on ne l'assortit pas d'une barre d'erreur. L'estimation de la précision met en jeu un grand nombre de questions aussi variées que le rebond post glaciaire, la tectonique des plaques, les systèmes de référence géodésique, sans oublier l'instrumentation et ses dérives éventuelles (marégraphes, radar-altimètres, et radiomètres micro-ondes embarqués).

Ainsi, outre son intérêt direct pour des millions de personnes, futures "réfugiées du climat", la variabilité du niveau des mers est un sujet interdisciplinaire ... A l'instar du " SWT (Science Working Team) du projet Jason-1", ce fut le grand mérite de cette conférence de réunir des chercheurs et ingénieurs qui... ne parlent pas la même langue, au sens propre comme au sens figuré !

Un "argonaute", bien que retraité, (comme tout membre du Club...), a eu le privilège de se glisser parmi eux ! 3 propositions, (qui ne surprendront pas les visiteurs familiers de ce site), ont été faites :

Sur une question qui attire autant le public, les élus, et la presse, (sans oublier les compagnies d'assurance !), et où interviennent différentes sortes d'incertitudes, il est vital de former les chercheurs à "communiquer", non seulement entre eux, mais aussi vers l'extérieur ! On sait que dans son 3ieme rapport, (2001), le GIEC a fourni une "fourchette globale" du réchauffement possible (2 a 6 degré). Il est clair que le 4ieme rapport (2007) devrait éviter de mêler 2 éléments n'ayant rien à voir: la connaissance imparfaite de la sensibilité du climat d'une part, (c a d la relation entre température moyenne et concentrations en gaz a effet de serre ), et sagesse imparfaite de l'humanité... d'autre part, (c a d les scénarios d'émission).

Alors qu'un "Run" de modèle climatique ne risque pas de... changer la sensibilité du climat, la façon de parler de "scénarios d'émission", (c a d d'une poursuite plus ou moins rapide de la démarche "Protocole de Kyoto"...), pourrait avoir "un effet" sur ces scénarios !

Exprimer "fort et clair" (au niveau du GEOSS), combien la continuité de ces mesures est critique: comme en Météo, il y a plusieurs décennies, il est urgent de la soustraire à la compétition entre sujets de recherche et entre institutions (Agences spatiales, européennes ou non...) Pour cela, il faut soit doter les Instituts de Recherche de moyens pérennes, soit créer des services "ad hoc" (a l'exemple des services météo). Ce choix relève de chaque gouvernement, mais doit être fait (et garanti par des engagements internationaux, un bon moyen de mettre cette nécessaire "Veille Mondiale Océan et Climat", à l'abri des effets de mode et des aléas de la vie politique !)

Dans le cas de la création de services "ad hoc", (hors secteur Recherche), le maintien du dialogue avec les scientifiques s'impose ! Il s'agit d'éviter 2 situations redoutées:

avoir des "chercheurs qui... manquent de mesures" (même s'ils savent... garder la mesure !) ou...

avoir des "observations sans chercheurs qui les observent !" (Ce qui est fréquent, hélas, dans les pays du Sud !)

S'intéresser davantage à un sujet sur lequel le Club a pas mal réfléchi (cf. ci-dessous), et qui est "connexe du niveau moyen": quelle serait l'incidence d'une éventuelle exploitation industrielle de l'ETM ?

En guise de conclusion, un hommage à l'humoriste Raymond Devos, qui vient de nous tirer sa dernière révérence... Chacun se souvient que, lorsqu'un maître d'hôtel l'avait averti "La mer est démontée !", Devos n'avait pas hésité à lui demander: "Quand est-ce que vous la remonterez ?" Le malheureux avait répondu: "C'est une question de temps..." Aujourd'hui, un scientifique ajouterait sans doute: "II faut prendre des mesures" !

2/2 - ETM (Énergie Thermique des Mers) : ça bouge dans l’Océan Pacifique et dans l’Indien.

Depuis sa création, le club des Argonautes s’efforce de mettre en valeur les potentialités considérables (et largement ignorées) de l’ETM. Il faut savoir en effet, qu'à lui seul, le réchauffement moyen de l'océan superficiel au cours du 20ieme siècle, (0,6° environ), représente une augmentation de chaleur stockée dans l'océan du même ordre de grandeur que 500 ans de consommation mondiale d'énergie primaire (en 2001) !

Pourquoi, faire si peu de cas d'une telle source d'énergie, renouvelable et non intermittente ? Probablement à cause d'une appréciation erronée de l'efficacité du procédé et, partant, de son coût... Mais voici que les choses changent ! Le mois dernier, c'était la mise en service d’un nouveau système de climatisation dans un hôtel de Bora Bora (Polynésie Française). Les frigories nécessaires sont extraites d'une eau à 5°C, pompée dans l’océan par 1024 mètres de fond.

Ce mois-ci, plusieurs annonces parues dans la Presse font état de la décision prise par les États-Unis de construire deux usines pilotes : l’une de 1MW à Hawaï au NELHA, l’autre de 10 MW à Diego Garcia , pour assurer la production d’électricité et d’eau douce de la base militaire US installée sur l’île principale de l’atoll depuis les années 1960.

Technique connue, non polluante, et de faisabilité démontrée depuis plus de 70 ans, l’exploitation de l'ETM semble enfin reconnue comme un procédé compétitif.

Il est vrai qu'avec l’augmentation inéluctable du prix du pétrole, la vulnérabilité de nos approvisionnements, et surtout l'urgence du recours à des ressources renouvelables et propres, on ne peut continuer à négliger la moindre piste.

Toutefois, pomper de l’eau froide sous la thermocline, (à quelques centaines de mètres de profondeur), pour l’utiliser à des fins industrielles, puis la rejeter sous la forme d’effluents plus ou moins réchauffés, pourrait créer une perturbation des équilibres thermiques et chimiques du milieu naturel, soit localement autour du point de rejet, soit même au delà, selon l’importance et le nombre de ces rejets. Dans l'hypothèse d’un développement rapide de l'ETM, (des centaines, puis des milliers, de plate-formes exploitant le contenu thermique d'une zone inter-tropicale vaste comme 120 fois la France), on doit naturellement se poser la question de ses effets sur l’environnement, et des limites tolérables de son exploitation. C'est dans cet esprit que le Club des Argonautes a élaboré un projet de de recherche qu'il soumet à la communauté scientifique internationale : «Étude des impacts des rejets d’effluents générés par l’exploitation de l’énergie thermique des mers (ETM)».

Mois de mai 2006

1/2 Mise en service de la première installation de climatisation par l'eau de mer profonde dans un hôtel de la Polynésie Française

Depuis le 1er mai 2006, l'Hôtel Intercontinental de Bora Bora a remplacé son système traditionnel de climatisation par un système basé sur l'utilisation de l'eau de mer profonde.

Crédit Hôtel Intercontinental

L'eau est puisée à 1024 mètres de profondeur à la température de 5°C, puis elle passe dans un échangeur de chaleur pour refroidir le réseau de climatisation, à l'aide d'un tuyau de 2 km de long et 40 cm de diamètre.

Le système de pompage de l'eau de mer consomme 15 kW électrique, alors que l'ancien système consommait 300 kW.

Ci-dessous, à gauche, vue du tuyau en polyéthylène haute densité franchissant une falaise sous marine à 55 m de profondeur et touchant à nouveau le fond de la mer à -125 m.

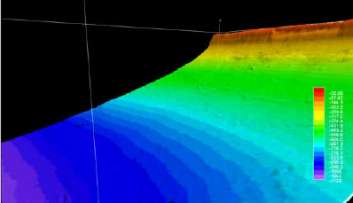

Ci-dessous, à droite, résultat de mesure de bathymétrie de la zone concernée, sur 1 100 mètres de profondeur. Le décrochement de la falaise est situé devant l'hôtel.

Crédit Makai Ocean Engineering Inc.

Ce système SWAC (SeaWater Air Conditioning) a été mis au point et installé par la Société d'Hawai "Makai Ocean Engineering", très innovante dans ce domaine .

En effet dans le cadre du développement de la filière renouvelable ETM (Énergie Thermique des Mers ou OTEC en Anglais), l'État d'Hawaii a été depuis trois décennies le promoteur des utilisation de l'eau froide profonde. Souhaitons que cette réalisation réveille l'intérêt de la France métropolitaine pour ces technologies marines.

A noter que la ville de Stockholm climatise déjà le centre de la ville avec l'eau de la mer Baltique. Des systèmes similaires peuvent fonctionner avec l'eau des lacs, c'est les cas par exemple de la climatisation du campus de l'Université de Cornell aux États Unis.

Pour en savoir plus :

Seawater Air Condition, Makai Ocean Engineering Inc.

BoraBora Seawater Air Conditioning News.pdf

L'eau de mer profonde : son utilisation pour le refroidissement d’air d’immeubles situés en bord de mer (ou de lac).

Énergies renouvelables, état de l'art et perspectives de Michel Paillard IFREMER Janvier 2006

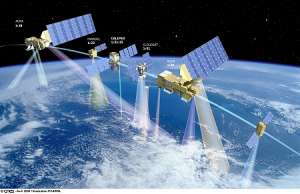

2/2 Ce 28 avril 2006, Calipso et Cloudsat ont rejoint la constellation de satellites A-TRAIN, véritable observatoire spatial du climat

Cette

constellation, fruit d'une coopération franco américaine, comprend six

satellites situés sur la même orbite, à quelques minutes d'intervalle : Aqua

depuis 2002, Aura depuis juillet 2004, Parasol depuis décembre 2004, Cloudsat et

Calipso ce mois-ci, et enfin OCO prévu en 2008, nous donneront des

informations sur le cycle de l'eau, la température et l'humidité de

l'atmosphère, la qualité de l'air, l'ozone, les nuages, les aérosols et le

dioxyde de carbone (CO2).

Cette

constellation, fruit d'une coopération franco américaine, comprend six

satellites situés sur la même orbite, à quelques minutes d'intervalle : Aqua

depuis 2002, Aura depuis juillet 2004, Parasol depuis décembre 2004, Cloudsat et

Calipso ce mois-ci, et enfin OCO prévu en 2008, nous donneront des

informations sur le cycle de l'eau, la température et l'humidité de

l'atmosphère, la qualité de l'air, l'ozone, les nuages, les aérosols et le

dioxyde de carbone (CO2).

Ces observations "ciblent" les processus complexes, (et interdépendants), qui interviennent dans le renforcement de l'effet de serre lié aux centaines de milliards de tonnes de CO2 que nous avons relâchées dans l'atmosphère depuis 150 ans. En particulier, la connaissance de "l'effet parasol" des nuages et du rôle des aérosols sur les divers types de nuages, devrait permettre d'affiner les modèles prédictifs, dont les prévisions de température moyenne 2100, (15°C à présent), ont une incertitude globale de 2 à 6° (la moitié environ résultant du comportement plus ou moins "sobre" qu'adoptera l'humanité - cf. travaux du GIEC).

Une meilleure connaissance des interactions entre ces processus contribuera aussi à rapprocher les points de vue divergents sur l'évolution du climat. Notamment entre ceux qui redoutent un emballement (et donc, une catastrophe climatique), et ceux qui pensent que grâce aux "rétroactions négatives", cela pourrait s'arranger tout seul !

Pour en savoir plus :

Revue d'information CNES, NASA, CNRS : "Calipso, percer les secrets des nuages"

Mois d'Avril 2006

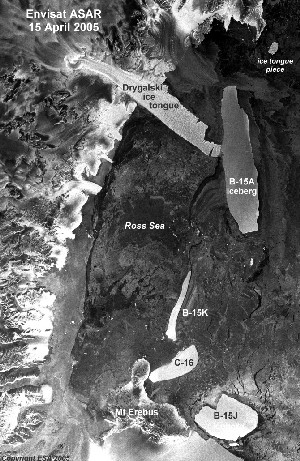

1/2 Accrochages en mer de Ross (Antarctique)

La langue de glace de Drygalski est une énorme feuille de glace

et de neige qui s'avance sur 80 km, dans la partie centrale de la mer de Ross.

"C-16", un iceberg géant, (1000 km2), en a arraché l'extrémité, le 30

mars 2006, (image de droite), donnant ainsi naissance à un nouvel

iceberg (celui en forme de carré). Cet "accident de circulation

océanique" n'a pas échappé au radar imageur, "ASAR" du satellite

Envisat (ESA) !

En outre, le même ASAR (Advanced Synthetic Aperture Radar) avait

déjà capté, le 15 avril 2005, un évènement analogue: "B15A", un iceberg

3 fois plus gros que "C16"... avait déjà commencé à raboter, il y a près

d'un an, cette péninsule glaciaire décidément très exposée ! Sur l'image du 15

avril 05, on aperçoit d'ailleurs C-16, échoué sur la partie nord de

l'île de Ross .

2/2 Quinze ans de progrès en altimétrie radar

Du 13 au 18 mars, plus de 500

chercheurs et ingénieurs de 60 pays se sont réunis à Venise pour le Symposium

"Quinze ans de progrès en altimétrie radar".

Du 13 au 18 mars, plus de 500

chercheurs et ingénieurs de 60 pays se sont réunis à Venise pour le Symposium

"Quinze ans de progrès en altimétrie radar".

En dépit de l'arrêt fin 2005 de TOPEX-Poseidon

, plus de 13 ans après son lancement, les océanographes et les climatologues

disposent encore de 3 satellites munis d'un altimètre radar : GFO (Geosat

Follow On), Jason-1, et Envisat. L'arpentage permanent de l'océan mondial peut

donc se poursuivre ! Et avec lui, la moisson de résultats qu'il permet (études

de processus et leur représentation dans les modèles).

Il nous reste à "croiser les doigts" pour que cette présence

simultanée de 3 systèmes de mesures, (dont un système de haute précision :

Jason-1, le "petit frère" de TOPEX- Poséidon...), tous en orbite depuis au

moins 4 ans, se prolonge encore 3 ans, (jusqu'en 2009), de façon à avoir un

recouvrement de quelques mois avec leurs successeurs (Jason-2/OSTM + Alti-Ka).

On ne peut hélas compter sur une longévité aussi exceptionnelle que celle de

Topex-Poséidon, fruit de véritables prouesses de NASA /JPL et du CNES !

Les objectifs négociés il y a 20 ans, (ceux des programmes WOCE et TOGA),

visaient une meilleure connaissance de la "Planète Bleue", de ses courants

océaniques (notamment la circulation "méso-échelle"), et des mécanismes du

couplage Océan-Atmosphère, qui interviennent dans la variabilité naturelle du

climat.

Outre les résultats "contractuels", il y avait les résultats

"attendus ou espérés" : marées, ondes internes, calottes polaires,

niveau moyen des mers, vents, hauteur des vagues, topographie des fonds et des

dorsales océaniques: comme cela a déjà été décrit en

détail sur ce site, ils ont tous été atteints ou dépassés ! Enfin,

il y a les résultats "inattendus", en Sciences de la Terre bien sur,

(notamment en Hydrologie continentale), mais aussi pour la

caractérisation fine des instruments.

Ce progrès en "métrologie de la surface océanique" se conjugue avec

celui des modèles du champ de gravité, de sorte qu'après

"retraitement" des mesures brutes, (soigneusement archivées), de nouveaux

résultats sont envisageables ! (y compris... à "titre posthume", en ce qui

concerne TOPEX-Poséidon !)

la "recette de cette spirale vertueuse" est maintenant bien connue : diffusion, en temps quasi réel, de la totalité des informations (sans aucune exclusivité pour les équipes de recherche sélectionnées par le CNES et la NASA...), dialogue permanent entre chercheurs et ingénieurs, (notamment pour les étalonnages et les corrections : ionosphère, troposphère, biais d'état de mer), vol "en formation" de 2 systèmes de haute précision (mission "Tandem"), et enfin "approche intégrée", (ou "multi-variée") : on associe toutes les mesures disponibles (pas seulement celles des altimètres...), en particulier, celles du système GRACE, (mesure du champ de gravité), tant pour l'orbitographie que pour la surface moyenne océanique.

Ces résultats, parfois inespérés, (variation du niveau moyen des mers, série climatique de haute précision, ininterrompue depuis 1992, et que les modèles de climat vont désormais s'efforcer de reproduire...), montrent la justesse des choix scientifiques, (et programmatiques), faits depuis 20 ans; ils illustrent le "couple magique" que peuvent constituer une vision et une volonté partagées dans différentes institutions, sur plusieurs continents, par un ensemble de chercheurs et d'ingénieurs. La richesse et la diversité des "objectifs géoscopiques" désormais accessibles sont clairement apparues à Venise !

De façon paradoxale, cette situation constitue pour le Club un motif de jubilation, et... une inquiétude grandissante ! En effet, faute d'une "Veille Mondiale Océan et Climat", ces séries continues de mesures globales, indispensables tant pour la prévision "méso-échelle", que pour la compréhension et le suivi du Changement Climatique, peuvent s'interrompre à tout moment : ce que les océanographes et les agences spatiales ont réussi à faire "en mode Recherche", doit désormais passer "au stade opérationnel", une transition que certains ont comparé, (dans un rapport à l'Académie des Sciences des États Unis), à : "Traverser la Vallée de la Mort" !

C'est pourquoi les Argonautes appellent de leurs vœux

l'instauration d'une "Veille Mondiale", à l'image de la "Veille Météorologique

Mondiale", qui assure chaque jour, à l'échelle du globe, le recueil et la

diffusion des mesures nécessaires à la prévision météo... Il est temps

de pérenniser dans un cadre international adapté les

différentes initiatives de la communauté scientifique, aujourd'hui morcelées à travers plusieurs programmes

internationaux, et celles des agences, notamment de la NOAA et d'Eumetsat, déjà

partenaires dans des projets tels que Argo, Jason-2... et sans doute

Jason-3.

L'installation à Genève, au sein de l'OMM, du Bureau du projet GEOSS (Global

Earth Observation System of Systems)suffira-t-elle

à accélérer un engagement à long terme des gouvernements, tel que le préfigure

pour l'Europe, le programme GMES (Global Monotoring for Environment and

Security) ? C'est ce que nous souhaitons !

A l'invitation du CNES et de l'ESA, trois membres du club ont participé à ce Symposium

passionnant : F. Barlier, M. Lefebvre, et R. Zaharia.

Mois de Mars 2006

1/4 - Première estimation de l'impact qu'aurait l'ETM (OTEC) sur la structure thermique de l'océan

Un universitaire américain de l’Hawaii Natural Energy Institute, Gerard.Nihous, vient de publier, les résultats d’une modélisation simplifiée d'une exploitation intensive de la ressource ETM (Énergie Thermique des Mers).

Comme tout procédé industriel appliqué à grande échelle, l'exploitation de l'ETM peut avoir un impact sur l'environnement. Cette question vitale comporte deux aspects : la quantité d'énergie raisonnablement exploitable et l'évaluation de son impact sur la structure thermique des masses océaniques.

C'est pourquoi, de son côté, le Club a débuté depuis quelques mois une réflexion sur la définition d'un programme de recherche, conjuguant analyses théoriques et modélisations numériques en vue de déterminer de manière crédible les risques de perturbations de l'océan et les seuils à ne pas dépasser. Ce programme prendrait pour exemple les travaux du GIEC.

Qu'il s'agisse des travaux d'Hawaii ou de ceux du Club, une même question fondamentale est abordée : Quelle fraction de nos besoins, l'Énergie Thermique des Mers pourrait-elle satisfaire sans perturber l'environnement, c'est à dire sans nuire aux besoins des générations futures?

La consommation en énergie de nos "sociétés industrielles" atteint aujourd'hui des valeurs telles que l'état de la biosphère et les cycles qui s'y déroulent sont perturbés. Rappelons que l'exploitation des énergies fossiles a conduit à injecter dans l'atmosphère plusieurs centaines de milliard de tonnes de gaz carbonique, soit une augmentation de 30% en 150 ans.

Faute de moyens, l'étude de Gerard Nihous ne concerne que les modifications de la structure thermique de l’océan, sans aucune considération pour leurs conséquences écologiques.

L’exploitation de ce modèle montre que le fonctionnement d'une flottille de plusieurs milliers d'usines entraînerait un lent réchauffement de la source froide (profondeur de 1000 mètre et température de 5°C). La capacité de production passerait alors par un maximum au delà duquel l’écart des températures entre la source chaude (25°C) et la source froide (8°C au lieu de 5°C) deviendrait insuffisant et tout ajout d’usines serait «contre productif»: il entraînerait une réduction de la production ! A titre d’exemple avec une source chaude à 25°C, ce seuil serait atteint après une dizaine d’année de fonctionnement continu d’une flottille d'usines ETM d'une puissance globale de 3 TW. Cette puissance représente une capacité de production annuelle proche de la demande mondiale d'électricité pour 2020, estimée par l'IEA à 25 800 TWh électrique.

Ce résultat préliminaire n'est pas étonnant, si l’on songe que le procédé ETM requiert un débit d'eau froide d'environ de 2,5 mètres cubes/secondes et par MW produit. C’est donc un upwelling artificiel de plus de 7 Sverdrup que cette flottille exigerait pour fonctionner. Ce qui est d’un ordre de grandeur approchant celui des upwellings naturels !

La publication de G.Nihous montre, s'il en était besoin, l'intérêt des recherches sur les flux naturels de matières et d’énergie dans l’océan qui sont au cœur de l'océanographie physique.

Comme le montrent les travaux du GIEC (IPCC), les possibilités offertes par les modèles numériques d'océan ou d'atmosphère (éventuellement couplés entre eux), permettent désormais d'évaluer l'impact des activités humaines sur la biosphère. En outre, l'introduction de paramètres biologiques dans ces modèles devrait permettre à terme de combler la lacune mentionnée ci-dessus (aucune considération des conséquences écologiques).

A noter que l'impact de l'ETM sur l'environnement pourrait ne pas être seulement un objet d'inquiétude : outre sa contribution «énergétique», une exploitation «intelligente» des effluents d’eau froide à des fins biologiques, voire climatiques, sont évoquées par un autre chercheur américain, dans une communication à l’Unesco sur la "Blue Revolution". (Document de Patrick Takahashi "The Potential and Realities of Ocean Thermal Energy Conversion (OTEC)").

C'est l'une des perspectives du programme de recherche sur les upwellings artificiels auquel le Club réfléchit en espérant que les organismes de recherche prendront le relais, dans le cadre d'une coopération forcément internationale, compte tenu de la nature globale de ce défi.

2/4 - Nautilus IV, La Terre vue du Ciel

Le quatrième numéro du

magazine Nautilus est sorti.

Le quatrième numéro du

magazine Nautilus est sorti.

Le thème principal : La mer vue du ciel.

Dossier en coopération avec le CNES.

Articles de deux Argonautes : Michel Lefebvre et Bruno Voituriez, sur l'observation des océans par satellite.

De magnifiques images.

3/4 - Bonne nouvelle, feu vert pour Cryosat 2

Le 9 octobre dernier, une avarie du lanceur Rockot, a entraîné la perte du satellite d'observation de la Terre Cryosat.

Conscients de l'enjeu de la mission de ce satellite pour l'étude du changement climatique, les États membres de l’Agence Spatiale Européenne (ESA) ont décidé le 24 février dernier, la fabrication et le lancement d'un deuxième satellite, Cryosat-2. L'objectif de mise sur orbite est mars 2009.

Ce satellite est spécialement conçu pour évaluer avec précision, les modifications des épaisseurs des glaces continentales (2 mm/an) et des glaces de mer (2 cm/an). En complément aux mesures actuelles par satellite ou terrestre, elles viendront alimenter de nombreuses équipes de recherche par le monde qui travaillent sur la compréhension des phénomènes polaires, influence de l'homme, activité solaire.

Il fera partie d'une flottille de satellites EOS lancés et à lancer par la NASA et l'ESA, spécialisés chacun dans un domaine d'observation de la Terre.

Le métier du spatial est difficile et risqué. Le développement et la fabrication de Cryosat avaient coûté 136 millions d'euros et duré 5 ans. Compte tenu de l'expérience acquise Cryosat 2 bénéficiera des développement antérieurs, sa fabrication demandera 3 ans et son coût devrait être moindre.

De l'intérêt des mesures permanentes....

Image credit: NASA/Wallops

Image credit: NASA/Wallops

Une étude récemment publiée par le Jet Propulsion Laboratory de la NASA montre que la fonte des glaces au Groenland a doublé ces dix dernières années.

Les glaciers coulent directement dans l'océan et contribuent à l'augmentation du niveau de la mer (l'autre facteur étant la dilatation).

Des résultats sur dix ans ont été obtenus grâce aux moyens satellitaires. La vitesse de la glace a été mesurée grâce aux satellites ERS 1&2 et ENVISAT de l'Agence Spatiale Européenne ainsi qu'au satellite Radar-sat1 de l'Agence Spatiale Canadienne.

Cette photo du glacier de Helheim dans le sud-est du Groenland, prise en mai 2005, montre le front de détachement dans l'océan. Ce glacier est un de ceux dont l'écoulement est le plus rapide au monde.

Pour en savoir plus sur Cryosat 2 :

4/4 - Le 40° anniversaire des premiers lancements de satellites français a fait l'objet de diverses commémorations

Entre Novembre 1965 et Février 1966, puis en Février 1967 étaient lancés cinq satellites, dont trois au moins -Diapason et les deux Diadème - étaient destinés à faire des mesures de position et de vitesse (du satellite sur son orbite ainsi que de stations sol par rapport au satellite).

Ils ont permis des progrès spectaculaires des méthodes et instruments de la géodésie spatiale avec une connaissance toujours plus précise de l'orbite ouvrant la voie aux applications à la géodésie au profit notamment de la navigation et de l'altimétrie.

On peut les considérer comme les ancêtres d'Argos, de Doris, de Topex-Poseïdon, des Jason, et même de... Galileo.

Mois de Février 2006

1/2 - Combien de poissons dans l'océan demain?

Mercator-Océan se prépare à intégrer une dimension biologique dans la production des ses bulletins de prévision de l'océan.

Aujourd'hui, Mercator-Océan maîtrise une prévision opérationnelle de l'état et de la dynamique de l'océan grâce aux simulations numériques de ses modèles physiques.

En outre, l'équipe projet et le Groupe Mission

Mercator-Coriolis ont su comprendre assez tôt l'importance des paramètres

biologiques des océans, ce qui permet d'envisager une gestion durable des

ressources marines.

L'intégration d'une composante biologie marine dans les modèles d'océanographie physique est en cours et permettra de répondre à de nouveaux besoins.

Prévoir l'évolution des zones de production primaire dont dépend l'alimentation humaine et même qui sait peut être un jour, transformer certaines provinces océaniques désertiques en zone poissonneuses, toutes questions pour lesquelles des modèles biologiques couplés à la physique seront un atout, sans oublier bien entendu la modélisation du climat et le rôle décisif du vivant, peu pris en compte aujourd'hui.

2/2 - L'énergie Thermique des Mers mise à l'écart en Europe

Un séminaire Franco Britannique sur les énergies marines a eu lieu les 19 et 20 janvier 2006 au Havre.

Pourquoi Franco Britannique ?

Parce que, lors du sommet franco-britannique du 18 novembre 2004 les gouvernements français et britannique ont reconnu leur intérêt commun dans ce domaine en affirmant « le rôle déterminant que le développement des énergies renouvelables jouera dans la lutte contre le changement climatique. »

Pourquoi les énergies Marines?

Parce que, en tant que nations maritimes, les deux pays disposent d’un potentiel important pour exploiter ces sources d’énergie. Les énergies marines sont renouvelables et permettent de répondre aux exigences du Protocole de Kyoto, par exemple, pour la France, une production d'électricité d'origine renouvelable de 21 % de la consommation 2010 (contre 14 % actuellement).

Le colloque a traité exclusivement des énergies liées aux vagues, aux courants et aux marées, l'énergie thermique des mers n'étant pas inscrite au programme.

On peut regretter le choix initial d'ignorer le procédé de production d'électricité basé sur l'Énergie Thermique des Mers qui n'a même pas été mentionné (pas plus que l'utilisation de l'eau froide profonde pour la climatisation des édifices).

En effet, les calculs montrent, que la comparaison des contributions respectives des énergies marines sont largement en faveur de l'énergie thermique des mers.

Voir notre article Calcul des potentiels exploitables ...

Rappelons la conclusion :

La production annuelle d’énergie primaire que l’on pourrait

extraire des énergies marines serait de l’ordre de 120 000 TWh

d’électricité. Ceci est équivalent à la totalité de l’énergie primaire

consommée par l’humanité en l’an 2000 (et environ 10 fois la consommation

annuelle d’électricité des pays de l’OCDEqui était de 10 000 TWh en 2000 avec 15 % de

production renouvelable, pour l’essentiel d’origine hydraulique).

Les contributions théoriques maximum des différents procédés seraient de :

- 800 TWh pour l’énergie des marées,

- 1 400 TWh pour celle de la houle,

- 18 450 TWh pour l’énergie éolienne,

- 100 000 TWh pour la conversion par ETM.

Les USA, l'Inde et le Japon, l'Australie seront-ils les seuls à s'intéresser à l'ETM ? (OTEC en anglais).

Voir à titre d'exemple le projet Australien :

La position US :

Un site de nouvelles sur l'OTEC :

World Energy Concil

Nous laissons aux lecteurs le soin d'apprécier ce texte de Jules Vernes, dans son livre Sans dessus dessous :

"Qu’un Lesseps propose quelque jour de creuser un canal à grande section à travers l’Europe et l’Asie, depuis les rives de l’Atlantique jusqu’aux mers de la Chine, qu’un puisatier de génie offre de forer la terre pour atteindre les couches de silicates qui s’y trouvent à l’état fluide, au-dessus de la fonte en fusion, afin de puiser au foyer même du feu central, qu’un entreprenant électricien veuille réunir les courants disséminés à la surface du globe, pour en former une inépuisable source de chaleur et de lumière, qu’un hardi ingénieur ait l’idée d’emmagasiner dans de vastes récepteurs l’excès des températures estivales pour le restituer pendant l’hiver aux zones éprouvées par le froid, qu’un hydraulicien hors ligne essaie d’utiliser la force vive des marées pour produire à volonté de la chaleur ou du travail que des sociétés anonymes ou en commandite se fondent pour mener à bonne fin cent projets de cette sorte! ce sont les Américains que l’on trouvera en tête des souscripteurs, et des rivières de dollars se précipiteront dans les caisses sociales, comme les grands fleuves du Nord-Amérique vont s’absorber au sein des océans."

Mois de Janvier 2006

1/2 - TOPEX-Poséïdon: 13 ans de mesures de haute précision...

Image

Nasa

Image

Nasa

"The End of An Era. The venerable Topex/Poséïdon takes it last bow" (NASA)

"Après 13 ans d’observation continue des océans, le satellite Topex-Poséïdon tire sa révérence" AVISO

La mission de Topex/Poséïdon s'est terminée ce 5 janvier 2006 après la défaillance d'une roue à inertie indispensable à sa stabilisation. En dépit des prouesses auxquelles les ingénieurs du JPL (Jet Propulsion Laboratory de la NASA) nous ont habitués, il n'a pas été possible d'y remédier.

Avec un enthousiasme bien compréhensible, Le Club des Argonautes a déjà vanté les mérites de cette mission au succès sans précédent :

Trois cent

millions de lieues au-dessus des mers

Quinze ans d'altimétrie radar par

satellite. Venise Mars 2006

Aussi... est-ce avec satisfaction que nous avons appris, l'approbation par le

CNES, le 9 décembre, du lancement du programme Franco-Indien AltiKa : altimétrie

radar à une fréquence de 35 GHz pour l'étude de la circulation océanique qui

sera opérationnel en 2008 sur un satellite indien Oceansat3.

Le programme AltiKa s'inscrit dans la suite des "systèmes altimétriques

couplés" représentés par les missions complémentaires "TOPEX-Poséïdon +

ERS1&2" (de 1992 à 2002) , puis par "Jason-1 + Envisat", à partir de

2002.

Avec le futur Jason-2, (aussi appelé OSTM : Ocean Surface Topography

Mission...), il constituera la 3ieme génération de ces "couples de rêve", tels

que les chercheurs et ingénieurs du CNES et de la NASA les ont recommandés en

1991, dans un "Livre blanc" sur l'altimétrie spatiale (le "Purple Book"!),

remarquable par sa vision à long terme, formulée alors que les rapports du GIEC

et la nécessité de disposer de séries temporelles sur le climat étaient encore

peu connus...

Malheureusement, la continuité des observations entre Jason-1 et Jason-2 est

fragilisée par le retard pris par Jason-2 qui, dans un monde idéal, aurait

du être lancé en 2006, de façon à garantir l'inter-étalonnage de ce système de

haute précision avec son prédécesseur Jason-1 (lui même recalé, au cours des 8

premiers mois de sa mission, avec "l'ancêtre TOPEX-Poséïdon"...)

Souhaitons que Jason-1 connaisse, lui aussi, une longévité record, de façon

que la série climatique, homogène et bien étalonnée, entamée en 1992, ne soit

pas interrompue ! La capacité des modèles numériques d'évolution du climat

à reproduire, au moins en partie, la carte des variations du niveau moyen des

mers sur plus de 15 ans peut être un test décisif du réalisme de ces

modèles.

Nous évoquons souvent l'importance de la "continuité des moyens d'observations"

pour la connaissance de l'évolution de notre Planète (Voir notre rubrique "Géonautique"). A cet

égard, les systèmes spatiaux sont les seuls à pouvoir nous offrir des mesures

précises, et homogènes sur la Terre entière.

Mais, aujourd'hui, rien ne garantit la permanence de ces observations de

l'océan et du climat ! Les sondages atmosphériques, eux, sont effectués "en

routine": l'arrivée d'un nouveau responsable, par exemple à l'Office

Météorologique chargé de les faire, ne peut avoir pour effet de retarder ou

d'interrompre cette activité... Lorsque nous réussirons à faire en sorte que de

précieuses séries temporelles ne soient plus tributaires d'un changement dans

telle ou telle Agence Spatiale, la Géonautique, (et sa conséquence naturelle...

"la Géoscopie"), sera devenue une réalité !

De même qu'il existe des institutions nationales pérennes , réunies au sein de

l'Organisation Météorologique Mondiale, pour garantir la prévision météo,

(c'est la "Veille Météorologique Mondiale, la VMM"...), de même,

il sera nécessaire que de telles institutions nationales se créent pour "océan

et climat" et assurent à leur tour une VMOC "Veille Mondiale Océans et

Climats" (notamment pour permettre que le débat sur le changement

climatique se fonde davantage sur des mesures que... sur des croyances !). Il

est vrai que la VMM, poussée par la nécessité de créer des réseaux mondiaux et

des procédures d'échanges des observations de l'atmosphère, a fait ses preuves

depuis plusieurs décennies.

Les propos tenus en 1994 par notre collègue de la Météo, Claude

Pastre, n'ont pas pris une ride !

"Une liste d'instruments ne constitue pas un système ! Il ne fait aucun

doute que les agences spatiales opérant de par le monde soient capables de

faire développer tous les instruments dont a besoin la recherche scientifique

sur le climat. On peut même penser qu'il y a de bonnes chances qu'elles en

fassent voler des prototypes prochainement sur des plates-formes

expérimentales; mais il y a loin d'une collection d'instruments prototypes à un

système d'observation. Il faut rajouter deux choses au moins :

un concept de système qui assure la cohérence de toutes les parties pour obtenir un tout capable de remplir une mission prédéfinie, et

un engagement de continuité qui fasse que l'on dispose d'une série de mesures sur quinze à vingt ans pour être dans les ordres de grandeur des phénomènes auxquels on s'intéresse.

Ces aspects, s'ils sont à peu près acquis en météorologie,

commencent à peine à être abordés en matière de climat. On ne voit pas trop

aujourd'hui comment ces difficultés seront surmontées car, pour l'instant,

aucun organisme ne s'est vu confier la mission de surveiller les évolutions du

climat: disposer d'un système d'observation du climat, c'est assurément

l'affaire de tous ... est -ce une bonne raison pour que cela ne soit de la

responsabilité de personne ?"

12 ans plus tard, des initiatives telles que "Global Earth Observations System

of Systems" (GEOSS), et son volet

européen GMES, préfigurent, (après GOOS et GCOS), cet avènement nécessaire de

la "Geoscopie". Cependant leurs différents éléments continuent à être financés

en grande partie comme "de la Recherche", (c'est le cas d'AltiKa).

Reconnaître qu'il s'agit désormais d'une activité opérationnelle, c'est tout

l'enjeu de la transition, toujours délicate, de la Recherche aux

Applications ! Autre facteur critique: reconnaître que cette activité d'intérêt

général ne peut fonctionner sans financement public !

Un accord international, comme pour la météorologie ou la navigation aérienne, devient une urgence !

Comme l'a dit le poète Rafael Alberti: "Il est des portes sur la mer qu'on ouvre avec des mots !"

2/2 - Rêves de Géonautes...

Dans son numéro spécial 196 de Janvier 2006, sur les "9 rêves pour changer le monde", le magazine Science et Vie Junior consacre deux pages aux travaux de John Craven au Natural Energy Laboratory of Hawaï Authority : le NELHA dont il fut l'un des promoteurs.

John est le fondateur de "Common Heritage Corporation", une compagnie privée

dédiée aux applications commerciales de l'eau froide profonde que l'on peut

pomper dans l'océan tropical. Par exemple, le procédé dit "Énergie Thermique

des Mers", l'ETM, qui permet de produire de l'électricité.

John est un vieil ami des Argonautes : on voit sur la photo un des membres du Club dégustant au NELHA une fraise cultivée par un procédé d'irrigation que John avait imaginé il y a plus de 20 ans déjà.

Si vous êtes intéressés par l'ETM et les innovations similaires : les DOWA - "Deep Ocean Water Application"- nées de son imagination et qui pourraient contribuer "à changer le monde" visitez aussi :

Pour en savoir plus sur l'ETM :

Pour en savoir plus sur les travaux de John Craven :

IOA Newsletter Vol.9,No.4/Winter 1998

IOA Newsletter Vol.5,No.1/Spring 1994

Les fraisiers de John Craven sont

irrigués par la condensation de la vapeur d'eau de l'air tropical sur la

surface de tubes déployés dans le sol, et dans lesquels circule de l'eau froide

profonde. Les racines au froid et les feuilles chauffées au soleil d'Hawaï, les

fraisiers produisent des fruits beaucoup plus sucrés que ceux cultivés

"normalement" .

Les fraisiers de John Craven sont

irrigués par la condensation de la vapeur d'eau de l'air tropical sur la

surface de tubes déployés dans le sol, et dans lesquels circule de l'eau froide

profonde. Les racines au froid et les feuilles chauffées au soleil d'Hawaï, les

fraisiers produisent des fruits beaucoup plus sucrés que ceux cultivés

"normalement" .