Les News

Mois de décembre 2007

1/2 - Bali, le verre à moitié vide, à moitié plein

La réunion annuelle de la conférence des parties à la Convention de Rio sur le changement climatique qui s’est tenue durant la première quinzaine de décembre 2007 à Bali revêtait une importance particulière. Le protocole de Kyoto, mis au point il y a dix ans au cours d’une réunion du même type, couvre en effet la période 2008-2012 et pour important qu’il soit en tant que premier accord international de réduction des émissions de gaz à effet de serre, il est très insuffisant pour assurer la maîtrise à long terme de ces émissions. Son prolongement est donc à l’ordre du jour et une décision à ce sujet est urgente : il aura fallu 7 ans pour que le protocole de Kyoto soit ratifié par suffisamment de pays pour entrer en vigueur.

Le Groupe Intergouvernemental sur l’Évolution du Climat avait

programmé la réalisation de son 4ème rapport d’évaluation de façon à ce qu’il

soit disponible sous sa forme définitive avant la conférence de Bali. Ce

rapport dont toutes les composantes ont été approuvées à l’unanimité des pays

membres confirme le rôle des gaz à effet de serre dans

le réchauffement climatique observé et indique clairement que seule une diminution de l’ordre d’un facteur 2 des émissions

mondiales de ces gaz d’ici à 2050 peut permettre de limiter l’augmentation de

la température mondiale à 2 ou 3 °C, soit la moitié de celle qui

sépare une ère glaciaire d’un optimum interglaciaire et qui provoque un

bouleversement de la géographie mondiale (avec par ex. une variation de

quelques 80m du niveau des océans).

On aurait donc pu légitimement espérer que la Conférence de Bali aurait

débouché sur des engagements concrets de réduction des émissions.

L’inclusion dans le texte de la décision d’objectifs à moyen et long

terme, (fourchette de réduction de 25 à 40% des émissions d’ici 2020 pour

les pays développés, pic des émissions mondiales dans les 10-15 prochaines

années et réduction d’au moins 50% d’ici 2050), était souhaitée par l’Union

européenne et acceptée par l’ensemble des pays ayant ratifié le protocole de

Kyoto. Elle s’est heurtée à l’opposition des États-Unis et seul un

renvoi en note de bas de page aux pages importantes du rapport du GIEC a été

possible. De ce point de vue, le résultat de Bali est donc très décevant.

Cependant, le verre n’est pas entièrement vide : la «Feuille de route de

Bali» qui met en place un processus de négociation du régime de lutte

contre le changement climatique post-2012 constitue une base suffisamment

détaillée et cohérente pour permettre le lancement du cycle de

négociations, elle fixe :

les thèmes à traiter (vision partagée y compris un objectif global à long terme pour les réductions d’émissions, quatre blocs de négociation : atténuation, adaptation, technologies, financement),

une enceinte de négociation réunissant toutes les parties (groupe ad hoc de la convention)

un rythme de rencontres (4 par an)

et une date butoir (2009).

La prochaine Conférence des Parties à la convention et réunion des Parties au protocole de Kyoto se tiendra en décembre 2008 à Poznan (Pologne) pendant la présidence française de l’Union Européenne. Il est important de noter que les élections américaines auront lieu en novembre 2008 et que la négociation finale se fera avec une nouvelle administration en 2009, en vue d’une adoption par la Conférence des Parties qui se tiendra en fin d’année.

2/2 - GEO : Sommet ministériel sur l’Observation de la Terre - Quatrième réunion en novembre 2007

La conférence de Bali l'a encore démontré début décembre: la

question d'une "gouvernance globale" pour traiter de questions vitales

pour l'avenir de l'espèce humaine, (comme par ex. la modification de la

composition chimique de notre atmosphère...), demeure le sujet d'intenses

débats et peut encore paraître une utopie lointaine !

Cependant, depuis plusieurs années, il existe au niveau international des

instances, regroupant des Agences Spatiales, ou des services Météo et des

Instituts de recherche sur le climat, (certes basées sur le "volontariat

et... le Best Effort") dont l'évolution récente constitue un signe encourageant

en matière de gouvernance globale.

Divers Comités, (tels que CEOS/IGOS, GCOS, GOOS), ont été établis, plutôt par "spécialité

professionnelle" (Espace, Climat, Océan... certains depuis plus de 20 ans); ils

ont en commun le besoin de systèmes d'observations, (in Situ ou à

distance...), globaux, permanents, et "inter opérables"!

Ces instances fonctionnaient de façon autonome avec, au delà de

relations inter-personelles entre scientifiques ou ingénieurs en général

excellentes... la nécessité de créer de multiples interfaces entre systèmes

complexes... interfaces qui deviennent vite autant de sujets de coopération ou

de... compétition entre les organisations nationales ou internationales

concernées ! (il n'est d'ailleurs pas exclu que le néologisme

"coopétition", devenu si quotidien, ait d'abord été employé, par un

futur argonaute... à propos de cette situation !)

Les autorités politiques au niveau mondial ont décidé

d'aller plus loin.

Après la réunion du sommet mondial du développement durable à Johannesburg en

2002, puis la réunion du G8 à Evian en 2003, prenant conscience de l’importance

de la question de l’observation de l’évolution de notre environnement, elles

ont convenu de rassembler en 2003 à Washington, un «Earth Observation Summit -

EOS». Celui-ci a mis en

place un «Group on Earth Observations - GEO» et lancé une

action destinée à réaliser un «Global Earth Observation System of Systems -

GEOSS».

Une semaine avant la réunion de Bali, s'est tenu au Cap, en

Afrique du Sud, le "quatrième Sommet ministériel du Groupe d’observation de

la Terre GEO". Sans atteindre l'ampleur du forum de Bali, cette réunion

rassemblait tout de même les délégations de 73 pays et 52 organisations

internationales !

Le Sommet avait pour objectif d’établir un premier bilan du plan, élaboré au

cours du précédent sommet en 2004 à Bruxelles, en vue de développer d'ici 2014,

un "Système de Systèmes d’Observation de la Terre" (GEOSS).

Une assemblée plénière du GEO, réunie les 28 et 29 novembre

2007, ainsi qu’une exposition ont permis, à la fois de faire état des premières

réalisations concrètes et de cerner les réseaux d’observations pérennes

terrestres, océaniques, aéroportées et spatiales indispensables pour les prises

de décisions en matière de gestion de la planète.

Au cours de la première phase de GEO, 106 projets à 2 ans ont été engagés et

menés, pour la plupart, à bien.

Ils couvrent les 9 domaines correspondants à des besoins sociétaux identifiés :

risques,

santé,

énergie,

climat,

eau,

météorologie,

écosystèmes,

agriculture,

biodiversité.

En parallèle, 100 réalisations effectives sont à mettre au crédit des pays membres et des organisations internationales. Il s’agit, dans de nombreux cas, d’inscrire dans la perspective de GEO des actions déjà engagées auparavant, tel le système ARGO de bouées océanographiques ou encore le système PREV’AIR de prévision de la qualité de l’air.

Le fait de placer ces efforts dans le cadre de GEO traduit la volonté de mutualiser les moyens disponibles au profit de l’ensemble de la communauté utilisatrice.

Parmi les projets mis en oeuvre spécifiquement pour GEO, on peut noter la

mise en service de GEONETCast, un

réseau de diffusion par satellite d’observations (météorologiques,

océanographiques, environnementales...), à l’échelle de la planète, accessible

à l’aide d’un équipement très simple et peu coûteux (une antenne satellite et

un récepteur).

La déclaration adoptée par l’ensemble des états membres de GEO

fait état de l’engagement des pays membres pour développer l’interopérabilité

des moyens d’observation et fournir l’accès aux données et aux systèmes de

prévisions et d’information associés, dans le but d’aboutir à la réalisation

totale du plan de mise en oeuvre à 10 ans décidé en 2004.

Voir aussi les FAQ :

Mois de novembre 2007

1/1 Bientôt un site ETM expérimental dans les DOM/TOM?

Après avoir été négligée pendant plusieurs décennies, l'ETM revient enfin dans le "Top 5" des

énergies marines souvent citées dans la presse, soit au niveau de l'action

gouvernementale, soit dans celle des Régions Ultra-périphériques, comme

on dit à Bruxelles, notamment ces territoires ultra marins, que sont

certains DOM-TOM.

Ceux qui ont suivi l'action du Club depuis 4 ans savent combien les

Argonautes ont de raisons de se réjouir de cette "re-connaissance..." de

l'ETM, ce moyen de production d'eau douce et/ou de kWh, renouvelables et non

intermittents, cette ressource au potentiel considérable, dont notre pays a été

le pionnier, ainsi que cela apparaît sur de nombreuses pages de ce site.

En effet, les procédés et les technologies nécessaires à son exploitation sont connus depuis les années 30, grâce aux expérimentations du français G.Claude.

Les travaux plus récents réalisés principalement aux États-Unis et au Japon en confirment à la fois la faisabilité technique, les bénéfices environnementaux, et le potentiel économique.

Cette ressource située dans la zone intertropicale ouvre dès à présent des perspectives de développement pour les territoires et département d’outre-mer français.

La France s’est malheureusement mise hors jeu des travaux de R&D, après l’abrupt abandon du projet de la centrale de Tahiti en 1987.

Aussi nous réjouissons nous des derniers événements sur le

sujet.

Le premier est la question formulée (News Juin 2007) par

l’Institut de la Mer au candidat Sarkozy, à l’occasion des élections

présidentielles :

"Quelles perspectives de développement des activités maritimes de l’Outre-mer français voyez-vous dans les cinq prochaines années ?"

et sa réponse :

"La mer tropicale est également une source majeure d'énergies renouvelables,

malheureusement inexploitée aujourd'hui. Leur développement passe par une

recherche appliquée pertinente sur l'éolien offshore, sur l'hydrolien, et

surtout sur l'énergie thermique des mers, actuellement ignorée."

Ignorée plutôt que négligée ? Qu’importe le terme puisque le candidat

Sarkozy a compris l'enjeu pour augmenter la part des énergies renouvelables

Outre-Mer !

Le second événement est l’annonce de Christian ESTROSI dans un communiqué

Grenelle Environnement en date du 25/10/2007, qui mentionne «un

Outre-Mer exemplaire» et «En Polynésie française, des

recherches sont entreprises dans le domaine de l’énergie thermique des

mers» (après avoir parlé initialement de "La création

prochaine d’un pôle de compétitivité sur l’énergie thermique des mers en

Polynésie française).

Enfin, le troisième événement est la présentation des résultats de l’étude

NRJRUP. réalisée dans le cadre du programme

DOCUP 2000-2006. Cette étude confiée à la

Région Martinique visait à identifier les potentiels énergétiques issus des

ressources marines pour produire de l’électricité dans les Régions Ultra

Périphériques d’Europe (RUP) : Martinique, Guadeloupe, Guyane , Réunion ,

Açores ,Madère ,Canaries.

Réalisée sur financement de la Commission Européenne, la présentation de ses

résultats s’est faite lors d’un séminaire tenu à Fort de France du 23 au 25

octobre 2007 qui réunissait des élus, des représentants d’institutions

publiques et des entrepreneurs.

Outre l’éolien offshore, la houle et l’hydrolien, il

fut aussi beaucoup question de l’ETM qui aurait notamment été reconnue comme

"la filière la plus appropriée pour la Martinique et la

Guadeloupe" et "à considérer pour la Guyane et la Réunion".

Outre l’éolien offshore, la houle et l’hydrolien, il

fut aussi beaucoup question de l’ETM qui aurait notamment été reconnue comme

"la filière la plus appropriée pour la Martinique et la

Guadeloupe" et "à considérer pour la Guyane et la Réunion".

Les candidats DOM&TOM sont donc nombreux à vouloir contribuer au développement des technologies pour l'exploitation de la ressource ETM. Ce passage d'un niveau d'activité comparable à celui d'un "cimetière des bonnes intentions" à un sympathique foisonnement de propositions est en lui-même prometteur. Le Club des Argonautes souhaite qu’une décision soit rapidement prise pour passer à l’étape suivante : réaliser un pilote ETM de production d’électricité, éventuellement jumelé avec un incubateur d’entreprises valorisant les produits associés à l’utilisation des eaux froides profondes. (comme c’est le cas au NELHA à Hawaii et au Japon).

Reste à coordonner les différents efforts pour qu'ils servent au mieux, dans leurs régions respectives, de vitrine aux industriels français, dont certains furent d'historiques pionniers de l'ETM. D'après nos informations, il semble qu'une structure de liaison "ad hoc" se mette en place dans cette perspective... Si tel est bien le cas, le Club suivra avec la plus grande attention cette nouvelle aventure et informera les internautes des progrès réalisés.

Mois de septembre / octobre 2007

1/1 - 50 ans après Spoutnik et l'Année Géophysique Internationale... le "Grenelle de l'Environnement" peut contribuer à rappeler certaines évidences !

Le Club des Argonautes a lu avec intérêt les propositions issues du rapport du Groupe de Travail : "Lutter contre les changements climatiques et maîtriser l'énergie".

Les questions que soulève la démarche en cours sont nombreuses, et la liste de propositions qu'elle a produites... forcement incomplète.

On peut noter par exemple que l'Énergie Thermique des Mers, source d'énergie non carbonée, plusieurs fois évoquée ici ou là, mais in fine toujours absente, n'est pas mentionnée même à titre prospectif, pour les Départements d'Outre Mer, dont il est pourtant proposé de faire "une vitrine de l'excellence climatique".

De même, l'observation de la Terre n'apparaît qu'au titre de la recherche fondamentale sous la forme : "Extension et pérennisation des Observatoires de Recherche en Environnement (ORE)", alors qu'il faudrait mettre en place un véritable système d'observation globale au service d'un outil de pilotage de la Terre qui, bien entendu, dépasse les moyens limités de la recherche fondamentale et les objectifs des ORE, même si certains d'entre eux peuvent en être des éléments.

Globalement, force est de constater que la mer est peu présente dans les groupes du Grenelle de l'Environnement. Une fois de plus, le Club des Argonautes souhaite attirer l'attention sur un point essentiel :

La nécessité de disposer d'un système pérenne d'observation de l'ensemble du

système climatique et particulièrement de l'Océan Mondial.

En effet, ce dernier est une composante majeure du climat puisqu'il est le

principal "réceptacle" de l'énergie solaire. Il est, autant que l'atmosphère,

un agent de transport de chaleur, mais ses échelles temporelles de variation

imposent dans une large mesure le rythme des variations climatiques.

Même si la compréhension des processus en cause, et de leurs non linéarités, ne

cesse de progresser, la complexité de la machine Océan Atmosphère, (qui produit

le climat), résulte notamment de l'existence de phénomènes turbulents; de la

sorte, et comme en Météorologie, des observations globales et permanentes de

l'Océan Mondial sont et demeureront indispensables.

En matière de changement climatique, l'exigence "Comprendre pour agir"

ainsi que la méthode expérimentale chère à Claude Bernard, se déclinent ainsi:

"Observer Comprendre Prévoir, puis Continuer à... observer !"

Un argumentaire a été transmis à plusieurs personnalités

proches du Grenelle de l'Environnement. Son titre :

Poursuivre l'engagement français pour l'observation pérenne de l'Océan Mondial.

Mois de juillet / août 2007

1/2 Trois publications récentes parlent de l'ETM...

Dans la Revue Maritime de Juillet (*), la contribution de l'IFM au Livre Vert sur la Politique Maritime comporte le rappel suivant : "Ainsi la recherche sur l'Énergie Thermique des Mers engagée en France entre les années 20 et les années 70 a été arrêtée faute de moyens. Sa relance est aujourd'hui impérative bien qu'elle ne concerne que les eaux tropicales et les régions ultra-périphériques européennes et non le continent".

Dans "Sciences au Sud", le bulletin de l'IRD, (N°40 - Juin Juillet Août 2007), un article de Michel Gauthier reprenant le plaidoyer du Club ("Un avenir énergétique pour le Sud") et,

un Rapport de la DGEMP sur la stratégie nationale de recherche dans le domaine énergétique. (Mai 2007)

Page 70, on peut y lire: "L’énergie thermique : l’océan et la mer sont de gigantesques capteurs solaires. Dans la zone intertropicale de l’océan la différence de température entre la surface et le fond dépasse 20°C. Ce phénomène peut être exploité pour convertir une partie de la chaleur de l’eau chaude en énergie électrique", une phrase qui ne surprendra pas "nos abonnés" ! (et tous ceux qui visitent régulièrement ce site).

Ce qui est neuf... c'est de la voir dans un document officiel, suivie de la mention "Reprendre les travaux commencés en Polynésie" ! Signe que l'ETM est en train de passer de la catégorie... "énergies exotiques"... à la catégorie "Horizon à Long terme"! Un petit pas, mais... dans la bonne direction !! Surtout, si l'on se souvient que, lors du dernier colloque franco-britannique sur les énergies marines, l'ETM n'était même pas mentionnée ! (Il est vrai qu'il y a eu depuis... les réponses au questionnaire de l'IFM !)

Toutefois, les auteurs ne semblent guère avoir mis à jour leurs connaissances sur la situation des diverses filières, qu'il s'agisse de leurs potentiels respectifs, ou de la maîtrise des risques liés à leur exploitation. L'avis selon lequel "Les technologies de l’énergie des océans doivent résoudre deux problèmes essentiels : faire la preuve de la conversion des énergies marines en énergies exploitables et résoudre les risques techniques liés à la dureté de l’environnement" est certes frappé au coin du bon sens...

Mais il néglige le fait que le degré de réutilisation de technologies développées par ailleurs est variable d'une filière à l'autre : en ce qui concerne l'ETM, il s'agit d'une large part des progrès accomplis dans l'off shore profond avec, (comme l'indiquait déjà il y a 10 ans la DGEMP), de solides compétences industrielles en France.

De façon plus générale, on peut déplorer la timidité des tentatives pour renouveler les méthodes d'évaluation des avantages et inconvénients des diverses filières de production d'ÉNR (Énergies Nouvelles Renouvelables). Comment prendre en compte, par exemple, le fait qu'elles soient disponibles sans apport exogène de chaleur à "la source chaude", c.à.d. sans une pollution thermique qui, (sauf en cas de co-génération électricité + chaleur), représente, pour chaque KWh utile, environ... 2 KWh à dissiper ?

Les approches tendant à réconcilier économie et écologie, (voir par exemple, et entre autres, la "méthode ExternE"), tout comme la transition vers des indicateurs qui ne soient pas uni-dimensionnels, (avec des budgets établis pas seulement en Euros, mais aussi en Kwh, et en tonnes de carbone, et ce... sur l'ensemble du cycle de vie), dépassent "l'objet social" du Club. Cependant, comment ne pas souhaiter que l'un des "grands chantiers" qui sortiront, (peut être !), des futurs "États Généraux de l'environnement", (le "Grenelle"), porte sur "l'art" de produire des évaluations pertinentes et reproductibles, fondées sur des critères reconnus -au niveau européen de préférence- et appliqués de façon transparente ? Une condition nécessaire, (mais pas suffisante hélas !), pour faire de bons choix, n'est-elle pas d'avoir... de bonnes infos ? !

(*) Notons au passage que ce numéro de la RM comporte également un article de JP Guinard sur les vagues scélérates.

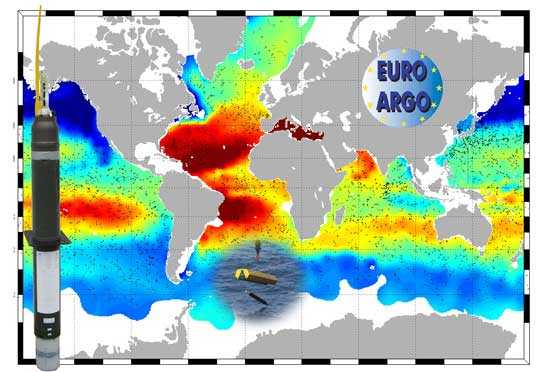

2/2 Euro-Argo : Vers une contribution pérenne de l’Europe au réseau global in-situ Argo

Communication de Pierre-Yves Le Traon - Responsable Programme Systèmes Opérationnels Hauturiers à l'IFREMER

Lancé en 2000 par la COI et l’OMM, le programme Argo a pour objectif de développer un réseau global de 3000 flotteurs profilants autonomes mesurant en temps réel la température et la salinité des 2000 premiers mètres de l’océan.

Argo est un élément essentiel du système global d’observation des océans mis en place pour suivre, comprendre et prévoir le rôle de l’océan sur le climat de la planète.

Près de 2900 flotteurs sont actuellement en opération dans tous les océans. En 2006, plus de 900 de ces instruments ont été mis à l'eau, soit le nombre nécessaire pour maintenir un réseau de 3000 flotteurs actifs.

Avec les observations des satellites, les données des flotteurs Argo sont la principale source d'information pour les chercheurs s'intéressant au climat et à l'océan, ainsi que pour les centres d'analyse et de prévision océanique.

La France est très active dans tous les aspects du programme Argo : centre de données, développement de l'instrumentation, mise à l'eau des flotteurs, analyses scientifiques et océanographie opérationnelle via le groupement Mercator Océan. La contribution française à ce programme est coordonnée au sein du projet inter-organismes Coriolis.

La première phase d’Argo est un succès remarquable. Pour la première fois, un véritable réseau global in-situ est mis en place. Vingt trois pays participent directement à la mise en place du réseau. De nombreux résultats scientifiques sur la caractérisation du réchauffement climatique et les changements à grande échelle de l’océan ont été obtenus ces deux dernières années et beaucoup plus sont attendus maintenant que le réseau est en place. Argo est devenu le complément indispensable des mesures satellitaires pour caractériser et comprendre les variations de l’océan. Les données sont également utilisées en routine par les centres d’analyse et de prévision océanique et pour la prévision saisonnière du climat.

Le programme Argo entre dans une nouvelle phase: La démonstration de faisabilité a été faite et il faut maintenant s’assurer que le réseau sera maintenu sur les 10 à 20 années à venir.

Une étape majeure a été franchie en Europe. En 2005 et 2006, en concertation avec ses partenaires internationaux et européens, Ifremer a coordonné l’élaboration d’un dossier Euro-Argo visant à développer une contribution européenne pérenne au réseau global Argo. A l’automne 2006, l’ESFRI a rendu officielle une liste de trente-cinq propositions de nouvelles infrastructures d’intérêt pan-européen dans sept secteurs clés de la recherche dont les sciences de l’environnement. Le projet Euro-Argo a été retenu ; à ce titre, il a pu participer à l’appel d’offres du 7ème PCRD sur les phases préparatoires des infrastructures de recherche.

La phase préparatoire Euro-Argo doit permettre de mettre en place les accords entre les pays membres (niveau ministériel) et la commission Européenne (bureau GMES) pour une contribution pérenne de l’Europe au réseau Argo. La contribution visée est de l’ordre de 250 flotteurs/an, soit environ 1/4 du réseau global avec un échantillonnage densifié au niveau des mers régionales Européennes. La phase préparatoire est coordonnée par Ifremer (qui représente ici le projet Coriolis) et elle regroupe 15 partenaires et 11 pays (France, Allemagne, Grande Bretagne, Italie, Espagne, Pays Bas, Norvège, Irlande, Grèce, Portugal, Bulgarie). Elle va démarrer dès l’automne 2007 pour une durée de 30 mois. Outre les aspects légaux, financiers et d’organisation, des travaux techniques sur des éléments critiques du système (centres de données, technologie des flotteurs, nouveaux capteurs) seront menés ainsi que des études visant à démontrer l’impact d’Argo pour la recherche et l’océanographie opérationnelle.

Le réseau Argo permet de suivre les variations à grande échelle des champs de température et de salinité des océans (ici la salinité à 100 m obtenue à partir d’environ un mois de données Argo en Février 2007).

Contact : P.Y. Le Traon

(pierre.yves.le.traon@ifremer.fr).

http://www.ifremer.fr/euro-argo/

http://www.coriolis.eu.org/

http://www.argo.net/

http://www.mercator-ocean.fr/

http://www.godae.org/

http://www.nersc.no/project/mersea

Le Club des Argonautes se réjouit de voir

pérennisé un élément vital de la "Veille Mondiale Océan et Climat", ce système

global d'observations depuis l'espace et in situ, (avec engagement des pouvoirs

publics dans les différents pays participants), dont, depuis plusieurs années,

il recommande la création, à l'image de ce qui existe déjà pour la Météo.

Voir notamment: http://www.clubdesargonautes.org..

Mois de juin 2007

1/1 ETM: un candidat bien informé...

Voici l'une des réponses au questionnaire de l'Institut Français de la Mer (question 12) transmise par l'un des 12 candidats a l'élection présidentielle:

"La mer tropicale est également une source majeure

d'énergies renouvelables, malheureusement inexploitée aujourd'hui. Leur

développement passe par une recherche appliquée pertinente sur l'éolien

offshore, sur l'hydrolien, et surtout sur l'énergie thermique des mers,

actuellement ignorée."

Le Club des Argonautes se réjouit de voir ce point de vue, (dont il s'est fait

l'avocat depuis sa création en Avril 2003), partagé par

l'un des candidats, et plus précisément... par celui qui a été élu !

L'océan est effectivement le principal réceptacle de l'énergie solaire reçue

sur Terre. Il en est aussi le plus grand réservoir. Dans la zone

inter-tropicale, on peut exploiter les différences de température entre la

couche superficielle chaude de l'océan (>25°C) et les couches profondes,

(quelques centaines de mètres), où la température est de l'ordre de 5°C.

Des expériences menées par la France entre les deux guerres et jusque dans les années 50, ont montré que cela fonctionnait.

Ainsi qu'on a pu le voir sur ARTE, à l'occasion de l'émission

du 25 mai consacrée aux énergies marines, des pays comme les USA et le Japon y

travaillent à nouveau. Pourquoi la France, qui fut pionnière en la matière,

et qui possède la plus grande zone économique maritime dans les régions

tropicales, laisserait-elle en friche une énergie renouvelable, non

intermittente, et dont les retombées: climatisation, production d'eau douce,

voire aquaculture, sont loin d'être négligeables ?

(*) voir question 12, pages 18 -19, sur l'Outre-Mer français

(Fichier Pdf de 200 Ko)

Mois de mai 2007

1/1 GIEC «Climate Change 2007» - Rapport du Groupe de Travail III

Les scientifiques et les experts gouvernementaux du GIEC, réunis à Bangkok, ont approuvé ce vendredi 4 mai la troisième partie du Quatrième Rapport.

Introduction

Le GIEC vient

de publier les résultats des travaux de son troisième groupe de travail–WG III. Ce groupe avait

pour mission de proposer, à l’intention des «décideurs», des solutions

pouvant contribuer à maîtriser de façon durable les émissions de gaz à effet de

serre.

Dans son rapport technique, le WG III dresse un inventaire de ces solutions et

de leurs domaines d’application : production d’énergie, transports,

construction des bâtiments résidentiels et commerciaux, industrie, agriculture,

sylviculture, et gestion des déchets. Il insiste en particulier sur le rôle

décisif des mesures qui seront prises pendant les 20 prochaines années.

Le GIEC fait aussi état de la possibilité d’interventions

globales sur la biosphère par des options non conventionnelles dites de

géoingéniérie qui visent non pas à maîtriser les émissions de gaz à effet de

serre mais à en réduire l’impact.

L’intérêt particulier du Club des Argonautes pour les relations entre le

Climat, l’Océan et l’Énergie, le conduit à ne considérer dans ce volumineux

rapport, malaisé à lire, que les options ayant un lien avec l’océan. Celles-ci

se trouvent aux chapitres 4 et 11, consacrés respectivement à l’énergie et à la

géoingénierie.

Ce que dit le GIEC sur les énergies marines

Au Chapitre 4.3.3.8, on lit que le potentiel de la ressource des

énergies marines (houle, marée, gradients thermique et halin, courant) est

«considérable» mais que son potentiel économique est «faible». Il est également

signalé que les contraintes particulièrement sévères de l’environnement marin

entraînent des coûts d’investissement élevés et, qu’à l’exception des usines

marémotrices, les technologies ne sont encore qu’à un stade de développement

comparable à celui de l’industrie des éoliennes des années 1980. Il est

également noté que le partage de l’espace entre les différents usagers du

domaine maritime demandera beaucoup de concertation.

Suivent quelques données chiffrées sur les potentiels de production des

filières houlomotrice et hydrolienne, avec parfois des références à des

sociétés privées.

Suit également un avis sur le besoin d’un financement mixte

public et privé pour aider ces technologies à accéder au marché.

Quant aux procédés de conversion des ressources du gradient thermique et du

gradient de salinité, les experts du GIEC estiment qu’ils en sont encore au

stade de la recherche et qu’il est trop tôt pour estimer leurs potentiels «techniques».

Ils ajoutent toutefois que certaines «applications» pour le conditionnement

d’air et la production d’eau douce pourraient être profitables aux nations

insulaires de la zone tropicale, là où l’énergie primaire fournie par des

centrales diesel-électriques est chère.

Les commentaires du Club :

Le Club se réjouit que le GIEC donne une place aux énergies marines dans son

«bouquet» d'énergies renouvelables susceptibles de répondre aux besoins

mondiaux en énergie propre, et que l’Énergie Thermique des Mers soit citée.

Depuis sa création le Club des Argonautes a été le promoteur assidu de cette

ressource abondante, non intermittente, renouvelable, et...

négligée.

Le Club constate que cet inventaire est incomplet. À ce stade très élémentaire

de l’information sur les énergies marines destinée aux «décideurs», le

GIEC aurait pu ajouter la production de biocarburant à partir d’algues,

cultivées dans des fermes marines. Il en est de même pour l’extraction de

combustibles nucléaires contenus, en faibles teneurs mais en grande quantité,

dans l’eau de mer. Des travaux expérimentaux ont été réalisés sur ces procédés.

Le Club relève aussi que le GIEC n’a pas pris en compte la spécificité des

technologies des éoliennes «offshore» et n’a pas inclus cette ressource dans

son inventaire des énergies marines, comme il est maintenant admis de le faire

dans la littérature spécialisée.

Enfin, le Club regrette que cet inventaire ne soit pas accompagné d’une étude

plus complète, mieux documentée et plus objective des avantages et

inconvénients des différentes filières. Ce chapitre consacré aux énergies

marines n’apporte pas les informations nécessaires pour répondre à l’objectif

du GIEC, qui est d’aider les «décideurs» à choisir les options les plus

efficaces pour contribuer au développement durable.

Ce que dit le GIEC sur les options de

géoingéniérie :

Au chapitre 11 page 4 de son rapport, le GIEC fait mention d’options non

conventionnelles offertes aux décideurs pour agir non plus séparément dans les

secteurs classiques de l’économie (transports, énergie, etc.), mais à un niveau

planétaire en utilisant des techniques dites de géo-ingéniérie.

Le GIEC évoque plusieurs possibilités dont deux concernent l’océan : soit

stimuler la production primaire de l’océan en y introduisant un fertilisant, ce qui aurait pour effet de

réduire la croissance de la teneur en dioxyde de carbone de l’atmosphère, soit

construire un bouclier d’écrans solaires dans la haute atmosphère pour réduire

le rayonnement intercepté par notre planète et donc par l’océan qui en est le

principal réceptacle.

Les commentaires du Club :

Il est rassurant de voir que l’Homme ne manque pas d’idées pour faire face à une situation critique. Mais le Club, en tant que promoteur du concept de Géonautique, s’interroge sur la pertinence de ces options, qui ne visent pas à réduire la perturbation initiale due aux émissions de GES, (priorité pour le Club), mais introduisent au contraire de nouvelles perturbations, pour tenter de minimiser l’impact de la première. Perturbations potentiellement irréversibles dont on ignore tout des effets qu’elles pourraient avoir sur le système climatique et les écosystèmes.

Toutefois, pour faire face à l'éventualité où les mesures

visant à la réduction des gaz à effet de serre GES s'avéreraient insuffisantes,

il convient de ne pas ignorer ces options non-conventionnelles et d'y consacrer

un certain effort de R&D, organisé et partagé au niveau international.

Dossier "Le Changement Climatique" : Les commentaires du Club où en est la

recherche ? (mai 2004)

XIV - Le Club pense qu’un

effort de recherche et de développement technique peut contribuer à la solution

des problèmes posés par le Changement Climatique.

XV- L'océan peut être une source d'énergie pour demain...

Working Group III Report "Mitigation of Climate Change",

release on 4 May 07 in Bangkok

SUMMARY

FOR POLICYMAKERS

Mois d'avril 2007

1/1 Une évolution notable du système de prévision océanique global de Mercator Océan.

Depuis octobre 2005, Mercator Océan dispose d'un système opérationnel de prévision océanique global (pour les initiés le PSY3V1). Ce modèle d'une résolution horizontale d'1/4° (26 x 26 km à l'équateur) et d'une résolution verticale de 46 niveaux, est guidé par les mesures des anomalies du niveau de la mer fournies par les satellites altimétriques (on dit qu'il les assimile), mais ne prend pas en compte les données de salinité et de température de surface.

Mercator vient de franchir une étape décisive dans la

complexité de ses systèmes avec la nouvelle version du modèle global

(PSY3V2)

Ce modèle de

même résolution horizontale, d'une résolution verticale de 50 niveaux,

assimile désormais non seulement les anomalies du niveau de la mer mais aussi

les températures de surface de la mer (données en provenance à la fois des

satellites et des bouées dérivant à la surface de l'océan) et les profils de

température et salinité provenant des mesures en mer (flotteurs Argo, bouées

ancrées, etc.).

Ce modèle de

même résolution horizontale, d'une résolution verticale de 50 niveaux,

assimile désormais non seulement les anomalies du niveau de la mer mais aussi

les températures de surface de la mer (données en provenance à la fois des

satellites et des bouées dérivant à la surface de l'océan) et les profils de

température et salinité provenant des mesures en mer (flotteurs Argo, bouées

ancrées, etc.). De plus, ce nouveau système met en oeuvre un modèle de glace couplé à un modèle d'océan qui permet de décrire l'évolution de la glace de mer à travers plusieurs paramètres tels que l'épaisseur de la glace et de la neige, la compacité (concentration), la dérive de glace et la température de la glace.

La prochaine étape prévue pou 2008 est le passage de la résolution horizontale à 1/12°.

Pour en savoir plus :

Bulletin en images Mercator :

http://bulletin.mercator-ocean.fr/fr/PSY4#3/75.50/-51.33

Dossier Océanographie Opérationnel - Modèle numériques

Mois de Mars 2007

1/1 GIEC: après l'analyse... le commentaire !

Que faire face aux incertitudes sur l'évolution du climat ?

Entendu sur une antenne de radio nationale, le 10 février à 14

H: "Le GIEC table sur un

réchauffement climatique de 1,1 à 6,4 °C d'ici 2100"...

Cette façon de présenter les conclusions du Groupe de Travail N°1, publiées

dans cette "1ere tranche" du 4ieme Rapport, est un raccourci: la réalité

est plus complexe. En effet, la fourchette d'incertitude sur les prévisions

2100 comporte 2 composantes:

d'une part, une connaissance imparfaite des mécanismes qui régissent les évolutions du climat. Les chercheurs utilisent le terme sensibilité climatique pour caractériser le comportement du système climatique, lorsqu'on augmente la teneur en Gaz à Effet de Serre, (GES, par exemple le CO2), de l'atmosphère. Le GIEC estime qu'un doublement de la teneur en GES dans la machine Océan Climat entraînera un réchauffement moyen à l'équilibre, (en situation stabilisée), qui se situe entre 2 et 4,5°C. La science du climat a pour objet, entre autres, de réduire cette incertitude.

d'autre part, la teneur en GES prévue pour 2100 dépend du rythme de nos émissions donc, des scénarios d'évolution économique, démographique, et technologique de l'humanité, soit en dernier ressort, du comportement plus ou moins "sage" de l'humanité.

Dans son 4ieme rapport publié début février 2007, conformément à la mission qui lui a été confiée, le Groupe 1 du GIEC ne s'occupe que des bases scientifiques du changement climatique. Il est donc amené à envisager divers scénarios (qu'il considère, pour le besoin de son étude, également probables).

Cependant, pour que le réchauffement moyen "Terre entière" demeure dans le bas de la fourchette d'incertitude, (qui s'étend de +1,1 à +6,4°, par rapport a la période 1980-1999), il est clair qu'il faut combiner l'hypothèse d'une faible sensibilité climatique et celle d'un ralentissement du rythme des émissions.

A l'autre extrême, se trouve le "pire cas 2100": celui d'émissions demeurant très importantes, combinées à l'hypothèse d'une forte sensibilité climatique ! Le Club juge nécessaire d'insister sur la nature différente de ces deux catégories d'incertitudes, et d'essayer de dessiner ce que pourrait être le climat du futur, selon que des mesures de limitation des émissions seront ou non prises.

En l'absence d'un nouvel accord international, (prolongeant et amplifiant le Protocole de Kyoto), les situations aboutissant à un réchauffement moyen en 2100 compris entre 1,1 et 3,8 degré (correspondant aux scénarios GIEC de "type B1 ou B2", soit une teneur en GES voisine de celle des annees 1990), sont évidemment MOINS PROBABLES que celles correspondant à un réchauffement moyen compris entre 2 et 6,4 degré (scénarios GIEC "type A2 ou A1FI" -ce qui veut dire Fossil Intensive- soit une teneur en GES de 3 a 4 fois sa valeur pré-industrielle).

En outre, bien qu'il n'existe que des connaissances partielles sur l'existence éventuelle de seuils dangereux, une part de la communauté scientifique considère qu'un réchauffement moyen limité à 2°C réduit le risque d'auto-amplification du réchauffement. En fonction de cette considération, diverses politiques dites "Facteur 4", (c a d la division par 4 des émissions des pays riches d'ici 2050), ont été formulées. (C'est le cas de notre Plan Climat actuel). Bien entendu, la valeur de 2°C, (pour conjurer ce que le Sénat appelle risque d'emballement climatique), est loin d'être intangible.

Enfin, compte tenu de leur capacité calorifique considérable,

les océans absorbent

près de 90 % des KWh excédentaires. Leur température de surface augmente

moins vite que celle des surfaces continentales; cet effet se combine avec les

variations régionales, (liées entre autres a la répartition géographique des

continents), de sorte que le réchauffement moyen est plus élevé dans

l'hémisphère Nord. Au total, un réchauffement MOYEN de 4° de la température de

surface peut signifier en réalité +8° sur certaines zones continentales (et

même +12° en zone arctique). C'est à dire, dujamais vu au cours

des 400 000 dernières années ! (au cours desquelles, les périodes les plus

chaudes, il y a 125 000 ans, ont vu un réchauffement moyen de +2° seulement,

par rapport a la situation actuelle).

Cette perspective inspire les commentaires suivants aux Argonautes :

La négociation d'un accord international prolongeant et amplifiant le Protocole de Kyoto est indispensable et urgente ! (sachant que, compte tenu de l'ampleur des gaspillages au sein de la "Triade Amérique du Nord, Union Européenne et Japon", la division par 4, d'ici 2050, de nos émissions actuelles n'est nullement... une vue de l'esprit !) Les propositions formulées en Allemagne, en vue du prochain sommet du G8 (juin 2007), vont dans ce sens, puisqu'elles comportent une réduction de 30 % en 2020, (ce qui laisserait 30 ans pour porter cette réduction a 75 % en 2050).

Dans la mesure ou divers mécanismes d'amplification du Changement Climatique sont susceptibles de se déclencher, il est vital de poursuivre les recherches sur ces mécanismes dits de "rétroaction positive" (pouvant conduire, dans un cas défavorable, à une auto-amplification du réchauffement; même si l'existence d'un seuil dangereux n'est pas prouvée, il est logique de penser que ce risque augmente avec l'ampleur du réchauffement).

L'instauration d'une Veille Mondiale Océan et Climat (VMOC) se justifie par la nécessité de continuer à fonder le débat sur le changement climatique sur les progrès en sciences du climat d'une part, et sur des observations d'autre part. En effet, ces séries de mesures sont utiles:

d'abord pour conforter les modèles, (et... pour écarter les œillères de journalistes ou de responsables politiques... prisonniers de leurs croyances !), mais aussi

pour disposer d'un moyen de suivi du "système Terre" et d'alerte permettant de détecter que telle ou telle rétroaction, ou changement brutal, est déjà à l'œuvre.

Depuis plus de 3 ans, les Argonautes insistent sur l'intérêt d'une telle "VMOC", car rien ne garantit que des observations de l'océan et du climat (qui ont joué un rôle décisif pour le 4ieme Rapport du GIEC), seront poursuivies en routine, comme c'est le cas, en météorologie, pour les mesures quotidiennes de l'état de l'atmosphère.

Voir aussi FAQ :

Mois de Janvier/février 2007

1/3 Présentation à la presse par ECRIN et Omniscience du livre "Énergies Alternatives"

Le vendredi 16 février 2007 l'association ECRIN (Échange et coordination recherche-industrie) a présenté dans ses locaux parisiens le livre "Énergies Alternatives" réalisé à partir des travaux de ses groupes de travail spécialisés sur les énergies alternatives, leurs potentialités et les développements en cours.

Cet ouvrage ne se limite pas à l'examen des énergies renouvelables ( solaire, éolien, biomasse, géothermie, hydraulique et énergie thermique des mers) mais aborde aussi les problèmes de leur stockage, de leurs applications aux transports et à l'habitat.

Cet ouvrage dense en informations et en données chiffrées est une référence pour un public informé mais non spécialiste soucieux de mieux comprendre les enjeux liés à l'énergie.

2/3 Du nouveau sur les variations du niveau de la

mer

Le prix André Prud’homme décerné à Madame Alix Lombard

Le prix André Prud’homme a été créé en 1992 par la Société Météorologique de France avec le soutien de Météo-France, pour honorer la mémoire de André Prud'homme, météorologiste français mort accidentellement en Terre-Adélie pendant l'Année Géophysique Internationale (1957-1958).

Le jury qui s'est réuni le 3 octobre 2006 a choisi d'attribuer le prix à Alix Lombard du LEGOS(Laboratoire d’Etudes en Géophysique et Océanographie Spatiales) pour sa thèse :

"Les variations actuelles du niveau de la mer: observations et causes",

thèse de l'Université Paul-Sabatier (Toulouse), soutenue le 25 novembre 2005.

Ses résultats ont été une contribution essentielle aux travaux du Groupe d’Expert chargé de la première partie (Les bases scientifiques physiques) du 4ème rapport du Giec sur le changement climatique adoptée début février 2007. Le prix a été décerné le 17 janvier 2007 à Toulouse (Météo-France, Centre International de Conférences) alors que ces experts mettaient la dernière main à leur rapport.

C’est l’occasion pour le Club

des Argonautes, avec le concours d’Alix Lombard, de faire connaître l’état

actuel des connaissances sur les variations du niveau de la mer.

Voir FAQ: Quelles sont les

variations actuelles du niveau de la mer ? Observations et causes.

Voir aussi News de juin 2006: Oui, le niveau moyen des mers augmente ! Pourquoi ? Comment ? ET OU ?

3/3 Publication du 4ème Rapport du GIEC (IPCC)

Groupe de travail I: Bilan 2007 des changements climatiques: les bases scientifiques physiques »

Environ tous les quatre ans le Groupe

Intergouvernemental sur l’Évolution du Climat, GIEC, créé en 1988 par l’Organisation Météorologique

Mondiale (OMM) et le

Programme des Nations Unies pour l’Environnement (PNUE), publie un rapport

sur l’état des connaissances sur le changement climatique.

Par changement climatique, contrairement à la définition de la Convention Cadre

des Nation Unies sur le Changement Climatique, CCNUCC, le GIEC entend les évolutions du climat de notre

planète qu’elles qu’en soient les causes, naturelles ou résultant de l’activité

humaines.

Ce rapport comprend trois parties, correspondant aux trois groupes de travail qui constituent le GIEC:

Le Groupe de travail I qui évalue les aspects scientifiques du système climatique et de l’évolution du climat.

Le Groupe de travail II qui s’occupe des questions concernant la vulnérabilité des systèmes socio-économiques et naturels aux changements climatiques, les conséquences négatives et positives de ces changements et les possibilités de s’y adapter.

Le Groupe de travail III qui évalue les solutions envisageables pour limiter les émissions de gaz à effet de serre ou atténuer de toute autre manière les changements climatiques.

Lors de sa réunion tenue à Paris du 29 janvier au 2 février, le Groupe I a adopté son rapport dont nous faisons ici l’analyse.

Le rapport complet intitulé:

«Quatrième rapport d’évaluation - Groupe de travail I: Bilan 2007 des changements climatiques: les bases scientifiques physiques»,

fait le point sur les connaissances scientifiques concernant l’état du climat et son fonctionnement. Il a été adopté par consensus par l’ensemble de la communauté scientifique. Il représente un volume d’un millier de pages.

Ce rapport est résumé sous la forme d’un document de 15 pages, intitulé « Résumé à l’intention des décideurs», adopté mot par mot par

l’ensemble des scientifiques représentants les États Membres partis à la

CCNUCC.

Quel est le poids relatif des différentes composantes du forçage radiatif ?

Comment s’explique et à quoi doit-on attribuer le changement du climat ?

Que montre l’analyse des données disponibles ?

Le quatrième rapport confirme et amplifie les résultats du troisième.

Pour ce qui concerne l’évolution constatée, l’exploitation des données existantes, que ce soit des mesures directes ou des valeurs reconstituées par différentes méthodes, en particulier par analyse des carottages de glaciers, confirme et précise l’accroissement des températures, la fonte accélérée des glace et son corollaire, l’augmentation du niveau des océans.

Onze des douze dernières années sont parmi les plus chaudes depuis que l’on dispose de mesures directes, soit depuis 1850. Pour la période 1906-2005, la croissance moyenne de la température à été de 0,74°C, contre 0,6°C pour la période 1901-2000. Si l’on ne considère que les cinquante dernières années ce taux est presque double de celui des cent dernières années.

Les doutes qui existaient lors du troisième rapport sur l’évolution des températures dans la basse et moyenne troposphère ont été levés et le taux d’accroissement dans cette partie de l’atmosphère est comparable à celui constaté en surface.

L’accroissement de la quantité de vapeur d’eau contenue dans l’atmosphère est conforme à celle déduite du réchauffement, ce qui au passage implique un accroissement corrélatif de l’effet de serre.

Les océans ont capturé la majeure partie de l’augmentation de l’énergie, ce qui s’est traduit par un accroissement de leur température moyenne jusqu’à -3000 mètres. Ce réchauffement a entraîné leur expansion et a ainsi contribué à l’augmentation du niveau des mers de 1,6 mm/an pour la période 1993-2003 contre 0,42 pour 1961-2003.

Dans chacun des deux hémisphères la couverture neigeuse et l’épaisseur des glaces ont diminués, entraînant un accroissement du niveau des océans de 0,77 mm/an pour la période 1993-2003, alors qu’il n’avait été en moyenne que de 0,50 mm/an entre 1961 et 2003.

Au total l’accroissement du niveau des océans a été de 3,1 mm/an entre 1993 et 2003 contre 1,8 mm/an pour 1961-2003. Il faut cependant noter que de tels taux d’augmentation ont été observés pour d’autres périodes depuis 1950. Il n’est pas clair de savoir si ces taux sont significatifs d’une tendance à long terme ou s’ils relèvent de la variabilité décennale. Il est cependant quasiment certain que l’accroissement du niveau moyen des océans a été de 0,17 m au cours du 20ème siècle.

En plus de ces changements un grand nombre d’autres paramètres ont évolué toujours dans le sens du réchauffement. Par exemple:

La température de l’Arctique a cru deux fois plus vite au cours des 100 dernières années que pour le reste du globe, et la surface glacée a diminué de 2,7 % par décennie depuis 1978.

La température au sommet du pergélisol dans l’Arctique a augmenté de 3°C, au cours des années 80, et l’extension maximale de la surface du sol gelée pendant la saison froide, dans l’Hémisphère Nord, a diminué d’environ 7 % au cours du 20ème siècle. Au cours de la période 1990-2005 la quantité des précipitation a tendu à s’accroître sur la partie est de l’Amérique du Nord et du Sud, sur le nord de l’Europe et le nord et le centre de l’Asie, tandis que la sécheresse a augmenté sur le Sahel, la Méditerranée, le sud de l’Afrique et de l’Asie. Il faut cependant noter que, compte tenu de la forte variabilité spatiale et temporelle des précipitations, il n’est pas à ce stade possible de détecter une tendance générale pour d’autres régions significativement grandes.

Dans les régions tropicales et sub-tropicales les périodes de sécheresse ont tendu à être plus intenses et plus longues, depuis 1970, liées à des températures plus élevées et à des précipitations plus faibles. De même on a pu relier les sécheresses à l’augmentation de la température de surface des océans, à la modification de la circulation générale de l’atmosphère et à la décroissance des surfaces des glaces et de la couverture neigeuse.

On peut citer aussi l’augmentation: de la fréquence des vagues de chaleur, des températures maximales et des températures minimales, des précipitations intenses, etc.

On notera cependant que l’on n’a pas détecté un accroissement de la fréquence des cyclones tropicaux. L’exploitation des enregistrements de cyclones par les satellites semble montrer un accroissement de leur intensité. On ne peut cependant rien dire de la période antérieure à 1970, car il n’existait pas de mesures satellitales et que les mesures directes sont douteuses.

Enfin, la ré-analyse des données paléo climatiques, ainsi que l’obtention de nouvelles données permettant de remonter dans le temps au delà de 800 000 ans, montrent que le réchauffement de l’atmosphère a pour effet d’accroître la concentration des gaz à effet de serre, laquelle provoque à son tour une augmentation de température. La température moyenne des cinquante dernières années est très probablement supérieure à celle des cinq cents dernières et, vraisemblablement, des derniers mille trois cents ans. Pendant la dernière période interglaciaire, il y a environ 125 000 ans, le réchauffement des régions polaires, de 3 à 5°C au dessus de la température moyenne du 20ème siècle, (et lié à la variation des paramètres de l’orbite terrestre), a conduit à un accroissement du niveau de la mer de l’ordre de 4 à 6 mètres, par rapport au niveau actuel. L’impact de la fonte des glaces du Groenland et des régions Arctique n’intervenant que pour moins de 4 mètres, il est très probable que la différence ait été due à la fonte des glaces de l’Antarctique.

Quel est le poids relatif des différentes composantes du forçage radiatif ?

La concentration des gaz à effet de serre dans l’atmosphère a continué à s’accroître. Depuis le troisième rapport, l’amélioration des connaissances scientifiques a conduit à une meilleure compréhension de l’influence des activités humaines sur le bilan thermique. Ceci a conduit au fait que l’on peut aujourd’hui, avec une très haute probabilité, affirmer que les activités humaines ont conduit, depuis le début de l’ère industrielle vers 1750, à un accroissement du forçage radiatif de 1,6 watt/m2, soit environ cinq fois plus que celui lié au variation du rayonnement solaire qui atteint le sommet de l’atmosphère.

Les chiffres du forçage radiatif que l’on peut retenir aujourd’hui sont les suivants:

Accroissement de la concentration des gaz à effet de serre: +2,30 W/m2.

Aérosols d’origine humaine: -0,50 W/m2.

Variation de l’albédo lié aux nuages: -0,80 W/m2.

Accroissement de l’O3 du aux activités humaines: +0,35 W/m2.

Hallocarbones: +0,34 W/m2.

Variation de l’albédo du à la modification de l’usage des sols: -0,20 W/m2.

Variation de l’albédo du aux retombées des suies sur la neige: +0,10 W/m2.

Variation du rayonnement solaire atteignant l’atmosphère: +0,12 W/m2.

Comment s’explique et à quoi doit-on attribuer le changement du climat ?

Le troisième rapport concluait que l’accroissement des températures, au cours des cinquante dernières années, pouvait de manière quasi certaine être attribué à l’accroissement de la concentration en gaz à effet de serre.

L’étude de séries de mesures, plus complètes et plus longues, ainsi que l’amélioration de la qualité des modèles de simulation et du nombre des simulations, permettent d’affirmer aujourd’hui que la majeure partie du réchauffement observé depuis le milieu du 20ème siècle peut, avec une très haute probabilité, être attribuée à l’action humaine.

Les modèles de simulation qui prennent maintenant en compte les aérosols, qu’ils soient d’origine volcanique ou dus à l’action de l’homme, donnent, pour la période qui va de 1900 à 2000, des résultats qui coïncident remarquablement bien avec les observations.

La seule prise en compte dans les modèles des variations naturelles ne peuvent en aucune façon expliquer le réchauffement constaté et la fonte des glaces.

La coïncidence ne se résume pas aux températures de surface mais aussi aux variations dans la troposphère et dans les quelques premiers milliers de mètres des océans. De la même façon les changements dans la circulation générale de l’atmosphère, tels que le décalage vers les pôles du lit des perturbations, se trouvent vérifiés.

Enfin le réchauffement, croissant de l’équateur vers les pôles et plus important pour les surfaces continentales que pour les océans, correspond bien à ce qui est observé.

Par contre, il est bon de noter, qu’au stade actuel, les modèles sont non conclusifs pour ce qui concerne les modifications aux échelles sous continentales ou locales. De même, les changements dans la circulation générale qui apparaissent dans les simulations, sont plus faibles que ceux observées.

En conclusion on peut dire que les résultats des modèles de simulation, confortés par les observations, donnent pour une concentration en gaz carbonique de 550 ppm, un réchauffement, par rapport à la période préindustrielle, compris entre 2°C et 4,5°C la meilleure estimation étant de 3°C.

Un réchauffement inférieur à 1,5°C est très improbable, alors qu’une valeur supérieure à 4°C n’est pas à exclure, bien qu’ici les résultats des modèles ne soient pas soutenus par les observations. Le rôle dominant de l’accroissement du contenu en vapeur d’eau de l’atmosphère dans ce réchauffement est maintenant mieux compris, tandis que celui des nuages fait encore partie des incertitudes à éclaircir.

Retour sommaire

Qu’en est-il pour le climat du futur?

Pour projeter ce que pourrait être le climat du futur, il faut connaître la façon dont évolueront les émissions de gaz à effet de serre, évolution qui ne dépend que de la volonté humaine. Aux incertitudes d’ordre scientifique s’ajoutent donc celles qui relèvent du comportement humain.

D'un point de vue scientifique, ce quatrième rapport bénéficie d'un plus grand nombre de simulations effectuées avec des modèles fortement améliorés, et qui ont été confrontés aux observations existantes. (Par exemple, les estimations faites depuis le premier rapport, qui donnait un réchauffement compris entre 0,15°C et 0,3°C par décennie, se comparent favorablement avec la valeur observée de 0,2°C par décennie).

Le quatrième rapport donne le résultat de ces simulations, effectuées en utilisant, pour l’évolution de la concentration des gaz à effet de serre, celles fournies par six scénarios d’évolution des émissions en fonction des activités humaines. Ces 6 scénarios ont été définis par le groupe spécial du GIEC chargé de cette tâche. Il sont contenus dans le SRES (Special Report on Emission Scenarios).

Les simulations utilisent les concentrations fournies par les différents scénarios sur la période 2000-2100 ; ces concentrations étant supposées constantes au delà de 2100.

Dans ces conditions, pour les vingt ans à venir, le taux du réchauffement pourrait être de 0,2°C par décennie. Même si la concentration restait limitée à son niveau de 2000, ce taux serait encore 0,1°C.

Par rapport à la période 1980-1999, le réchauffement pourrait, à la fin du 21ème siècle et selon le scénario choisi, être compris entre 1,7°C et 4,0°C. (Valeur moyenne "Terre entière", qui peut masquer des écarts géographiques de 1 à 3, notamment dans la zone arctique). A chacune des six valeurs moyennes correspondant aux six scénarios, est attachée une fourchette d’incertitude qui, pour les 2 exemples cités, est respectivement: [1,0 à 2,7] °C et [2,4 à 6,3] °C.

Par rapport au troisième rapport, le quatrième sépare donc bien les incertitudes scientifiques liées à la simulation du climat de celles liées au comportement humain.

Le réchauffement entraîne une diminution de la quantité de CO2 capturée par les océans et les sols ce qui, ajouté à un plus grand nombre de modèles, explique l’élargissement des fourchettes d’incertitude données dans le troisième rapport.

Pour le niveau moyen des océans, et selon les scénarios déjà décrits pour les températures, l’accroissement irait de 0,28 m [0,19 à 0,37] m à 0,48 m [0,28 à 0,58] m. L’expansion thermique serait responsable pour 60 à 70% de cet accroissement.

Les valeurs plus faibles que celles qui figuraient dans le troisième rapport tiennent à une meilleure estimation de l’énergie capturée par les océans et à une meilleure appréciation de la fonte des glaces. Si cependant la fonte des glaces du Groenland se poursuivait de manière linéaire par rapport à la situation actuelle, on devrait augmenter de 10 à 25% les valeurs données pour chacun des scénarios.

Il faut enfin noter que l’accroissement de la quantité de gaz carbonique dissous dans les océans conduit à un accroissement de son acidité et, à terme, à une dissolution des carbonates contenus dans les sédiments des eaux peu profondes et les récifs coralliens.

Au delà des deux paramètres que sont la température et le niveau des océans, le rapport note les points suivants:

Réchauffement croissant avec la latitude, plus important sur les continents que sur les océans.

Diminution des glaces dans l’Antarctique et l’Arctique, cet océan pouvant en fin de période être presque totalement libéré en fin d’été.

Diminution du nombre de cyclones tropicaux, mais accroissement de leur intensité.

Si le réchauffement de l’ordre de celui projeté se poursuivait sur quelques millénaires, la fonte totale des glaces du Groenland pourrait conduire à un accroissement du niveau des océans de quelques 7 m. Les températures projetées, comparables à celles ayant régné il y a 125 000 ans, avaient alors conduit à un niveau 4 à 6 m plus élevé que l’actuel.

La température de l’Antarctique devrait rester suffisamment froide pour qu’il n’y ait pas de fonte généralisée des glaces de surface et, par ailleurs, l’accroissement des précipitations devrait plutôt conduire à une augmentation de l’épaisseur de glace.

Enfin, il faut noter la longueur du cycle du gaz carbonique qui fait que les émissions du 21ème siècle devraient conduire à un réchauffement de l’atmosphère, et à une élévation du niveau des océans, qui se poursuivront au delà de mille ans.

Retour sommaire

Note complémentaire sur les 6 scénarios

Les scénarios se répartissent en quatre familles, certaines d’entre elles présentant des variantes. Il est important de noter qu’aucun de ces scénarios ne suppose que l’on impose une contrainte aux émissions, comme par exemple celle résultant de l’application du protocole de Kyoto. Il ne donne aucune estimation de la probabilité de chacun d’entre eux.

On distingue:

A1. Le développement économique est très rapide, la population mondiale passe par un maximum vers le milieu du 21ème siècle, et décroît ensuite, et des technologies nouvelles et plus efficaces sont introduites. Cette évolution est véritablement mondiale, le développement des différents États convergent. Cette famille est elle même subdivisée en trois variantes qui dépendent de l’évolution des technologies:

A1FI: Utilisation intensive des énergies fossiles

A1T: Utilisation d’énergie non fossile

A1B: Utilisation mixte.

A2. Le monde reste très hétérogène et le développement se fait sur la base des ressources régionales et locales.

B1. L’évolution mondiale de l’économie et des population sont les mêmes qu’en A1 mais se produit une évolution rapide des structures économiques vers des activités de services.

B2. Le développement est basé sur des solutions locales qui mettent l’accent sur les problèmes sociaux et sur la durabilité. L’accroissement de population a un taux plus faible qu’en A1 et B1, et le développement est moins rapide de même que l’évolution des technologies. Bien que basé aussi sur des préoccupations environnementales et d’équité sociale l’aspect régional et local domine.

Version française provisoire du Résumé (document Word) à l'intention des décideurs publié par la Mission Interministérielle sur l'Effet de Serre