Les News

Mois de Décembre 2011

1/1 Automne 2011 : de nouveaux satellites dans l'espace

Pour les scientifiques de l'environnement, et surtout pour les météorologistes, le mois d'octobre 2011 a été particulièrement prometteur en nouvelles observations spatiales, avec la mise en orbite de plusieurs satellites:

le 12 octobre, lancement depuis l'Inde du satellite Megha-Tropiques, satellite météorologique destiné à la recherche atmosphérique ;

le 21 octobre, première mission depuis Kourou de la fusée russe Soyouz qui met en orbite les deux premiers satellites Galileo du système de navigation européen ;

le 28 octobre, lancement du satellite américain à orbite polaire NPP, précurseur de la nouvelle série de satellites météorologiques américains défilants NPOESS, depuis la base américaine de Vandenberg en Californie.

Qu'apportent ces satellites à la communauté météorologique ?

La mission Megha-Tropiques résulte d'une action conjointe des agences spatiales française (Cnes) et indienne (Isro).

Les instruments scientifiques ont été développés pour l'essentiel en France alors que le satellite lui-même et son lancement sont d'abord l'œuvre de l'Inde.

Les instruments visent l'étude du cycle de l'eau entre les tropiques, en particulier la mousson et son évolution dans le contexte du réchauffement climatique.

La masse du satellite Megha-Tropiques est

d'environ une tonne. Son orbite est à 866 km d'altitude.

Par rapport aux satellites météorologiques opérationnels, Megha-Tropiques présente deux originalités :

Il associe trois radiomètres de façon à observer simultanément trois composantes de la machine énergétique atmosphérique, à savoir :

(i) la vapeur d'eau;

(ii) l'eau condensée (nuages et précipitations);

(iii) les flux énergétiques.

Il privilégie l'échantillonnage de la zone intertropicale par une orbite inclinée à 20° par rapport à l'équateur.

Ainsi le satellite survole l'Inde (et toute autre région intertropicale) plusieurs fois par jour alors que les satellites défilants héliosynchrones (embarquant le même type d'instruments micro-ondes) ne passent que deux fois par jour sur une telle région. Les données vont donc permettre un meilleur suivi de l'évolution diurne près de l'équateur, en particulier celle concernant les nuages.

Les trois instruments embarqués à bord de Megha-Tropiques sont les suivants:

MADRAS, un imageur micro-ondes : sa mission principale est d'observer les systèmes nuageux ; il est assez semblable à l'instrument micro-ondes SSM/I utilisée en météorologie opérationnelle depuis plusieurs années.

SAPHIR, un sondeur micro-ondes à 6 canaux qui permet de restituer des profils verticaux de vapeur d'eau avec 10km de résolution au nadir.

SCARAB, un radiomètre (avec 4 canaux dans le visible et l'infrarouge) dédié à la mesure des flux au sommet de l'atmosphère. Il s'agit d'un instrument conçu par le LMD qui a déjà volé sur le satellite russe Meteor.

La constellation Galileo, quand elle sera entièrement mise en œuvre, comprendra une trentaine de satellites en orbite à environ 23 000km d'altitude.

Comme pour le système GPS américain (ou le GLONASS russe), chaque satellite sera équipé d'un émetteur de radionavigation (type GPS) fonctionnant en continu.

L'analyse des signaux reçus, en tout point de l'environnement terrestre, permet un positionnement très précis du lieu de réception.

Galileo est un projet européen de géolocalisation avec de multiples applications opérationnelles et innovantes.

Les deux satellites lancés simultanément depuis Kourou le 21 octobre 2011 sont les premiers de la trentaine envisagée. Ce lancement était une première pour le Cnes, les Russes etla coopération franco-russe en matière de spatial, puisque c'était la première fois qu'une fusée Soyouz opérait depuis Kourou (suite à l'agrandissement et au réaménagement récents de la base en Guyane française).

Deux autres satellites Galileo devraient être mis en orbite en 2012. Les premiers tests Galileo de géolocalisation seront alors possibles : ils nécessitent le traitement simultané des signaux d'au moins 4 satellites émetteurs différents.

Chaque satellite Galileo a une masse de 675 kg et

une orbite inclinée de 56° par rapport à

l'équateur.

A priori les satellites Galileo (ainsi que tous ceux émettant des signaux de radionavigation) sont des satellites de géolocalisation qui ne présentent pas d'intérêt pour l'observation météorologique. Toutefois, il y a déjà plus de 20 ans, des météorologistes avaient parié que la mesure du retard de la propagation des signaux GPS à travers l'atmosphère terrestre pouvait être exploitée utilement pour déduire de l'information sur la température et l'humidité atmosphérique. Ce pari a conduit à la mission GPSMET dont les données ont permis de vérifier l'utilité météorologique des signaux GPS aux environs de l'an 2000.

Depuis 2005 environ, les signaux GPS sont exploités de deux manières dans les modèles de prévision météorologique :

Avec des récepteurs GPS installés au sol, en des points fixes de la surface terrestre, on peut extraire une information sur la quantité de vapeur d'eau intégrée sur la verticale de ces points.

A partir des récepteurs embarqués à bord de satellites en orbite basse (quasi-polaire généralement), on peut utiliser les occultations des satellites émetteurs par la Terre et son atmosphère pour extraire une information sur la réfraction de l'onde radioélectrique par l'atmosphère terrestre, donc sur la densité atmosphérique, et donc sur le profil vertical de température et d'humidité.

Les signaux GPS assimilés dans les modèles de prévision opérationnels apportent d'ores et déjà un bénéfice qui a pu être évalué et qui est presque du même ordre que celui d'un sondeur atmosphérique.

Quand Galileo sera opérationnel, on aura environ deux fois plus de satellites émetteurs. Pour les données météorologiques extraites des signaux de radionavigation, il en résultera une amélioration probablement très significative en quantité et en qualité.

Depuis la décennie 1970 les États-Unis d'Amérique exploitent la série NOAA de satellites météorologiques défilants dont les données sont transmises en temps réel à la communauté météorologique.

Les instruments embarqués sont essentiellement des radiomètres opérant dans des bandes micro-ondes ou infrarouges (sondeurs et imageurs).

Dans la continuité de la série NOAA, les américains préparent la génération de satellites défilants NPOESS dont la mise en œuvre est coordonnée avec les satellites européens du même type dans le cadre du JPSS.

Les nouveaux satellites NPOESS embarqueront des sondeurs et imageurs (améliorés par rapport à ceux de la série NOAA) ainsi que de nouveaux instruments.

Le satellite NPP, mis en orbite le 28

octobre 2011, est le précurseur de la série NPOESS. Il est héliosynchrone,

avec une heure locale de passage au nœud

ascendant à 13h30, conformément à la coordination JPSS

avec l'Europe (dont les satellites MetOp

remplissent les mêmes fonctions météorologiques à

9h30 locales). On peut dire aussi que NPP assure la transition entre la

série NOAA et la série NPOESS.

NPP a une masse de 2,13 tonnes. Son orbite est

à 824 km d'altitude. Sa durée de vie est estimée

à 5 ans. L'activation de son émission directe vers le sol est

prévue pour le 9 janvier 2012. Le Centre de Météorologie

Spatial de Lannion est prêt pour la recevoir, comme probablement beaucoup

de centres étrangers faisant habituellement de l'acquisition directe.

Cinq instruments sont embarqués à bord de NPP :

ATMS : sondeur micro-ondes, successeur de l'actuel sondeur AMSU sur les satellites NOAA.

CrIS : sondeur infrarouge hyperspectral, type interféromètre de Michelson, très semblable à l'instrument IASI sur MetOp.

OMPS : ensemble de spectromètres dédiés à la mesure de l'ozone.

VIIRS : imageur infrarouge successeur de l'actuel AVHRR sur les satellites NOAA; avec ses 22 canaux, il est très semblable à l'instrument MODIS actuellement embarqué sur les satellites défilants de la NASA AQUA et TERRA.

CERES : radiomètre dédié à l'estimation du bilan radiatif terrestre.

Le JPSS est un ensemble de satellites météorologiques héliosynchrones qui comprend le NPP (les NPOESS ensuite) et les MetOp européens. Il est prévu de maintenir dans le futur au moins trois satellites de ce type avec des orbites choisies pour obtenir une couverture en observations la plus homogène possible sur le globe terrestre. Dans la série MetOp, le prochain lancement prévu est celui de MetOp B (devant succéder à l'actuel MetOp A). Il doit avoir lieu en mai 2012 depuis Baïkonour. Il embarquera 13 instruments; certains seront les homologues des instruments cités plus haut, mais il y aura aussi par exemple le diffusiomètre ASCAT comme sur son prédécesseur MetOp A.

DES DONNEES SERVANT A LA

FOIS L'OPERATIONNEL ET LA RECHERCHE

Pour la communauté météorologique NPP est plutôt un

satellite « opérationnel », Megha-Tropiques un

satellite de « recherche », alors que le programme

Galileo est une « opportunité » pour obtenir des

observations. Mais en matière d'observations

météorologiques et océanographiques les étiquettes

« recherche », « opérationnel », «

opportunité » se mélangent souvent. Les utilisateurs qui

effectuent des recherches sur les données satellitaires sont souvent les

mêmes que ceux qui les exploitent en les assimilant dans des

modèles. La rareté des observations les rend précieuses

et oblige les utilisateurs à « faire feu de tout

bois », y compris du « bois vert » des

instruments innovants.

Même si la plupart des instruments de NPP sont déjà familiers aux prévisionnistes et aux assimilateurs de données (dans les modèles de prévision), il est clair qu'ils conduiront aussi à beaucoup d'actions de recherche et de développement, par exemple à travers les réanalyses (qui vont les utiliser) et les modèles climatiques (qui s'appuient souvent sur ces réanalyses pour leur état initial et leur validation).

Les chercheurs en météorologie tropicale attendent avec impatience l'arrivée des nouvelles données de Megha-Tropiques, mais ces nouveaux instruments ne sont pas totalement inconnus, et il est aussi clair que certaines données seront assimilées dans les modèles de prévision, peut-être même en temps réel, à coup sûr en temps différé pour améliorer ces modèles.

Les météorologistes utilisateurs de signaux GPS devront être davantage patients pour tirer le bénéfice des satellites Galileo : plusieurs années, le temps que la nouvelle constellation européenne de géolocalisation devienne opérationnelle.

L'OMM effectue tous les quatre ans environ

un bilan sur l'utilisation des différents systèmes d'observation

(satellitaires comme terrestres) dans les modèles de prévision,

et sur les bénéfices qu'ils apportent à la

prévision du temps. Ce bilan régulier est traité sous

forme d'un atelier rassemblant les principaux centres de prévision

numérique du monde. Le dernier rapport sur « l'impact des

observations » ainsi que toutes les présentations de l'atelier

sont disponibles sur le web

public de l'OMM.

Ce dernier rapport date de mai 2008. Le prochain atelier est prévu aux

Etats-Unis en mai 2012.

Deux définitions utiles pour la lecture de cet article :

Nœud ascendant : Pour un

satellite dont le plan de l'orbite a une inclinaison non nulle, l'intersection

avec le plan de l'Equateur s'appelle la ligne des noeuds. On distingue le noeud

ascendant lors du passage de l'hémisphère sud à

l'hémisphère nord, tandis que l'autre est appelé noeud

descendant.

Héliosynchrone: Une orbite héliosynchrone est une orbite choisie de façon que l’angle de la direction du Soleil avec le plan d’orbite demeure à peu près constant tout au long de l’année. Ceci peut être obtenu en mettant à profit la dérive du plan d’orbite liée à l’attraction du bourrelet équatorial. En choisissant bien l’altitude et l’inclinaison, on peut obtenir une dérive d’un peu moins de un degré par jour, permettant de suivre le mouvement apparent du Soleil. En fonction de l’heure du lancement, on peut aussi faire en sorte que le Soleil se trouve dans une direction à l’Ouest du plan d’orbite, et faisant avec lui un angle de 22,5 degré, ce qui correspond à une heure locale de passage à l’équateur de 13h30 (de 01h30 pour le nœud descendant).

Mois de Novembre 2011

1/1 Evènements climatiques

extrêmes, gérer le risque... rapport spécial du GIEC  publié le vendredi 18 novembre.

publié le vendredi 18 novembre.

The IPCC

Special Report on Managing the Risks of Extreme Events and Disasters to Advance

Climate Change Adaptation

The IPCC

Special Report on Managing the Risks of Extreme Events and Disasters to Advance

Climate Change Adaptation

Ce rapport spécial dont le titre peut être traduit en français par «Gérer les risques des événements extrêmes et des désastres pour améliorer l’adaptation au changement climatique» a été approuvé par les états membres du Groupe Intergouvernemental sur l’Évolution du Climat.

Les événements extrêmes sont

définis comme ceux au cours desquels un paramètre approche des

limites de la plage des valeurs observées pour ce paramètre. La

distinction entre événement météorologique et

événement climatique repose sur la durée de

l’événement, la limite entre les deux étant peu

précise et pouvant varier entre moins d’un jour et quelques

semaines.

La rareté des événements extrêmes est

évidemment une difficulté majeure pour évaluer

l’existence de changements statistiquement significatifs dans leur

fréquence ou leur intensité. Le rapport considère

néanmoins qu’il est probable que l’accroissement

anthropique des gaz à effet de serre dans l’atmosphère a

provoqué une augmentation générale des minima et des

maxima des températures journalières et une augmentation

générales des valeurs extrêmes des hautes eaux sur les

côtes. Les preuves sont moyennement convaincantes en ce qui concerne

l’intensification globale des précipitations extrêmes. Les

changements intervenus dans les moyens d’observation ne permettent pas de

tirer de conclusion sur une éventuelle augmentation à long terme

de l’activité cyclonique tropicale. Il est vraisemblable qu'au

cours des dernières décennies, un déplacement vers les

pôles des trajectoires des tempêtes extratropicales se soit produit

dans les deux hémisphères

Les pertes économiques dues à des

désastres météorologiques ou climatiques ont cru, avec une

grande variabilité spatiale et interannuelle. Cette tendance à

long terme résulte essentiellement de l’augmentation de

l’exposition des personnes et des biens. L’influence du climat sur

cette tendance ne peut être exclue, bien qu’elle ne soit pas mise en

évidence.

La vulnérabilité humaine aux événements

extrêmes dépend de facteurs nombreux et divers. Le rapport

décrit comment la gestion des risques de désastre et

l’adaptation peuvent aider les communautés les plus

vulnérables à faire face au changement climatique.

La confiance dans les estimations des changements à venir dans la

direction et l’amplitude des extrêmes dépend de nombreux

facteurs, comme la nature de l’extrême, la région et la

saison, la quantité et la qualité des données

d’observation, le degré de compréhension des processus en

jeu et la fiabilité de leur simulation par les modèles.

Il est pratiquement certain qu’au cours du 21ème siècle,

la fréquence des journées chaudes et les températures

atteintes vont généralement croître tandis que les froids

extrêmes seront en réduction. Il est très vraisemblable que

la longueur, la fréquence ou l’intensité des vagues de

chaleur vont augmenter sur la plupart des terres.

Il est vraisemblable que la fréquence des fortes précipitations

ou la proportion des précipitations sous la forme de pluies intenses

vont augmenter. Vraisemblablement, la vitesse maximum des vents dans les

cyclones tropicaux va croitre, tandis que la fréquence globale de ces

cyclones sera stab,le ou décroissante. On estime (avec une confiance

moyenne) que le nombre moyen de cyclones extratropicaux devrait, au cours des

prochaines décennies, décroître dans chaque

hémisphère et que les sécheresses s’intensifieront

à certaines saisons, par suite de précipitations réduites

et d’une évapotranspiration accrue. On a peu de confiance dans les

estimations des changements des crues fluviales, induits par les changements de

température et de précipitations. On peut cependant

s’attendre à ce que les pluies intenses provoquent localement des

inondations.

Il est très vraisemblable que la montée moyenne du niveau de la

mer induira une montée des hautes eaux observées sur les

côtes et les zones déjà sujettes à

l’érosion et aux inondations continueront de l’être.

Les experts ont une grande confiance dans le fait que les vagues de chaleur,

le retrait des glaciers et la dégradation du pergélisol

affecteront la haute montagne par des phénomènes comme des

instabilités de certaines pentes et des inondations liées

à la vidange brutale de lacs glaciaires.

Des mesures d’adaptation, dites "sans regret"  , offrent des avantages dans les

conditions climatiques actuelles et dans celles qui sont prévues dans

une palette de scénarios des changements à venir. Elles

constituent de bonnes pistes pour répondre aux évolutions

tendancielles estimées de l’exposition, de la

vulnérabilité et des événements extrêmes.

Elles peuvent être bénéfiques dès maintenant et

constituer une base solide pour faire face aux changements estimés. Ces

mesures "sans regrets" comprennent des systèmes d’alerte

précoce, une bonne communication sur le risque entre les

décideurs et les citoyens locaux, une gestion durable de

l’utilisation des terres et des écosystèmes. D’autres

mesures "sans regret" sont l’amélioration de la surveillance

sanitaire, de l’approvisionnement en eau, de l’assainissement, des

systèmes d’irrigation et de drainage, des infrastructures

résistant au climat, le développement de normes de construction

et une meilleure éducation et prise de conscience.

, offrent des avantages dans les

conditions climatiques actuelles et dans celles qui sont prévues dans

une palette de scénarios des changements à venir. Elles

constituent de bonnes pistes pour répondre aux évolutions

tendancielles estimées de l’exposition, de la

vulnérabilité et des événements extrêmes.

Elles peuvent être bénéfiques dès maintenant et

constituer une base solide pour faire face aux changements estimés. Ces

mesures "sans regrets" comprennent des systèmes d’alerte

précoce, une bonne communication sur le risque entre les

décideurs et les citoyens locaux, une gestion durable de

l’utilisation des terres et des écosystèmes. D’autres

mesures "sans regret" sont l’amélioration de la surveillance

sanitaire, de l’approvisionnement en eau, de l’assainissement, des

systèmes d’irrigation et de drainage, des infrastructures

résistant au climat, le développement de normes de construction

et une meilleure éducation et prise de conscience.

La gestion du risque sera généralement plus efficace si elle

fait appel à un portefeuille d’actions de réduction des

risques et de réponse aux événements et aux

désastres plutôt que de se focaliser sur un seul type

d’action. De telles approches intégrées seront d’autant

plus efficaces qu’elles auront été adaptées aux

circonstances locales.

Une gestion multi-risques fournit des occasions de réduire les effets

d’une combinaison de divers impacts et de diminuer la probabilité

que le traitement d’un risque spécifique n’entraîne un

accroissement de l’exposition et de la vulnérabilité

à d’autres risques présents ou futurs.

Un pré-requis pour la durabilité dans un contexte de changement

climatique est le traitement des causes sous-jacentes de

vulnérabilité, comme les inégalités structurelles

qui entraînent la pauvreté et limitent l’accès aux

ressources.

Les actions d’adaptation et de réduction des risques de

désastre les plus efficaces sont celles qui offrent des

améliorations du développement à court terme et de la

vulnérabilité à plus long terme, bien que des compromis

doivent parfois être faits entre court et long terme. Les interactions

entre la mitigation ![]() du changement

climatique, l’adaptation à ce dernier et la gestion des risques de

désastre peuvent avoir une profonde influence sur les trajectoires de

développement résilientes

du changement

climatique, l’adaptation à ce dernier et la gestion des risques de

désastre peuvent avoir une profonde influence sur les trajectoires de

développement résilientes  et durables.

et durables.

Plus d'informations :

Rapport spécial du Giec : Résumé à l'intention des décideurs (en anglais)

Le rapport complet sera disponible en

février 2012.

Définitions :

GIEC : Groupe d'experts Intergouvernemental sur l'Évolution du Climat

GIEC : Groupe d'experts Intergouvernemental sur l'Évolution du Climat

Mesures sans regret : Mesures rentables et utiles en soi, quelle que

soit l’amplitude du réchauffement et même sans

réchauffement

Mesures sans regret : Mesures rentables et utiles en soi, quelle que

soit l’amplitude du réchauffement et même sans

réchauffement

Mitigation ( Terme franglais : "atténuation" en Français)

: Intervention humaine pour réduire les émissions de gaz à

effet de serre

Mitigation ( Terme franglais : "atténuation" en Français)

: Intervention humaine pour réduire les émissions de gaz à

effet de serre

Résilience : Capacité

d'un système à rapidement retrouver ou améliorer ses

structures essentielles et ses fonctions, après une perturbation

Résilience : Capacité

d'un système à rapidement retrouver ou améliorer ses

structures essentielles et ses fonctions, après une perturbation

Mois de Juillet 2011

1/1 Au revoir Jean

Nous avons appris avec une profonde tristesse que Jean

Labrousse, membre du Club des Argonautes depuis sa création en 2003,

nous a quittés ce samedi 9 juillet.

Pour les membres du Club, Jean était un collègue et surtout un

ami. Pour tous ceux qui ont eu la chance de le connaître, il était

aussi un grand scientifique rigoureux et respecté, tant pour ses

connaissances que pour ses qualités humaines.

Il était toujours très présent et pertinent dans nos

échanges, sa grande sagesse va beaucoup nous manquer.

Le Club adresse à son épouse Janine et sa famille toute sa

sympathie et son émotion.

Un ancien collègue de Météo France a

déposé sur notre site un message qui reflète parfaitement

nos sentiments, le voici :

"Bonjour Jean,

C'est avec beaucoup de tristesse que je viens d'apprendre que tu nous avais

quittés pour aller dans un autre monde. Un monde où tu seras

à coup sûr accueilli à bras ouverts. Là-haut, il

vont avoir de la chance de profiter de ton esprit bouillonnant d'idées,

de tous les projets à réaliser et surtout de tes qualités

humaines pleines de chaleur et d'ouverture vers les autres.

Maintenant, compte sur nous pour ne pas t'oublier ! Il restera toujours

quelque chose de toi ici et dans notre mémoire.

Au revoir Jean.

Très amicalement. Joël "

Jean Labrousse a largement contribué à enrichir ce site, notamment par des articles sur le climat (rubrique FAQ) et aussi par les nombreuses discussions qui ont fait progresser la réflexion du Club.

De la même manière, il a participé à l'élaboration de l'ouvrage collectif du Club : "Climat, une planète et des hommes".

Pendant l'écriture de son livre "L'avenir de l'eau", Erik Orsenna l'appelait : "mon professeur de pluie".

Mois de Juin 2011

1/1 Déclaration de l'OMM sur l'état du climat mondial en 2010

L'Organisation Météorologique Mondiale a publié comme chaque année depuis 1993, une déclaration sur l'état du climat mondial.

L’année 2010 s’est particulièrement

distinguée par le fait que les températures moyennes à la

surface du globe ont atteint des valeurs records qui sont du même ordre

que celles enregistrées en 1998 et 2005 et qui confirment

l’accélération du réchauffement constaté ces

50 dernières années.

L’année 2010 s’est particulièrement

distinguée par le fait que les températures moyennes à la

surface du globe ont atteint des valeurs records qui sont du même ordre

que celles enregistrées en 1998 et 2005 et qui confirment

l’accélération du réchauffement constaté ces

50 dernières années.

Elle vient aussi clôturer la décennie la plus

chaude jamais enregistrée, durant laquelle le réchauffement a

été beaucoup plus ma, notamment en Afrique du Nord et dans la

péninsule arabique, en Asie méridionale et dans

l’Arctique.

Elle vient aussi clôturer la décennie la plus

chaude jamais enregistrée, durant laquelle le réchauffement a

été beaucoup plus ma, notamment en Afrique du Nord et dans la

péninsule arabique, en Asie méridionale et dans

l’Arctique.

La température moyenne a été supérieure de 0,46 °C à la normale calculée pour la période 1961–1990 et de 0,21 °C à la moyenne de la décennie 1991–2000. Celle-ci était déjà plus chaude que les précédentes, ce qui confirme une tendance au réchauffement sur le long terme.

Mois de Mai 2011

1/1 Les 40 ans du Groupe de Recherche de Géodésie Spatiale, un quarantième rugissant...

Le 17 février 2011, le GRGS célébrait ses quarante ans de recherche.

Voici le compte-rendu qu'en ont fait deux Argonautes ayant œuvré à sa fondation.

Les moyens satellitaires ont été une révolution pour la géodésie, science de l'étude de la forme de la terre et de sa dynamique, car ils ont permis, pour la première fois, d'appréhender la planète Terre dans sa globalité. C'est pour fédérer les efforts et tirer le meilleur parti des nouvelles techniques spatiales qu'a été créé le GRGS en 1971.

Initié par quatre organismes fondateurs, le Bureau des longitudes, l'Observatoire de Paris, le Centre national d'études spatiales, l'Institut géographique national, il a ensuite fédéré 10 organismes publics spécialisées dans le domaine de la géodésie spatiale. Son originalité a résidé dans son approche novatrice des "problèmes de bon voisinage" et "d'intégration" entre organismes ou entre disciplines, une approche qui a conduit à une interdisciplinarité exemplaire. Intégration signifie ici que chacun participe à un même projet commun impliquant les équipes industrielles, scientifiques et celles des départements des agences spatiales proprement dites ; ce n'est donc pas une simple juxtaposition d'efforts.

Cela n'a pas été facile, il a fallu y mettre beaucoup d'énergie ! Et ce fut une réussite : en 40 ans, le CNES, les équipes de recherche associées, et les organismes partenaires ont bâti un programme ambitieux et unique dans le domaine de la mesure de la Terre et de sa dynamique.

La journée

anniversaire fut une réussite.

La journée

anniversaire fut une réussite.

Dans ce lieu mythique de l'Observatoire de Paris, salle Cassini, plus d'une centaine de chercheurs se sont réunis pour dresser un bilan de ces quarante années de recherche innovante et ont brossé les perspectives prometteuses.

Trois étapes dans la journée :

- une consacrée à la création du GRGS,

- une deuxième aux activités actuelles présentées dans sept domaines,

- la troisième au futur.

Les sept exposés thématiques ont concerné les recherches développées au cours de ces quatre décennies :

les

observatoires géodésiques,

les

observatoires géodésiques, la mécanique orbitale et le champ de gravité,

l’océanographie et l’hydrologie spatiales,

les systèmes de référence et la rotation de la terre,

la géodésie planétaire,

la physique fondamentale,

les services scientifiques.

Du point de vue adopté par les fondateurs du GRGS, tous ces thèmes ont en commun :

la métrologie,

la mesure de paramètre,

l’acquisition,

le traitement

et la validation des données.

Une table ronde

organisée en coopération avec l'IFHE a ensuite permis d’évoquer les points

marquants, en particulier ceux liés à la structure originale de

ce groupe de recherche et à son impact sur le succès des travaux

de recherche.

Une table ronde

organisée en coopération avec l'IFHE a ensuite permis d’évoquer les points

marquants, en particulier ceux liés à la structure originale de

ce groupe de recherche et à son impact sur le succès des travaux

de recherche.

Par la qualité de ses premiers résultats, en particulier avec la télémétrie laser, le GRGS a acquis très vite une réputation d'excellence, qui lui a permis de nouer des coopérations internationales décisives. Bien que le contexte ait changé, l'adaptation nécessaire a eu lieu et la volonté de disposer d'observations précises traitées avec une approche métrologique est maintenue, et se met au service d'une diversité de domaines de recherche.

Deux partenaires de longue date du GRGS sont venus témoigner de plus de 30 ans de coopération.

Kurt Lambeck, géophysicien et géodésien, membre de l’Académie des sciences en Australie et dans ce cadre responsable des études sur le climat ;

Christoph Reigber, géodésien d’abord au DGFI (Deutsches Geodätiches Forschungsinstut) à Munich puis au GFZ (Deutsches GeoForschungsZentrum) à Postdam, leader européen et mondial dans les programmes de recherche du champ de gravité et tout particulièrement dans les missions engagées pour la décennie du champ de gravité (Satellites Champ et Grace).

En conclusion, ce groupement d'organismes publics est une structure de dialogue, les idées nouvelles sont non seulement bienvenues mais recherchées, les observations sont "bien traitées", les résultats ont suivi et... cela continue !

Aujourd’hui 14 équipes de recherche appartenant à 8 instituts différents sont fédérées par le GRGS.

A l'issue de cette journée, il est clair que cette formule originale doit être poursuivie, en particulier les possibilités de dialogue entre chercheurs de plusieurs disciplines, les contacts à l’échelle internationale, la connaissance intime des systèmes de mesure et des corrections systématiques à opérer, qu'il s'agisse d'observations spatiales ou non spatiales ; l’analyse de ces mesures permet d’obtenir des résultats scientifiques sans oublier de nombreuses retombées sur les applications.

Cette stratégie est conçue pour démontrer l’utilité des observations et ainsi en favoriser la continuité. Elle va de la conception optimisée des systèmes à mettre en place jusqu'aux applications dans notre vie quotidienne. De très nombreux projets sont en cours d’exploitation et de nouveaux se profilent pour les décennies à venir.

Composé de scientifiques aussi bien juniors que seniors,

l’auditoire était représentatif de la diversité des

sujets abordés, des coopérations mises en place entre

équipes françaises mais aussi avec des laboratoires à

l’échelon international. Les témoignages Kurt Lambeck et

celui de Christopher Reigber étaient éloquents, notamment pour

les nombreux jeunes chercheurs venus les écouter.

Il semble que nous avons encore à mettre en exergue deux points essentiels.

Tout d’abord, la qualité exceptionnelle des ingénieurs et agents techniques et administratifs ; leur compétence était hors du commun dans le domaine difficile du traitement des données avec une approche métrologique qui nécessite une évolution constante des méthodes. C’est leur motivation qui doit être signalée ; sans elle, nous n’aurions pas été très loin. Cette excellence reconnue doit beaucoup à leurs qualités professionnelles et nous avons eu beaucoup de chance de travailler avec eux.

Un deuxième point à souligner est la nécessité de la transmission des connaissances d’une génération à l’autre. Il faut prendre conscience que c’est un problème difficile, il suppose qu’on puisse avoir une politique de recrutement continu, ce qui n’a pas toujours été le cas. Faire la « passe en arrière » comme au rugby prend du temps.

On ne peut que souhaiter « bon vent » au GRGS d’aujourd’hui et de demain.

François Barlier et Michel

Lefebvre.

Pour en savoir plus :

FAQ sur le champ de gravité terrestre

Mois d'Avril 2011

1/1 L’océan planétaire. Michèle Fieux - Recension de Guy Jacques

« L’océan

planétaire » est l’ouvrage en langue française de

référence en océanographie physique qu’il fallait, au

moment opportun et écrit par la personne adéquate.

Pourquoi ?

« L’océan

planétaire » est l’ouvrage en langue française de

référence en océanographie physique qu’il fallait, au

moment opportun et écrit par la personne adéquate.

Pourquoi ?

Revenons quelques décennies en arrière, dans les années 1960-1965 qui marquent le décollage de l’océanographie française sous l’impulsion de quelques maitres : Henri Lacombe et Paul Tchernia en physique, Alexandre Ivanoff en optique, Jean-Marie Pérès, Pierre Drach puis Paul Bougis en biologie. La plupart d’entre eux éditent des ouvrages généralistes de référence. J’ai souvent sollicité, en vain, mes collègues pour qu’ils ne quittent pas la scène de la recherche sans laisser une trace équivalente de l’enseignement qu’ils ont professé des années durant des décennies. Élève, héritière, de Paul Tchernia et de sa célèbre « Océanographie régionale », Michèle Fieux ne s’est pas laissée rebuter par la tâche.

Elle nous livre un traité imposant qui profite des découvertes majeures de cet âge d’or de l’océanographie et comme le traité de Tchernia, intéressera tous ceux qui, à l’instar d’Alexandre de Humboldt et de François Arago sont fascinés par les grands courants marins.

Cette très belle édition des Presses de l’École Nationale Supérieure de Techniques Avancées est un traité imposant : 421 pages et 413 figures toutes en couleur réalisées par Chantal Andrié qui doit être associée à cette réussite.

L’éditeur serait avisé s’il permettait un accès payant soit par achat d’un CD soit par téléchargement à ces précieuses images, d’autant qu’elles figurent en format relativement réduit dans l’ouvrage. Cette même critique concerne aussi la taille de la police du texte, notamment celle des légendes des figures en corps plus petit que celui du texte.

Le premier chapitre est consacré aux propriétés physiques

de l’océan : caractéristiques de l’eau de mer,

échanges de chaleur entre océan et atmosphère, masses

d’eau, moteurs de la circulation océanique, rôle du vent et

techniques d’observation. Les chapitres suivants décrivent

successivement l’océan Antarctique, l’Atlantique,

l’océan Indien et le Pacifique. J’aurais aimé que la

Méditerranée bénéficiât d’un chapitre

plutôt que de figurer dans les « mers annexes de

l’Atlantique ». C’est peut-être sentimental mais pas

uniquement. Mis à part les océanographes de l’Orstom qui

firent leurs premières armes dans l’Atlantique tropical,

physiciens, chimistes et biologistes métropolitains se sont

formés et ont apporté un maximum de connaissance sur la

Méditerranée occidentale. Il s’agit certes d’une

surface réduite à l’échelle de l’océan

planétaire mais elle présente des caractéristiques

originales qui a rapproché parfois de l’océan tropical

stratifié et, à d’autres moments, des zones de

plongée de l’Atlantique Nord. La conclusion illustre le concept

d’un océan planétaire dont la variabilité intervient

sur l’évolution climatique.

Cette « bible » de l’océanographie

physique, même si elle convient particulièrement aux

étudiants spécialisées, s’adresse aux

océanographes physiciens et biologistes, aux autres chercheurs des

sciences de l’environnement terrestre mais aussi au public cultivé

familier de la mer et qui souhaitent mieux connaitre son intimité. Il

peut en effet aussi être considéré comme un atlas, un

dictionnaire auquel on se réfère pour approfondir un point

particulier.

Éditeur : Les presses de l’Ensta, 2010.

Mois de Mars 2011

1/1 In-Memoriam

Le 4 mars, une fusée Taurus était censée

mettre sur orbite le satellite Glory. Le

cône de la fusée ne s’est pas détaché

correctement et le satellite est perdu.

Le 4 mars, une fusée Taurus était censée

mettre sur orbite le satellite Glory. Le

cône de la fusée ne s’est pas détaché

correctement et le satellite est perdu.

C’est le deuxième échec du même type, le précédent concernait le satellite OCO destiné, lui à l’observation du cycle du carbone.

Deux coups très durs pour la recherche climatique ! On ne discutera pas ici des questions de politique industrielle qui ont amené au choix d’une société privée pour ces lancements, mais il est clair que le métier d'exploitant de lanceurs est un métier difficile dans lequel, le risque zéro n'existe pas.

De la sorte, pour les utilisateurs, certaines "économies" peuvent coûter très cher. Un nouveau lancement est prévu en 2013 pour OCO, rien n’est prévu pour l’instant pour Glory.

Espérons qu’une solution de

remplacement sera trouvée rapidement mais, en tout état de cause,

ce sont plusieurs années d’observations

qui sont perdues.

Ce satellite emportait deux instruments importants pour la surveillance du

climat et la compréhension des mécanismes qui le

régissent.

TIM

TIM![]() était

destiné à assurer la poursuite de la mesure de

l’irradiance solaire totale, c'est-à-dire de la quantité

totale d’énergie d’origine solaire arrivant au sommet de

l’atmosphère.

était

destiné à assurer la poursuite de la mesure de

l’irradiance solaire totale, c'est-à-dire de la quantité

totale d’énergie d’origine solaire arrivant au sommet de

l’atmosphère.

Ces mesures ne sont réellement possibles avec une précision suffisante que depuis l’espace, car l’atmosphère absorbe et diffuse le rayonnement solaire.

Depuis une trentaine d’années, des instruments se sont relayés sur divers satellites, mais leurs périodes de recoupement et leur précision absolue, laissent encore trop d’incertitude quant aux variations de ce facteur clé du système climatique.

TIM est le plus

performant de ces instruments, un exemplaire en vol depuis 2003 semble

d’ailleurs conduire à une révision à la baisse de la

constante solaire. C’est dire l’importance qu’il y avait

à assurer la continuité de ces mesures et le recouvrement des

différents exemplaires, condition indispensable à

l’homogénéisation des séries de mesures.

L'instrument

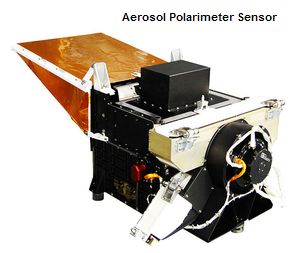

APS

L'instrument

APS ![]() , quant à lui,

devait mesurer le degré de polarisation du rayonnement solaire

réfléchi. Couramment, ce que mesurent les radiomètres

embarqués sur les satellites, c’est l’intensité du

rayonnement dans un intervalle spectral donné.

, quant à lui,

devait mesurer le degré de polarisation du rayonnement solaire

réfléchi. Couramment, ce que mesurent les radiomètres

embarqués sur les satellites, c’est l’intensité du

rayonnement dans un intervalle spectral donné.

La signature spectrale, c'est-à-dire la variation de l’intensité mesurée en fonction de la fréquence et l’intensité elle-même, permettent souvent mais pas toujours, de déterminer des propriétés essentielles de l’atmosphère ou des surfaces.

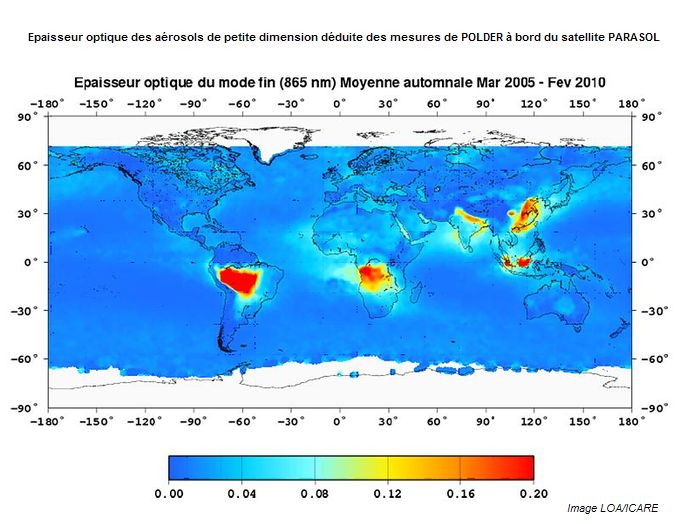

La polarisation du rayonnement est une information originale peu exploitée à l’exception de l’expérience française POLDER qui a volé à deux occasions à bord des satellites Japonais ADEOS, mais malheureusement pour de courtes périodes de quelques mois, et à bord du micro satellite PARASOL du CNES avec, cette fois, 6 années de mesures.

Les aérosols sont des particules en suspension dans l’atmosphère dont une partie est produite par l’activité humaine. En interagissant avec le rayonnement solaire, ils ont une influence climatique importante, et les aérosols d’origine anthropique ont très certainement contribué à diminuer le réchauffement provoqué par l’augmentation des gaz à effet de serre.

Ils sont assez aisément détectables

depuis un satellite, au dessus des surfaces sombres comme la mer, car ils

augmentent un peu la quantité de lumière réfléchie.

En revanche au dessus des surfaces continentales dont la réflectance est

variable et parfois élevée, ils ne sont plus détectables

par les méthodes traditionnelles, mais ils le sont au moyen de la

polarisation .

Le rayonnement solaire est constitué de ce qu’on appelle de la

lumière naturelle, c'est à dire non polarisée, cependant

quand ce rayonnement interagit avec la matière (gaz, liquide ou solide),

la lumière qui est diffusée présente une polarisation

partielle. Par exemple, la diffusion par les molécules de l’air

(diffusion dite de Rayleigh) polarise fortement la lumière . Par temps

clair, la lumière diffusée (le bleu du ciel) est donc

polarisée (les abeilles utilisent cette propriété pour se

diriger). Mais cette polarisation dépend fortement de l’angle de

diffusion, c'est-à-dire de l’angle entre la lumière

incidente et la lumière diffusée.

Les particules polarisent elles aussi, mais

à des degrés divers suivant leurs caractéristiques

optiques, et la dépendance angulaire de leur polarisation dépend

elle aussi de leur nature. C’est pourquoi il faut pouvoir mesurer le

rayonnement réfléchi en fonction de l’angle de diffusion.

Pour cela, on s’arrange pour que la même cible puisse être vue

sous différentes incidences lors de la progression du satellite.

On peut ainsi non seulement mesurer les concentrations

d’aérosols au dessus des surfaces continentales, mais on peut aussi

préciser leurs dimensions et distinguer le type de particules

sphériques ou non, et préciser leur nature.

Au dessus de la Chine, les fortes concentrations sont pour une bonne part dues à l’activité industrielle, les fortes concentrations observées au dessus de l’Amazone et de l’Afrique ou encore de l’Indonésie sont essentiellement dues aux feux de forêt et feux de brousse.

La mission PARASOL était prévue pour durer deux ans. En fait, ce satellite qui faisait partie du A-Train est resté dans le vol en formation de cette constellation pendant plus de 5 ans ; faute de carburant, il a fini par la quitter début 2010.

Même s'il ne fournit plus de mesures co-localisées avec celles des autres membres du A-TRAIN, l’instrument fonctionne encore en mars 2011. En ce sens, PARASOL est une grande réussite mais il n’a pas de successeur.

Parasol devait être remplacé au sein du E-TRAIN par l'instrument APS de GLORY, un remplaçant très avantageux puisque l’APS a des caractéristiques spectrales et angulaires nettement supérieures à celles de POLDER.

La perte de Glory est donc bien un coup dur pour la recherche climatique, c’est aussi un coup dur pour tous les chercheurs et étudiants impliqués dans ce projet.

On souhaite évidemment qu’une solution soit trouvée pour remplacer Glory au plus vite, mais les difficultés budgétaires de la NASA, comme celles d’ailleurs de toutes les Agences spatiales, ne rendent pas très optimistes.

Définitions :

![]() TIM : Total

Irradiance Monitor

TIM : Total

Irradiance Monitor

![]() ASP : Aerosol Polarimeter Sensor

ASP : Aerosol Polarimeter Sensor

Polder : Polarisation and Directionnality of Earth Reflectance

Parasol : Polarisation and Directionnality of Earth Reflectance

A-Train : Constellation de six satellites franco américains

Mois de Février 2011

1/3 Voyage dans l’anthropocène, cette nouvelle ère dont nous sommes les héros. Claude Lorius et Laurent Carpentier - Recension de Guy Jacques.

Ce livre est écrit par le glaciologue Claude Lorius, médaille d’or du CNRS et Laurent Carpentier, écrivain et spécialiste des questions environnementales, le « couple idéal » scientifique/journaliste qui cite dans cette catégorie Une mer sans poissons de Philippe Cury et Yves Miserey. La fluidité du texte, l’absence de la moindre équation, du moindre tableau, le dialogue en forme d’interview entre les deux auteurs dans l’épilogue porte la marque de cette association.

Il s’agit d’une très belle édition d’Actes

Sud, tant dans la mise en page, que par le choix des polices, la

qualité du papier, la séparation de chaque chapitre par de

superbes photos polaires en noir et blanc, la présence, en début

de chapitre, de quelques lignes soulignant l’esprit de chacun d’eux.

Une rareté pour un ouvrage de ce type. La poésie n’est pas

absente particulièrement dans la description des pôles et du lieu

de vie de Claude Lorius, le massif de Belledonne.

Appréciez la qualité du texte avec ces quelques extraits :

« Les neiges hivernales tapissent le massif de Belledonne. Le vent vient de là-bas, du Sud, apportant la rumeur de l’autoroute dans la vallée où la civilisation continue de foncer en aveugle »

« Nous aimerions pouvoir freiner, mais nous ne trouvons pas la pédale de frein. Nous aimerions trouver la sonnette d’alarme, mais bien d’autres avant nous s’en sont chargés en vain ; ces murailles sont dans nos têtes »

« Nous ne sommes ni fascinés par le monde d’antan, ni branchés en intraveineuse sur Radio Nostalgie »

« Les glaces », « Le secret »

et « L’Antropocène », les trois

premiers chapitres racontent, avec maintes anecdotes, l’aventure de Claude

Lorius, l’un des trois Enterrés volontaires au cœur de

l’Antarctique que conte avec émotion le réalisateur Djamel

Tahi dans le film éponyme qu’il faut absolument que vous voyez...

« L’Anthropocène » donne le ton au livre, les auteurs rappelant que s’il importait peu de polémiquer sur la date de son démarrage, on devait s’inquiéter de l’éventuelle proximité de sa fin, cette période géologique n’étant pas l’ère des humains mais un ère de crise ! Alors que l’Holocène représente le plus grand intervalle de stabilité du climat depuis 400 000 ans, avec une oscillation de la température d’environ 1 °C, les activités humaines depuis l’invention de la machine à vapeur en 1784 par James Watt provoquent un réchauffement climatique au-delà de cet intervalle en moins de trois cents ans, d’où le titre « L’accélération ».

Les chapitres suivants, « Le mur » et « Les crépuscules », mettent en exergue la gravité de la situation due à l’homme planétophage et à notre passivité, les auteurs s’efforçant de garder suffisamment d’optimisme pour intituler leur dernier chapitre « Le sursaut » sans l’accompagner du classique point d’interrogation qui eut indiqué leurs doutes.

La tonalité du livre est quand même empreinte de pessimisme teinté d’un brin de nostalgie, cette atmosphère étant magnifiquement illustrée par la réflexion de Lorius dans l’épilogue :

« La science ne peut sans doute pas nous sauver…mais sans la science, il est peu probable que nous soyons sauvés ».

Il ne croit pas à la géo-ingénierie et cloue au pilori ceux qui croient au dogme du progrès technique et de la croissance économique.

On aurait aimé un engagement plus clair pour un changement radical de vie, pour une décroissance.

Avec pudeur, Claude Lorius effleure seulement ce sujet tout en citant philosophes et penseurs d’une certaine contre-culture : le géographe et anarchiste Elisée Reclus, le philosophe transdisciplinaire enseignant l’écologie globale, Jacques Grinevald, sans compter Thomas Malthus, Hans Jonas, Jared Diamond et Edgar Morin.

Si nous avons parlé de pessimisme, plus exactement de désenchantement, c’est parce que sont seulement citées comme réussites collectives (« seule l’action collective est payante ») l’amélioration de la concentration de l’ozone stratosphérique depuis le protocole de Montréal et la signature du Traité de l’Antarctique. Pas suffisant face à l’épuisement des ressources planétaires !

2/3 Prix "Christian Le Provost, océanographe"

Le Prix Christian Le Provost,a été lancé le mardi 21 avril 2009 à l'initiative du Conseil Général des Côtes-d'Armor et de l'association costarmoricaine "Christian Le Provost, océanographe". Il était aussi soutenu par l'Ifremer, le CNES, le SHOM, l'IRD, l'Institut National des Sciences de l'Univers, la ville de Plérin sur Mer, le Club des Argonautes, et la COI.

Doté par le Conseil Général, d'un montant annuel de 7 000 euros, il a été remis en 2009 à Fabrice Ard'huin et en 2010 à Jérôme Vialard. Les cérémonies ont eu lieu au Conseil Général des Cotes d'Armor, dans le cadre d'une journée scientifique "Océanographie" en commun avec la commune de Plérin sur Mer.

Ce prix devient désormais un Grand Prix de l'Académie des Sciences, fondé par le CNRS, l'IFREMER, le CNES, l'IRD, le SHOM et le Conseil Général des Côtes d'Armor. Il sera biennal et doté de 15 000 euros.

C'est un succès pour l'Association Christian Le Provost et le Conseil Général des Côtes d'Armor qui en sont à l'origine et aussi pour le "Club des Argonautes" qui y a apporté son concours.

C'est aussi et surtout un juste hommage à Christian Le Provost dont la qualité des travaux scientifiques permet ainsi de mettre à l'honneur l'océanographie physique à travers ses plus brillants jeunes chercheurs.

L'objectif du prix reste inchangé : promouvoir la recherche en dynamique océanique dans toutes ses dimensions, qu’il s’agisse d’applications au climat, aux écosystèmes marins, à l’exploitation des ressources minérales, vivantes ou énergétiques dans les systèmes côtiers et hauturiers, qu’il s’agisse enfin d’études de processus, expérimentales ou de modélisation. Il est destiné à récompenser l’auteur de recherches conduites dans un laboratoire français pour des travaux remarquables en océanographie physique et biogéochimique.

Il sera remis à l'Académie de Sciences sous la coupole de l'Institut de France. La journée scientifique "Océanographie" sera maintenue par le Conseil général des Cotes d'Armor et aura lieu après la remise du prix.

L'année de lancement est 2011 et la date limite de dépôt des dossiers de candidature est fixée au 10 mars.

3/3 La vie, quelle entreprise ! – Pour une révolution écologique de l’économie de Robert Barbault et Jacques Weber - Recension de Guy Jacques

Écrit

par deux scientifiques :

Écrit

par deux scientifiques :

un écologue, Robert Barbault,

et un économiste et anthropologue, Jacques Weber ;

il s’agit d’un ouvrage qui dépasse le cadre purement scientifique.

Cette démarche engagée est amorcée par Barbault, auteur phare des ouvrages d’enseignement de sa discipline depuis une dizaine d’années avec notamment : "Pour que la Terre reste humaine" publié en 1999 en collaboration avec Dominique Bourg et Nicolas Hulot et "Un éléphant dans un jeu de quilles – L’homme dans la biodiversité" publié en 2008.

La complémentarité des deux auteurs leur permet de poser cette question : est-il inconscient de parler de nature, de parler de la biodiversité dans un contexte de crise économique et sociale ?...et d’y répondre en demandant à l’écologie de devenir plus réaliste et l’économie plus humaine.

Les trois premiers chapitres sont académiques mais relativement faciles

à aborder pour le profane grâce au style agréable et aux

anecdotes.

La biodiversité, rempart contre les attaques, portefeuille d’innovations devrait être protégée alors que l’homme tend à tout uniformiser.

La biodiversité ou, plus généralement, les écosystèmes, est comparée à une « entreprise » globale dont sont examinés le fonctionnement, l’organisation en réseau, les causes et effets de la crise qu’elle traverse, symptôme d’un pillage sans vergogne de ses ressources par le dernier arrivé sur la planète, l’Homme.

L’originalité du livre est à chercher dans les quatre

derniers chapitres dont les titres sont évocateurs :

L’appropriation du monde, Et l’Humain dans tout

ça ? Pour changer, renouer avec la nature,

Changer d’ère.

Les auteurs ne se limitent pas à des constats qu’il importait de mettre en lumière en se basant sur des faits incontestables. Partie de l’écosystème, l’Homme est en train de scier la branche sur laquelle il est installé oubliant que les ressources de la planète sont limitées et que la science, qui nous aidera encore, n’est pas toute puissante, pas plus que l’Homme n’est un extra-terrestre. S’appuyant sur l’exemple de l’agriculture, fil conducteur de l’ouvrage, les auteurs prônent de renouer avec la nature tout en évitant la vision passéiste d’un retour vers les sociétés primitives que l’on retrouve dans les écrits des écologistes radicaux. Ils préconisent une agriculture soutenable et le recours à des industries vertes. Leur conclusion est bien qu’il faut enfin changer d’ère, rendre la science aux citoyens et jeter le PIB aux oubliettes.

En ce sens, le livre La vie, quelle entreprise ! – Pour une

révolution écologique de l’économie peut être

rapproché de deux autres œuvres également écrites par

des biologistes :

La Condition tropicale – Une histoire naturelle, économique et sociale des basses latitudes de Francis Hallé (2010)

et Virer de bord – Plaidoyer pour l’homme et la planète de Guy Jacques (2011).

Ces ouvrages peuvent se prévaloir de la démarche suivie par Hallé qui rappelle « qu’à soixante-dix ans, il s’estime autorisé à porter un regard global sur l’existence ».

Nous ne pouvons que conseiller la lecture de ce petit ouvrage sans figures ni

tableaux, ni photos, car il est temps, espérons-le pas trop tard, que

les écologues s’engagent dans une démarche

« politique », comme ont su le faire auparavant les

climatologues.

Deux légères réserves peuvent être faites à cet ouvrage logiquement publié dans la collection « science ouverte ».

L’une concerne la présentation, avec un excès d’encarts qui rompent la fluidité de la lecture sans être toujours indispensables.

L’autre, un credo un peu excessif en une solidarité écologique planétaire « pour peu que l’on apprenne, comme nous le montrent les agricultures paysannes, à s’appuyer sur ses forces et ses ressources sans la piller inconsidérément ; pour peu que les États et autres organisations mondiales revues et corrigées assument leurs responsabilités ; alors, oui, on peut le faire ! »

Mois de Janvier 2011

1/2 L’année 2010 : un excellent cru pour appréhender la complexité climatique

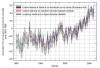

De nombreuses agences à travers le monde : NASA, NOAA pour les USA, l’Agence Météorologique Japonaise et le Hadley Center du Met Office britannique convergent.

L’année 2010 fut l’année la plus chaude sur Terre depuis 1880. A égalité ou légèrement au-dessus de ce que fut l’année la plus chaude, précédente 2005 (dans la marge d’incertitude). C’est la 34ème année consécutive dont la température globale se situe au-dessus de la moyenne du vingtième siècle.

Et pourtant, souvenons-nous qu'à la fin de l’hiver 2010, qui fut

froid en France et en Europe de l'ouest, un rush d’illustres

climato-sceptiques profita de cette « anomalie »

froide incontestable pour brocarder les

« réchauffistes » : ces climatologues

représentants d’une pseudo-science qui ne bénéficie

pas de la pureté disciplinaire !

Profitant de ce que 1998 fut une année chaude, ils

affirmèrent alors qu’il n’y avait plus depuis cette date de

réchauffement, voire qu’il y avait même refroidissement. Et

au diable, l’effet de serre et vive le rayonnement solaire ! Pourtant

l’année 2010 bat, comme 2005, sans ambigüité

l’année 1998. Souvenons-nous aussi de ces récents mois de

novembre et décembre 2010 bien frisquets en France et en Europe et qui

mettent à tort, la météo en procès.

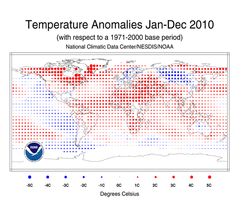

Il faut en retenir une

première leçon : pas plus qu’ils ne sont le centre du

monde, la France et l’Europe n’imposent leurs caractères

climatiques. Un coup d’œil à la carte de la figure ci-contre

(cliquer sur l'image pour l'agrandir) met en

évidence, que s’il a fait anormalement froid en Europe en 2010

(points bleus)il n’en fut pas de même dans le reste du monde

où l’anomalie de température est nettement positive

(points rouges). Et la moyenne résultante s’est traduite par un

réchauffement moyen incontestable.

Il faut en retenir une

première leçon : pas plus qu’ils ne sont le centre du

monde, la France et l’Europe n’imposent leurs caractères

climatiques. Un coup d’œil à la carte de la figure ci-contre

(cliquer sur l'image pour l'agrandir) met en

évidence, que s’il a fait anormalement froid en Europe en 2010

(points bleus)il n’en fut pas de même dans le reste du monde

où l’anomalie de température est nettement positive

(points rouges). Et la moyenne résultante s’est traduite par un

réchauffement moyen incontestable.

Deuxième leçon : les dynamiques

météorologiques et climatiques sont complexes et sont sans

conteste pluri, voire omni disciplinaires ce qui sans doute, leur porte tort.

Auguste Comte, un homme d’ordre, qui aimait la classification des

disciplines (comme les géologues ?) n’avait donc pas pris en compte

la météorologie ou l’océanographie dans sa

classification, pour « indiscipline » pourrait-on dire.

Complexe, cela veut dire quoi ? Que la dynamique du climat met en jeu les interrelations et les échanges qui existent entre les différents acteurs du système climatique : le soleil et même la lune, l’atmosphère, l’océan, la Terre solide, le milieu marin vivant et continental, la cryosphère… chaque élément ayant ses échelles temporelles de variations qui interfèrent avec les autres….Alors qu’il fasse plus froid en Europe lorsqu’il fait plus chaud au Groenland ou au Québec il n’y a là rien d’étonnant. Pas étonnant non plus, que si l’accroissement des gaz à effet de serre dans l’atmosphère se fait de manière constante et homogène, les variations de température se fassent de manière hétérogène dans l’espace et irrégulières dans le temps en un endroit donné.

Le réchauffement global n’efface pas la variabilité

naturelle du climat, ni dans le temps, ni dans l’espace. Le

problème est de savoir s’il en modifie la fréquence ou

l’intensité. L’année 2010 est particulièrement

intéressante pour l’illustrer.

Les hivers européens et la

« NAO »

Chacun est familiarisé avec la pression atmosphérique comme

paramètre météorologique et nul n’ignore le poids de

l’anticyclone des Açores (haute pression) évoqué dans

tous les bulletins météorologique de la télévision.

Moins souvent évoquée mais non moins importante est la zone dépressionnaire d’Islande. La différence de pression entre les deux est un indicateur du temps qu’il fait sur l’Europe de l’ouest. Surtout en hiver.

Plus

la différence de pression entre les deux est élevée, plus

l’Europe de l’ouest à nos latitudes est exposée aux

vents d’ouest océaniques, y apportant en hiver un temps doux et

humide. A l’inverse (différence de pression faible), nous nous

trouvons exposés à des descentes d’air polaire et donc

à des hivers froids.

Plus

la différence de pression entre les deux est élevée, plus

l’Europe de l’ouest à nos latitudes est exposée aux

vents d’ouest océaniques, y apportant en hiver un temps doux et

humide. A l’inverse (différence de pression faible), nous nous

trouvons exposés à des descentes d’air polaire et donc

à des hivers froids.

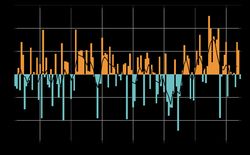

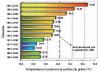

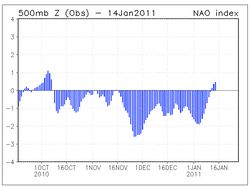

On appelleindice NAO, l'anomalie (équivalent scientifique du mot écart)de cette différence de pression par rapport à sa valeur moyenne :

anomalie positive = hiver doux,

anomalie négative = hiver froid.

Ainsi l’anomalie moyenne fut-elle de - 4.38 de décembre 2009 à Mars 2010. Une des plus négatives depuis I873.

La figure de droite montre aussi que la NAO fut fortement négative entre le 15 novembre 2010 et le 15 janvier 2011. Il fit donc froid durant ces périodes en France sans que cela ne mît en cause le record de l’année 2010, ni le réchauffement global qu’illustre la première figure.

Il n’y a pas de périodicité bien établie des variations de la NAO qui est plutôt d’ordre décennal.

C’est d’ailleurs la permanence pendant plusieurs

hivers de suite, d’une NAO fortement négative (comme le montre la

figure de gauche), qui explique la baisse ou la stagnation de la

température visible sur la première figure, entre 1950 et la fin

des années 1970..

El Niño/La Niña et les

inondations australiennes

Le phénomène El

Niño et son contraire La Niña ont une plus grande

notoriété que la NAO mais il s’agit aussi d’une

oscillation climatique liée aux interactions entre

l’océan et l’atmosphère.

On caractérise cette oscillation par les différences de pression atmosphérique entre l’ouest (pression basse) et l’est (pression élevée) du Pacifique équatorial. Et l’indice que l’on utilise, indice ENSO est l’anomalie de cette différence de pression.

Lorsque cette anomalie est fortement négative (diminution de la différence de pression atmosphérique entre l’est et l’ouest du Pacifique) les alizés qui soufflent d’est en ouest, faiblissent ou s’annulent et les eaux chaudes qu’ils accumulent normalement à l’ouest (Warm Pool) s’étendent le long de l’équateur d’ouest en est jusqu’aux côtes du Pérou/Chili, y amenant pluie et inondations y compris dans le très sec désert d’Atacama. Et corrélativement, la sécheresse sévit sur la côte est de l’Australie et en Indonésie avec parfois des incendies spectaculaires comme ce fut le cas en 1983.

Dans la situation inverse (anomalie positive), les alizés se renforcent, les eaux chaudes s’accumulent à l’ouest avec pluies abondantes sur l’Australie et l’Indonésie et le littoral du désert d’Atacama retrouve ses eaux froides et sa sécheresse.

En 2010 on est passé en juillet d’une situation Niño à une situation Niña qui n’a fait que s’accentuer, d’où normalement des pluies abondantes sur l’Australie. Aucune anomalie (au sens commun) qualitative donc.

Pour la Nao et les hivers européens comme pour La Niña et les

inondations en Australie de 2009/2010, on pourrait donc dire a priori : rien de

nouveau sous le soleil climatique et les choses suivent leur cours normal.

Cependant, si le réchauffement global, que l’on ne peut nier,

n’efface pas les variations climatiques naturelles aux diverses

échelles de temps, il peut en modifier le rythme et l’amplitude.

L’ampleur exceptionnelle des inondations australiennes actuelles liées à La Niña est-elle appelée à devenir désormais la norme ? Il ne fait pas de doute, par exemple, que le réchauffement observé de la température de surface de l’océan dans l’ouest du Pacifique, lié lui au changement global, est de nature à amplifier les précipitations en période La Niña.

Il n’est pas impossible non plus que le réchauffement global qui équivaut à une augmentation de l’énergie dans la troposphère se traduise par des modifications durables de la NAO, des circulations atmosphériques et océaniques associées, et donc des climats correspondants !

Qu’il fasse plus froid en hiver en France, à cause du réchauffement global ne serait pas forcément surprenant d’autant qu’il ne faut pas oublier que le transport océanique de chaleur des régions équatoriales vers l’Arctique dans l’Atlantique, via le Gulf Stream et la dérive Nord Atlantique est corrélé positivement à la NAO à quelques mois d’intervalle.

À une

anomalie de NAO élevée correspondra quelques mois plus tard un

transport océanique de chaleur vers le nord plus important et

réciproquement : une rétroaction positive en quelque sorte.

A ce jour, nul ne peut répondre à ces questions, si ce

n’est que l’énergie complémentaire apportée par

l’effet de serre doit bien se dissiper, d’où une

probabilité accrue d’évènements extrêmes, voire

de la force du vent en moyenne à la surface de la Terre. Au-delà

de son importance pour l’humanité, cela fait de la question

climatique un problème scientifique passionnant qui devrait

susciter des vocations.

2/2 Vient de paraître : Qu’est-ce que l’Écologie ? Une définition scientifique. Par Guy Jacques, membre du Club des Argonautes, aux éditions Vuibert

Pourquoi un tel point d’interrogation dans le titre ?

C’est que le mot écologie est devenu très ambigu :

science à l’origine, il évoque maintenant pour la

majorité des gens la politique, au point que les scientifiques qui se

disaient écologistes à l’origine se disent maintenant

écologues pour se démarquer des militants écologistes qui

font souvent oublier que l’écologie est bel et bien une science.

Pourquoi un tel point d’interrogation dans le titre ?

C’est que le mot écologie est devenu très ambigu :

science à l’origine, il évoque maintenant pour la

majorité des gens la politique, au point que les scientifiques qui se

disaient écologistes à l’origine se disent maintenant

écologues pour se démarquer des militants écologistes qui

font souvent oublier que l’écologie est bel et bien une science.

D’où le sous-titre bienvenu : « une définition scientifique ». C’est même la science la plus complexe qui soit puisqu’elle met en jeu la quasi-totalité des disciplines qui se consacrent à la Terre : de la géologie à toutes les sciences biologiques en passant par les sciences de l’atmosphère, de l’eau, des sols et les sciences physiques et chimiques qui règlent leur dynamiques et leurs interactions.

Il ne s’agit pas seulement de « pluri », mais quasiment d’ « omnidisciplinarité ».

Sans oublier évidemment les sciences dites humaines, car l’homme inclus dans les écosystèmes, en est évidemment un acteur : il interagit avec leurs autres composantes et contribue à les faire évoluer. Car les « écologistes » ont tendance à l’oublier : les écosystèmes, avec ou sans l’homme, ne sont pas immuables et ne cessent d’évoluer. Mais l’homme a une capacité d’ « action » à nulle autre pareille, qui peut lui être nuisible.

Il est aussi doté d’une conscience et

d’une intelligence qui lui confèrent une responsabilité

particulière dans l’évolution des écosystèmes

et même de l’écosystème terrestre dans sa

globalité. D’où le passage obligatoire de

l’écologie scientifique à l’écologie politique

pourvu qu’elle reste rationnelle. C’est l’objectif de ce livre

agréable à lire, clair et d’une concision remarquable compte

tenu de la complexité du sujet.