Les News

Novembre 2015

1/1 Quoi de neuf sur la planète blanche ? Comprendre le déclin des glaces et ses conséquences de Bernard Francou & Christian Vincent. Recension de Bernard Pouyaud

Après «Les glaciers à l’épreuve du climat – 2007, IRD-Éditions» et leur participation à l’ouvrage collectif

«Glaciers, forces et fragilités – 2007-Editions Glénat», Bernard Francou

(directeur de recherche émérite de l’IRD au Laboratoire d’étude des transferts

en hydrologie et dans l’environnement – LTHE) et Christian Vincent (ingénieur

de recherche du CNRS au Laboratoire de glaciologie et de géophysique de

l’environnement – LGGE) publient ce nouvel opus sur la «planète

blanche».

Après «Les glaciers à l’épreuve du climat – 2007, IRD-Éditions» et leur participation à l’ouvrage collectif

«Glaciers, forces et fragilités – 2007-Editions Glénat», Bernard Francou

(directeur de recherche émérite de l’IRD au Laboratoire d’étude des transferts

en hydrologie et dans l’environnement – LTHE) et Christian Vincent (ingénieur

de recherche du CNRS au Laboratoire de glaciologie et de géophysique de

l’environnement – LGGE) publient ce nouvel opus sur la «planète

blanche».

La glace est l’un des indicateurs les plus sensibles du changement climatique et Bernard Francou et Christian Vincent, scientifiques et hommes de terrain, nous rapportent les dernières nouvelles de cette cryosphère soumise au réchauffement du climat. L’effet, indéniable, du changement climatique dans les zones englacées montre toutefois des situations contrastées :

Certains massifs bougent peu : c’est notamment le cas de l’Antarctique de

l’Est, où se trouvent le volume de glace de loin le plus important de la

planète. C’est aussi le cas de la banquise antarctique, qui tend même à croître

par endroits.

En revanche, la calotte Ouest de l’Antarctique est fragilisée.

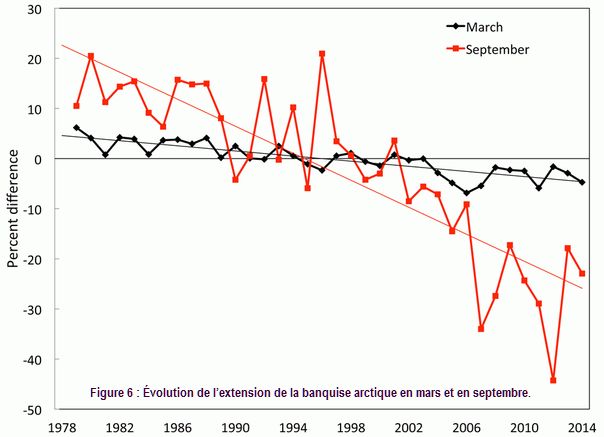

Du côté de l’Arctique, la banquise a perdu 40% de sa surface en fin d’été

depuis la fin des années 1970, le Groenland fond et le pergélisol est également

touché.

Les manteaux neigeux hivernaux, quant à eux, se rétrécissent : dans la moyenne

montagne alpine, la couche a diminué très sensiblement en cinquante ans.

A l’ouest de la chaîne Himalaya-Karakoram, certaines masses glaciaires restent

stables. En revanche, d’autres glaciers déclinent rapidement, en Alaska,

Patagonie, dans une partie de l’Himalaya et dans les Alpes, sans parler de ceux

des latitudes tropicales, à l’agonie.

Cette régression globale des glaces se traduit par la montée du niveau des mers et elle a des conséquences multiples sur la circulation océanique, les régimes hydrologiques, la ressource en eau, et même le tourisme… En montagne, le recul des glaciers augmente les risques naturels liés à la formation des lacs pro-glaciaires et au réchauffement des glaciers à haute altitude posés sur des versants raides.

En tentant de répondre aux questions que pose l’inégal recul des glaces, les auteurs exposent les scénarios de réchauffement – étroitement liés aux activités humaines – envisagés par les modèles climatiques. Ce livre est ainsi un outil de sensibilisation à la crise majeure de notre temps.

Octobre 2015

1/1 La COP 21, ou en est-on ? Bruno Voituriez

Suite à la

conférence de Rio, dite du sommet de la Terre, a été adoptée en 1992 la Convention Cadre des Nations Unies sur les

Changements Climatiques (CCNUCC), qui est

entrée en vigueur en mars 1994. Depuis se tient chaque année, pour le suivi de

cette convention, une Conférence des parties appelée COP (Conference Of

Parties). C’est la COP3 en

1997 qui aboutit au «Protocole de

Kyoto» entré en vigueur en 2005 après avoir été ratifié par le

nombre requis d’états (55 états).

Suite à la

conférence de Rio, dite du sommet de la Terre, a été adoptée en 1992 la Convention Cadre des Nations Unies sur les

Changements Climatiques (CCNUCC), qui est

entrée en vigueur en mars 1994. Depuis se tient chaque année, pour le suivi de

cette convention, une Conférence des parties appelée COP (Conference Of

Parties). C’est la COP3 en

1997 qui aboutit au «Protocole de

Kyoto» entré en vigueur en 2005 après avoir été ratifié par le

nombre requis d’états (55 états).

Ce protocole visait à mettre en œuvre les moyens de répondre à l’objectif de l’article 2 de la convention :

«L’objectif ultime de la présente Convention et de tous instruments juridiques connexes que la Conférence des Parties pourrait adopter est de stabiliser, conformément aux dispositions pertinentes de la Convention, les concentrations de gaz à effet de serre dans l’atmosphère à un niveau qui empêche toute perturbation anthropique dangereuse du système climatique».

Par ce protocole, 42 pays développés et en transition vers l’économie de marché s’engageaient à réduire leurs émissions de gaz à effet de serre de 5,2% par rapport à 1990, à l’horizon 2012, échéance du protocole (dont les USA s’étaient exclus). De COP en COP il apparut que cet objectif ne serait pas atteint et qu’il fallait impérativement donner une suite au protocole de Kyoto après 2012 d’autant que des pays, comme la Chine qui n’était pas alors astreinte à des réductions, devenaient de très gros producteurs de gaz à effet de serre. C’était l’objectif de la COP15 à Copenhague en 2009. Cette COP tourna à la foire d’empoigne et comme il était clair qu’il n’y aurait aucune possibilité d’accord sur de nouvelles réductions d’émissions on changea de paradigme, on se mit d’accord sur un objectif de température: une augmentation de 2°C par rapport à l’ère préindustrielle fut déclarée seuil à ne pas dépasser pour empêcher toute perturbation anthropique dangereuse du système climatique selon les termes de la CCNUCC. Cela fut confirmé en 2010 à la COP16 de Cancun qui certifia en outre que c’était consistent scientifiquement.

Vint l’année 2012, échéance du protocole

de Kyoto et la COP18 de Doha en

décembre 2012 où il fut décidé de prolonger de huit ans (jusqu’en 2020) le

protocole de Kyoto. Avec obligation d’arriver à un nouvel accord à mettre en

œuvre à partir de 2020. C’est l’objectif de la COP 21 à

Paris que d’accoucher de cet accord. L’enjeu est donc d’importance et les COP

précédentes (19 en Pologne, 20 au Pérou) eurent pour objet de préparer cet

accord.

Vint l’année 2012, échéance du protocole

de Kyoto et la COP18 de Doha en

décembre 2012 où il fut décidé de prolonger de huit ans (jusqu’en 2020) le

protocole de Kyoto. Avec obligation d’arriver à un nouvel accord à mettre en

œuvre à partir de 2020. C’est l’objectif de la COP 21 à

Paris que d’accoucher de cet accord. L’enjeu est donc d’importance et les COP

précédentes (19 en Pologne, 20 au Pérou) eurent pour objet de préparer cet

accord.

L’objectif claironné est donc de limiter à 2°C l’augmentation de la température par rapport à l’époque préindustrielle en changeant de méthode:

- ne pas imposer des réductions d’émission mais demander à chaque état d’établir son plan de réduction,

- faire la somme de toutes les propositions

- et voir si c’est compatible avec l’objectif 2°C

195 pays sont parties prenantes et l’ONU avait fixé au premier octobre 2015 la date limite de dépôt des contributions nationales pour qu’elles puissent être analysées avant la conférence. Le 2 octobre, 146 pays avaient remis leur copie, ce qui représente 87% des émissions de gaz à effet de serre. Huit des dix plus gros contributeurs ont remis leur contribution (dont l’Europe qui se présente groupée). Il manquait encore l’Iran et l’Arabie Saoudite. Le “Ad hoc working group on the Durban platform for enhanced action” (ADP) qui est l’organe chargé de proposer un accord aux états membres, a publié le 5 octobre un «draft agreement», prélude à un accord définitif lors de la COP21. Ce «draft agreement» a encore, en langage diplomatique, le statut de «non paper».

Les points principaux concernent :

L’atténuation : réduction des émissions de gaz à effet de serre de manière à limiter l’augmentation de température.

L'’adaptation : accroître la résilience et diminuer la vulnérabilité.

Les pertes et dommages.

C’est un élément récent soulevé par les pays les plus vulnérables au changement climatique, pour que les conséquences du changement climatique sur la durée, comme l’élévation du niveau de la mer, soient pris en compte. Il était au programme de la COP18 de Doha en 2012. À la COP19 de Varsovie en 2013 the “Warsaw International Mechanism for Loss and Damage associated with Climate Change Impacts“ a été créé et son programme fut fixé à la COP suivante de Lima en 2014.Le développement et le transfert de technologie des pays riches vers les pays en développement.

La finance, sans doute le point le plus épineux puisqu’il est politique et qu’il s’agit pour les pays riches de financer les pays en développement pour les aider à diminuer leurs émissions, s’adapter, adopter de nouvelles technologies, remédier à leurs dommages etc…

Les COP 15 et 16 (Copenhague, Cancun) ont décidé pour se faire de créer «Un fond vert pour le climat» à destination des pays en voie de développement avec comme objectif d’atteindre 100 milliards de dollars par an à partir de 2020. Lors de sa déclaration à la «troisième conférence internationale sur le financement du développement» qui s’est tenue à Addis Abeba en juillet 2015, la Directrice du Fond vert pour le climat a fait état d’un financement de 10 milliards de dollars acquis en 2014. Elle a rappelé l’engagement pris pour atteindre l’objectif de 100 milliards en 2020 confirmé par le G7 en juin 2015. Il y a manifestement un grand pas à franchir. Elle a ajouté que 400 milliards de dollars par année sont nécessaires pour rendre résilients et écologiques les investissements à long terme des pays en développement. Le conseil d’administration du Fond vert prendra des décisions de financement pour les premières propositions de projets qui lui ont été faites à sa prochaine prochaine réunion à Livingstone, en Zambie, en novembre 2015 immédiatement avant la conférence COP21.

Le point essentiel qui conditionne tout, c’est évidemment la réduction des émissions (atténuation en français, mitigation en anglais) car plus on réduit, plus facilement on s’adapte et moins on subit de dommages….

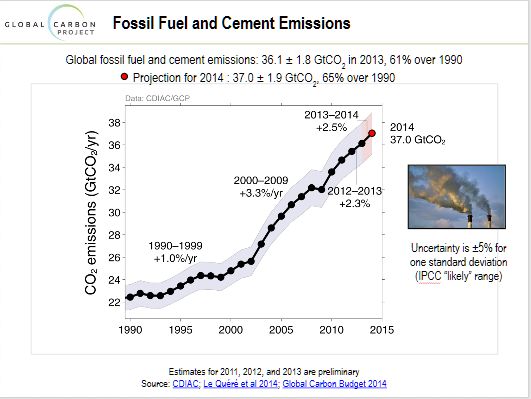

Pour mesurer l’amplitude de la tâche il faut avoir conscience que depuis 1990, en dépit du protocole de Kyoto les émissions de CO2 ont augmenté de 65% et qu’elles s’accroissent chaque année au rythme de 2,5% par an.

Actuellement on se trouve sur une trajectoire qui, d’après le GIEC, conduit à un accroissement de température à l’horizon 2100 entre 3,2 et 5,4°C. Pour limiter la hausse à 2°C il faudrait dès maintenant une décroissance des émissions de 3% par an.

Les contributions des états au fur et à mesure qu’elles arrivent sont

disponibles sur le site:

http://unfccc.int/.../cop21/fre/07f.pdf

Ainsi les USA annoncent-ils pour 2025 une diminution de leurs émissions de 28% par rapport à 2005 et l’Europe une réduction de 40% en 2030 par rapport à 1990.

Manifestement les annonces déjà faites sont ambitieuses et elles ont l’avantage cette fois d’être «bottom-up» c'est-à-dire faites par les états et non plus «top- down» c'est-à-dire dictées par un quelconque comité d’experts. L’analyse de ces contributions qui couvriront au moins 90% des émissions est en cours et il est prématuré d’en tirer une conclusion par rapport aux objectifs affichés. Mais la volonté des états est manifeste et les ambitions déjà affichées sont grandes. Il ne s’agit pour l’instant que d’annoncer les objectifs, ce qui est facile, et les modalités pour les atteindre ne sont pas précisées. Il ne faudrait pas que l’adage bien connu «les promesses n’engagent que ceux à qui elles sont faites» réédite l’échec du protocole de Kyoto ou que l’horizon de la prochaine échéance électorale qui est celui des politiques minimise les engagements pris.

Enfin il ne faut pas oublier que l’objectif 2°C est plus un slogan politique pour mobiliser les médias qu’un fait scientifique et qu’il y a, quel que soit le scénario d’émissions qui sortira de l’addition des contributions nationales, une incertitude qui pourrait servir de prétexte à des querelles politiques intéressées et contre productives.

Sans dramatiser à l’extrême («C’est le rendez vous de la dernière chance», «l’enjeu ce n’est pas la qualité de la vie, c’est la vie»), il ne fait pas de doute qu’il y a urgence à modérer au maximum le changement climatique et donc à entreprendre au plus vite une réduction drastique des émissions de gaz à effet de serre faute de quoi, non la vie ne disparaîtra pas, mais l’homme s’exposera à de très graves difficultés.

Pour plus d'information sur l'histoire de la prise de conscience des risques de modification du climat de la Terre par l'homme qui a conduit à la mise en place progressive d’organisations mixtes, scientifiques et gouvernementales, de plus en plus proches du monde politique, impliquant des grandes institutions scientifiques internationales, des agences des Nations Unies mais aussi des organisations représentant la société civile, voir le chapitre 11 du livre "Le changement climatique : histoire et enjeux", publié sur ce site.

Voir aussi la News de mars 2015: La COP 21 Paris - décembre 2015. Le seuil de 2°C : un artifice ?

Août 2015

1/1 Claude Frankignoul, un océanographe physicien français à l’honneur

Par Jacques Merle, Yves Dandonneau, Bruno Voituriez

Claude Frankignoul a été honoré en 2015 de la «Sverdrup gold medal award» par le jury de l’American Meteorological Society (AMS). Il est le premier océanographe français à être distingué par une aussi haute instance internationale pour ses travaux et sa renommée scientifique.

Diplômé ingénieur

en mathématiques et en sciences appliquées de l’Université de Liège,

il a passé sa thèse en 1972 sous la direction de Jacques

Nihoul. Au début des années 1970 ses premiers travaux sur les

ondes internes océaniques lui valurent d’être invité en qualité de

«visiting scientist» à Woods Hole aux USA, avant d’aller à

Hamburg. C’est à cette époque qu’il se fit connaitre de la communauté

scientifique océanographique internationale par un article, en collaboration

avec Klaus Hasselmann du Max Planck Institut

de Hambourg, qui eut un certain retentissement à l’époque. Les deux auteurs

rendaient compte pour la première fois, à l’aide d’un modèle unidimensionnel

simple, du comportement global de l’océan superficiel sous l’action de

l'atmosphère. Par analogie avec le spectre de la lumière visible, ils

trouvèrent que l’océan répond «rouge » (basses fréquences) à un

forçage atmosphérique «blanc» (multifréquences). C’est ce qui donne à

l’océan un rôle de «filtre passe-bas» réhabilitant ainsi son rôle dans

la variabilité climatique, beaucoup plus lente que «le bruit»

atmosphérique.

Diplômé ingénieur

en mathématiques et en sciences appliquées de l’Université de Liège,

il a passé sa thèse en 1972 sous la direction de Jacques

Nihoul. Au début des années 1970 ses premiers travaux sur les

ondes internes océaniques lui valurent d’être invité en qualité de

«visiting scientist» à Woods Hole aux USA, avant d’aller à

Hamburg. C’est à cette époque qu’il se fit connaitre de la communauté

scientifique océanographique internationale par un article, en collaboration

avec Klaus Hasselmann du Max Planck Institut

de Hambourg, qui eut un certain retentissement à l’époque. Les deux auteurs

rendaient compte pour la première fois, à l’aide d’un modèle unidimensionnel

simple, du comportement global de l’océan superficiel sous l’action de

l'atmosphère. Par analogie avec le spectre de la lumière visible, ils

trouvèrent que l’océan répond «rouge » (basses fréquences) à un

forçage atmosphérique «blanc» (multifréquences). C’est ce qui donne à

l’océan un rôle de «filtre passe-bas» réhabilitant ainsi son rôle dans

la variabilité climatique, beaucoup plus lente que «le bruit»

atmosphérique.

Il passe ensuite 5 années au MIT. Au début des années 1980 il est candidat et obtient le poste de professeur d’océanographie ouvert à l’université Pierre et Marie Curie à Paris (UPMC), succédant au professeur Ivanoff et assurant ainsi le seul enseignement universitaire d’océanographie physique en France à cette époque.

Claude Frankignoul s’attaque alors à la réorganisation et la réorientation de cet enseignement avec toute la rigueur et l'excellence dont il est porteur. Mais n’étant pas un fervent admirateur de l’administration française, même lorsqu’elle s’applique à la gestion de l’enseignement supérieur et la recherche, il éprouve quelques difficultés dans ce travail. Il réussit néanmoins à mettre sur pied un enseignement de grande qualité en licence et DEA (master), en coopération avec le Laboratoire de Physique des Océans (LPO) de l’Université de Bretagne Occidentale (UBO), assurant ainsi la formation en océanographie de plusieurs dizaines d’étudiants par an, français et étrangers.

En 1985 il est un des principaux animateurs d’un rassemblement des

océanographes physiciens sur le site de Paris, qui deviendra une Unité Mixte de

Recherche (UMR) : Le Laboratoire d’Océanographie Dynamique et de

Climatologie (LODYC), associant l’UPMC, le CNRS et

l’ORSTOM

et s'intégrant ultérieurement dans l’Institut Pierre-Simon Laplace

(IPSL). Dès lors il aménage son calendrier d’activité pour assurer son

enseignement à Paris durant l’année scolaire et se consacre entièrement à la

recherche tous les étés à Woods Hole en sa qualité de adjunct

scientist».

En 2000 il devient membre de l’Institut Universitaire de France (IUF),

occupant la chaire d’océanographie physique et de climatologie. Il est ainsi

partiellement libéré de ses tâches d’enseignement et peut se consacrer

davantage à la recherche. Son domaine principal reste le forçage stochastique

atmosphérique de l’océan, sa réponse sur la dynamique de l’atmosphère et son

rôle dans la variabilité basse fréquence du climat. Mais dans un lot de plus de

150 études qu’il a publiées dans les meilleurs journaux scientifiques

internationaux ou auxquels il a contribué, il apporte également des résultats

fondamentaux sur la connaissance de la dynamique de l’Atlantique nord, la

circulation thermohaline, les courants de bord ouest, l’AMOC « Atlantic

Meridional Overturning Circulation », la NAO « North Atlantic Oscillation »…etc

; autant de questions qui sont au cœur de la recherche actuelle la plus

pointue sur le rôle de l’océan dans le changement climatique.

Mai 2015

1/1 Une histoire des sciences de la planète «Terre»de Alain Giraud-Ruby - Recension de Michel Petit

Avec Une histoire des sciences de la planète

«Terre», qui vient de paraître chez Actes Sud, Alain

Giraud-Ruby poursuit son histoire des sciences commencée en 2010, avec Le

Ciel dans la tête, une histoire de l'Astronomie et il espère compléter ces deux

approches avec La tête sur les épaules, une histoire de la Physique...

Avec Une histoire des sciences de la planète

«Terre», qui vient de paraître chez Actes Sud, Alain

Giraud-Ruby poursuit son histoire des sciences commencée en 2010, avec Le

Ciel dans la tête, une histoire de l'Astronomie et il espère compléter ces deux

approches avec La tête sur les épaules, une histoire de la Physique...

Ces livres, écrits «ni pour les spécialistes, ni par un spécialiste», racontent l’histoire des sciences de façon vivante et humaniste. L'objectif est de mêler de façon originale, essai littéraire et vulgarisation scientifique pour dépasser «l’antagonisme traditionnel entre ces deux façons d’écrire» comme le souhaitait Stephen Jay Gould.

À travers une lecture fort agréable dont les

qualités didactiques sont évidentes, le lecteur découvre que l'histoire des

sciences est sans doute la voie la plus directe et la plus agréable pour

enrichir sa culture scientifique. Tous ceux, et ils sont nombreux, dont la

recherche n’est pas ou ne sera jamais le métier, mais qui s'intéressent à la

science, soit parce qu'ils l'enseignent, soit par goût personnel, ou pour toute

autre raison, découvriront les liens entre science et société, souriront des

anecdotes, ou s’irriteront le cas échéant, des sarcasmes iconoclastes.

L'ouvrage comme le précédent qui approchait l'astronomie de manière parfois

décapante, propose de nombreuses anecdotes, des plaisantes digressions, des

images métaphoriques ou iconographiques, des souvenirs personnels que l'auteur

a pu vivre personnellement avec la découverte de la tectonique des plaques ou

du réchauffement climatique.

Il s'agit comme le précédent d'un ouvrage de synthèse, très bien documenté :

rien que des experts ne sachent déjà, pas de travail d'archives. Tout peut se

trouver en Bibliothèque ou sur Internet ; encore faut-il savoir chercher,

savoir ce que l’on veut dire et l’exprimer avec style. Les spécialistes qui

souvent se limitent à leur domaine maîtrisent rarement bien l’histoire de leur

discipline et peuvent découvrir dans d'autres champs de connaissance voire dans

le leur, de quoi leur apprendre, si ce n'est les surprendre. Quant au lecteur

non scientifique, gageons qu’il sera lui aussi surpris par la richesse de

toutes ces histoires, le récit de toutes ces aventures, il faut bien le dire en

général assez méconnues.

Février/Mars 2015

1/2 La COP 21 Paris - décembre 2015. Le seuil de 2°C : un artifice ? Bruno Voituriez

L’article 2 de la CCNUCC (Convention Cadre des Nations Unies sur le Climat) issue du sommet de Rio en 1992 précise :

«L’objectif ultime de la présente Convention et de tous instruments juridiques connexes que la Conférence des Parties pourrait adopter est de stabiliser, conformément aux dispositions pertinentes de la Convention, les concentrations de gaz à effet de serre dans l’atmosphère à un niveau qui empêche toute perturbation anthropique dangereuse du système climatique».

La COP “Conference of Parties“ réunit tous les signataires parties prenantes à la convention. C’est l’organe suprême chargé de décider les modalités d’action pour atteindre les objectifs de la convention. Elle se réunit tous les ans depuis 1995. C’est à la COP 3 en 1997 qu’a été adopté le protocole de Kyoto. Douze ans plus tard (2009) la COP 15 réunie à Copenhague n’arrivant pas à accoucher d’un accord sur la suite à donner au Protocole de Kyoto qui arrivait à échéance en 2012 et dont les résultats étaient bien maigres donne cependant une définition au «niveau qui empêche toute perturbation anthropique dangereuse du système climatique» :

2°C au-dessus de la température de l’ère préindustrielle (1880).

La COP 16 qui suivit à Cancun en 2010 confirmera ce choix et lui donnera une teinture scientifique :

«…. with a view to reducing global greenhouse gas emissions so as to hold the increase in global average temperature below 2°C above pre-industrial levels, and that Parties should take urgent action to meet this long-term goal, consistent with science and on the basis of equity».

L’histoire des 2°C.

Il n’y a pourtant pas de réelle justification scientifique à ce choix qui s’appuie sur l’histoire pour étayer dans l’urgence le choix d’un objectif fédérateur et mobilisateur susceptible d’être mis à l’actif d’une COP en difficulté à Copenhague.

L’histoire commence au 19ème siècle. Arrhenius brillant physicien publie en 1896 un article : «On the Influence of Carbonic Acid in the Air upon the Temperature of the Ground”».

Il fut ainsi le premier à étudier ce que pourrait être l’évolution de la température terrestre en fonction de la quantité de CO2 dans l’atmosphère. Pour un doublement de CO2, il trouve des accroissements de température entre 4,95°C et 6,05°C selon les latitudes.

Cette hypothèse du doublement de CO2 deviendra le fil conducteur des recherches sur l’évolution du climat et sa modélisation. Et lorsque le problème du changement climatique s’est posé dans les années 1960 la même interrogation s’est imposée tout naturellement aux modélisateurs qui arrivèrent à la conclusion qu’en cas de doublement de CO2 l’augmentation de température serait d’environ 2°C (Manabe and Wetherald 1967).

Cette association des «doubles» sera confortée par les premiers rapports du GIEC de 1990 et 1995 qui concluaient pour le scénario B1 (doublement du CO2 par rapport à l’ère industrielle) à une augmentation de température de 1,8°C. Quasiment 2°C compte tenu de l’incertitude.

C’est en s’appuyant sur cela que l’Union Européenne dans la perspective de la COP 3 de Kyoto avancera cet objectif 2°C dès 1996. Cette idée restera dans l’air et en 2009 tout naturellement la COP 15 de Copenhague la reprendra à son compte sans qu’il ait été démontré qu’il s’agissait d’un seuil à ne pas dépasser.

Les projections du GIEC

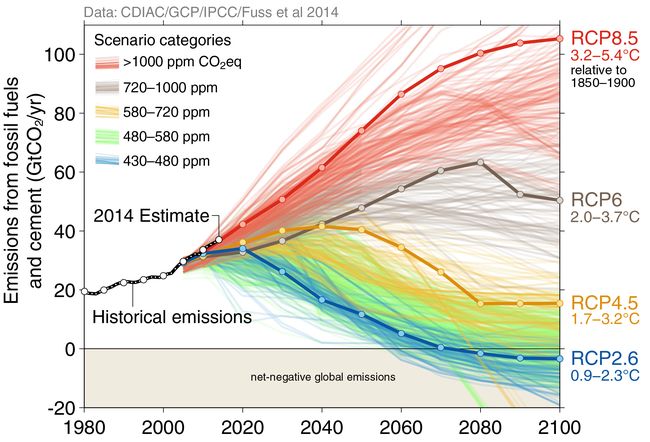

Pour faire des simulations de l’évolution climatique, le GIEC s’appuie sur des scénarios «RCP» (Representative Concentration Pathways) qui représentent des évolutions possibles de CO2.

Il y en 4 : du plus optimiste au plus pessimiste : RCP2.6, 4.5, 6.0, 8.5.

Le chiffre indique en W/m2 pour chacun des scénarios le forçage radiatif en 2100. Ces scénarios ne sont ni des prévisions, ni des recommandations politiques. Leur seule ambition est d’être un outil de travail permettant d’explorer la gamme des évolutions possibles du climat et de ses conséquences, ainsi que la possibilité de respecter les évolutions des concentrations qu’elles supposent. Pour chacun des scénarios les modèles utilisés par le GIEC font des simulations de changement de température et d’élévation du niveau de la mer à l’horizon 2081-2100

Les projections du dernier rapport du GIEC (AR5 2014) d’accroissement des températures à l’horizon 2081-2100 par rapport à la période 1986-2005 sont les suivantes :

RCP 2.6 : intervalle probable : entre 0,3° et 1,7° avec une moyenne de 1°

RCP 4.5 : intervalle probable : entre 1,1° et 2,6° avec une moyenne de 1,8°

RCP 6.0 : intervalle probable : entre 1,4° et 3,1° avec une moyenne de 2,2°

RCP 8.5 : intervalle probable : entre 2,6° et 4,8° avec une moyenne de 3,7°

Pour interpréter ces simulations dans la perspective de l’objectif 2°C maximum il faut évidemment prendre la même origine. Les valeurs données ci-dessus sont des prévisions de changement de température par rapport à la période 1986-2005 alors que les COP situent l’augmentation de température de 2°C à ne pas dépasser par rapport à l’ère préindustrielle soit cent ans plus tôt. Or pendant ces cent années la température moyenne a augmenté de 0,6°C. Il faut donc ajouter ces 0,6°C aux valeurs précédentes pour connaître les résultats des simulations du GIEC par rapport à l’ère préindustrielle.

Et l’on trouve alors les intervalles suivants pour l’intervalle 2081-2100 :

RCP 2.6 : 0,9°- 2,3°, moyenne 1,6°

RCP 4.5 : 1,7°- 3,2°, moyenne 2,4°

RCP 6.0 : 2,0°- 3,7°, moyenne 2,8°

RCP 8.5 : 3,2°- 5,4°, moyenne 4,3°

Les émissions de CO2 et les scénarios du GIEC :

En trait plein les scénarios RCP : en bleu, 2.6, en jaune 4.5, en gris 6, en rouge 8.5.

En noir les émissions de CO2 en GtCO2/an

Autant dire que seul le scénario RCP 2.6 permet d’atteindre l’objectif 2°C au-dessus de la température de la période préindustrielle.

C’est ce que dit d’ailleurs le dernier rapport du Giec :

«RCP2.6 is representative of a scenario that aims to keep global warming likely below 2°C above pre-industrial temperatures”

Ce scénario 2.6 suppose que l’on atteigne un maximum d’émission de 36GtCO2/an en 2020 suivi d’une réduction des émissions au rythme de 3% par an. Or actuellement ce «maximum» de 36GtCO2/an est déjà atteint et loin de diminuer les émissions ne cessent de croître à un rythme supérieur à 2,5% par an, ce qui place la trajectoire actuelle des émissions sur celle du scénario le plus pessimiste RCP8.5.

Pas facile d’imaginer que l’on puisse inverser la tendance pour se rapprocher de ce scénario 2.6 sans avoir recours à des solutions qui ne se limitent pas à une simple réduction progressive des émissions. Il faut avoir recours à ce que l’on appelle des émissions négatives : c'est-à-dire soustraire à l’atmosphère et séquestrer une quantité de gaz à effet de serre qui soit supérieure à la quantité de gaz émise dans l’atmosphère.

Les solutions existent : utilisation des bioénergies avec capture et stockage du CO2 dans les couches géologiques. Reste à les mettre en œuvre ce qui risque de prendre du temps.

Le GIEC, dans son dernier rapport précise : la majorité des modèles indique que les scénarios permettant d’atteindre les niveaux de forçage similaires à ceux du RCP 2.6 impliquent un recours substantiel à des émissions négatives équivalentes en 2100 à 2GtCO2/an.

Il est grand temps de s’y mettre et la COP 20 de Lima en décembre 2014

s’inquiétait déjà «Notant avec une grande inquiétude l’écart significatif

entre la somme des effets des engagements des parties en termes d’atténuation

des émissions annuelles de gaz à effet de serre d’ici 2020 et celle qui serait

consistante pour avoir une chance de contenir l’augmentation des températures

en dessous de 2°C ou 1,5°C au-dessus des niveaux préindustriels ».

Compte tenu des incertitudes, il est sans doute sage au nom du principe de

précaution de maintenir cet objectif «2°C» en ayant bien conscience qu’il ne

pourra être atteint qu’avec un taux élevé d’émissions négatives qui sont encore

à promouvoir.

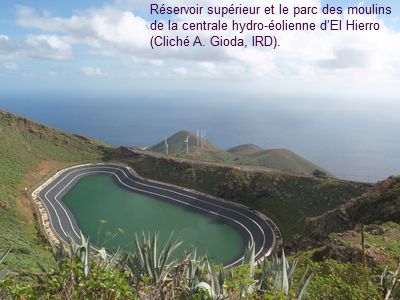

2/2 L’île d’El Hierro (Canaries) : des énergies renouvelables exemplaires - Alain Gioda

Après

de longues années de travail car les premiers crédits pour lancer les travaux

sont datés de 2006, la centrale hydro-éolienne de l'île d'El Hierro aux

Canaries qui alimente ses 8 000 résidents permanents a été inaugurée le 27 juin

2014.

Après

de longues années de travail car les premiers crédits pour lancer les travaux

sont datés de 2006, la centrale hydro-éolienne de l'île d'El Hierro aux

Canaries qui alimente ses 8 000 résidents permanents a été inaugurée le 27 juin

2014.

En quoi cette centrale hydro-éolienne est-elle remarquable ?

Elle est novatrice par les idées qui sous-tendent sa conception. La nouvelle centrale hydro-éolienne qui utilise seulement des énergies renouvelables a été conçue pour remplacer l'ancienne fonctionnant au fioul sur une île non interconnectée. Cela a été fait en accord avec les résolutions adoptées lors des grandes réunions internationales sur le climat depuis des décennies :

Sommet de la Terre Rio 1992,

Protocole de Kyoto 1997,

Rio+20 de 2012,

et lors des "Conferences Of Parties" (nous avons déjà atteint la 20ème de ces conférences), etc.

C'est l'ensemble des bonnes résolutions prises afin de limiter le changement climatique en cours, très largement provoqué par les activités humaines, que la plupart des États souverains ont signé, puis oublié de mettre en pratique par une bonne part. Il faut savoir que la non application de ces résolutions n'est pratiquement pas sanctionnée. On parle de mesures ou de directives non coercitives. En fait seuls les États de l’Union Européenne ont traduit en engagements quantitatifs juridiquement contraignants cette volonté, exprimée lors de la signature du Protocole de Kyoto, mais ils ne sont responsables que de quelque 10% des émissions des gaz à effet de serre.

La nouvelle centrale est unpuzzle original bien qu'il faille savoir que les techniques adoptées sur El Hierro sont, prises une à une, éprouvées, précisément afin d'obtenir une bonne fiabilité de l'ensemble.

Citons articulés ou interconnectés mais seulement à l'échelle de l'île : un parc éolien qui permet également le pompage de l'eau de mer jusqu'à une usine de dessalement, puis en amont à la cote 700 mètres, à un réservoir d'un demi-million de mètres cubes ; ce dernier alimente, par une chute d'eau de 650 mètres, une usine hydro-électrique fonctionnant comme une batterie en cas de panne de vent ou, au contraire, en cas d'ouragan.L’eau est ensuite stockée dans un réservoir inférieur d'où elle est reprise vers le réservoir supérieur par des pompes alimentées par les éoliennes, constituant ainsi un circuit fermé. Cette «batterie hydraulique» assure deux jours d’autonomie sur une île battue par les alizés et où l’intermittence du vent est rare. Les déplacements ne seront pas abandonnés à terme aux énergies fossiles grâce à de l'électricité propre à disposition pour les véhicules légers et à la fabrication de biodiesel d'origine locale pour les poids lourds, les véhicules tout-terrain, ceux agricoles, etc. Le volet économie d’énergie est pris en compte avec l'éclairage public aux diodes électroluminescentes qui s'étend partout tandis que les habitants disposent en maints endroits y compris ruraux de la wifi gratuite.

L'actualité est marquée par la crise économique espagnole depuis 2008. Localement elle se caractérise par une consommation basse de l'ordre de 6 MW en pointe alors que les centrales sont dimensionnées pour produire jusque à 11 MW tant pour l'énergie éolienne, hydraulique et fossile, sachant que la centrale au fioul n'a pas été démantelée et tourne en appui ou en relais.

Le mix ou bouquet énergétique est entre les mains du gestionnaire, soit l'administration insulaire représentée par Gorona del Viento, qui est une Société anonyme d’Économie Mixte, afin de faire un lien entre les législations espagnole (ici dans le cadre du Décret Royal Législatif n° 1/2010, du 2 juillet) et française. L'exploitation, suite à un appel d'offres et donc un concours ouvert, pourrait à terme se faire par l'entreprise privée Endesa, contrôlée par l'italienne Enel. Tout n'est pas parfait, comme dans toute entreprise humaine. Ainsi seule Endesa qui gère déjà la station au fioul avait présenté une offre cohérente, alors que cette entreprise est déjà associée à la gestion de Gorona del Viento même si elle est minoritaire ( 30% ).

Pourquoi cette forme de transition énergétique marche-t-elle?

Elle marche parce que ses habitants se sont approprié l'île : "notre île" disent-il souvent s'agissant de leur bien commun.

Ils se définissent comme différents des autres habitants des Canaries et il faut ajouter que c’est la dernière île de l’archipel qui peut se voir ainsi tels un ermitage ou un cul-de-sac. Cet aspect fut très important, pour l’appropriation collective, la conservation et la promotion du caractère resté agricole d'El Hierro. Ainsi, pour son développement, la communauté agropastorale de l'île n'a pas été classée dans un Parc national ce qui aurait bloqué sans doute toute la vie économique. El Hierro est devenue démocratiquement, par le choix de ses élus, et, en sa totalité, une Réserve de la biosphère de l'Unesco en 2000. Elle a choisi ce parrainage international pour échapper au flux touristique des autres îles des Canaries (11 millions de visiteurs par an et le gouvernement régional vise les prochaines années les 14 millions) ou à l'extension des terrains militaires qui la menaçait à la fin du XXème siècle (http://vertigo.revues.org/15595).

Au niveau collectif afin de consolider les avancées locales de la transition écologique et énergétique, le suivi quasi en direct et en "open access" (pour adopter un anglicisme) des trois centrales hydroélectriques, est très important, suivi qui est assuré par le réseau électrique espagnol. (https://demanda.ree.es....html#)

En effet, c'est l'action collective qui permet ces comportements vertueux (http://www.pourlascience.fr/...php). Ainsi, dans son ensemble, l’île a obtenu trois reconnaissances de la part de l’UNESCO : Réserve de la biosphère en 2000, Géoparc, et leader du programme Renforus (Energies renouvelables) en 2014.

Ce choix des énergies renouvelables est difficile alors que le prix des

produits pétroliers est en forte baisse. Toutefois, il est renforcé par

l'actualité : au niveau de la politique régionale, le président du gouvernement

autonome des Canaries, inquiet pour le futur touristique de l'archipel, défend

vigoureusement les énergies renouvelables. Pourquoi ? Parce que les forages y

compris en eaux profondes dans l'Atlantique, au large de l'île de Fuerteventura

face au Maroc, ont été autorisés par le gouvernement central de Madrid et que

les premiers étaient déjà en cours fin 2014. Toutefois l’aventure s’est achevée

dès janvier 2015 avec la déclaration de l’absence de pétrole en quantité

suffisante pour son exploitation.

(http://www.elmundo.es/.....html)

L’exemple de l’île d’El Hierro ou plus exactement celui de sa gouvernance

ont inspiré dernièrement les sénateurs français qui ont voté le 20 février 2015

l’amendement 777 à la «loi de la transition énergétique pour la croissance

verte», soutenus par la ministre de l’Écologie, du développement durable et de

l’énergie qui avait déjà primé la communauté insulaire des Canaries le 12

février par le Trophée des énergies renouvelables à l’UNESCO.

La ministre n’avait-elle pas déclaré dès le 9 janvier dernier à l’AFP :

«Tous les territoires insulaires [français] doivent avoir le droit de

monter des projets d’autonomie énergétique». Cet amendement ouvre la

porte, pour les petites îles bretonnes qui font déjà partie de la Réserve de la

biosphère de la Mer d’Iroise soit, Sein, Molène et Ouessant, à une gouvernance

locale des énergies propres, produites sur chaque île, alors que

l’approvisionnement actuellement se fait par du fioul livré par bateau.

(http://www.idsenergies....senat)

Voir aussi la vidéo : Une île 100% autonome grâce aux énergies renouvelables ! - FUTUREMAG- ARTE

Janvier 2015

1/1 L’année climatique 2014 - L’année la plus chaude de l’époque moderne Bruno Voituriez

Sans doute est-il nécessaire de rappeler, comme nous le fîmes l’année dernière pour le climat 2013 (news de mars 2014) qu’une année ne fait pas le climat et que sa variabilité interannuelle peut masquer son évolution à long terme. Les chiffres publiés, et utilisés ici, pour l’année 2014 ne sont que des balises sur un chemin cahoteux et accidenté comme l’indication de l’altimètre de l’alpiniste qui cherchant à atteindre un sommet est parfois obligé de descendre...

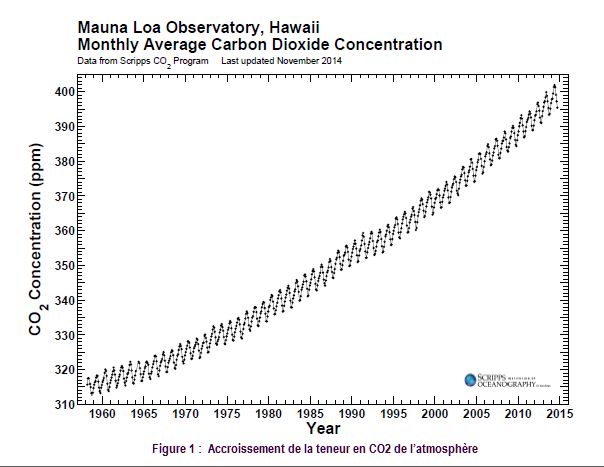

1 - Le gaz carbonique dans l’atmosphère.

La teneur de l’atmosphère en gaz carbonique, principal gaz à effet de serre produit par les activités humaines, continue inexorablement son ascension rythmée par les variations saisonnières mais insensibles aux évolutions climatiques que pourtant il provoque. En décembre 2014 sa concentration était de 398,78 ppm contre 396,81 ppm en décembre 2013. Bon an mal an, l’atmosphère s’enrichit de 2 ppm/an de CO2 (figure 1).

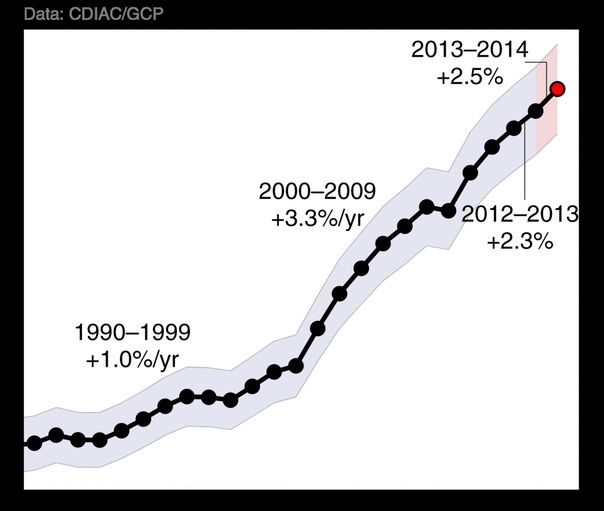

C’est le résultat de l’accroissement constant des émissions anthropiques de CO2 au rythme actuellement de 2,5% par an (figure 2).

Figure 2 : Accroissement des émissions de CO2 dans l’atmosphère

Ce qui nous place dans le plus pessimiste des scénarios (RCP 8.5) du Giec. Les émissions ont été en 2014 de 10 GtC soit la valeur maximale du scénario le plus optimiste (RCP 2.5) qu’il eut fallu atteindre entre 2020 et 2025 avant de les faire diminuer au rythme de 3% par an ….

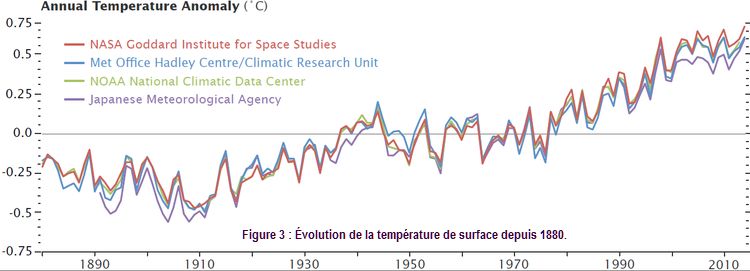

2 - La température moyenne.

Il y a unanimité : 2014 fut l’année la plus chaude depuis 1880

La température moyenne fut de 0,8°C supérieure à ce qu’elle était en 1880 date à partir de laquelle on a les moyens d’évaluer cette température moyenne ou, compte tenu de l’accélération, de 0,68°C supérieure à la moyenne 1951-1980.

Les 9 années les plus chaudes sont intervenues depuis l’an 2000. La dixième en 1998 sera l’année la plus chaude jusqu’en 2005 ; elle reste au quatrième rang des années les plus chaudes. Elle fit couler beaucoup d’encre car elle suggéra à certains, qu’après elle il y avait refroidissement puis stagnation (le fameux hiatus) remettant en cause la réalité du changement climatique occultant le fait que la variabilité climatique ment du réchauffement climatique.

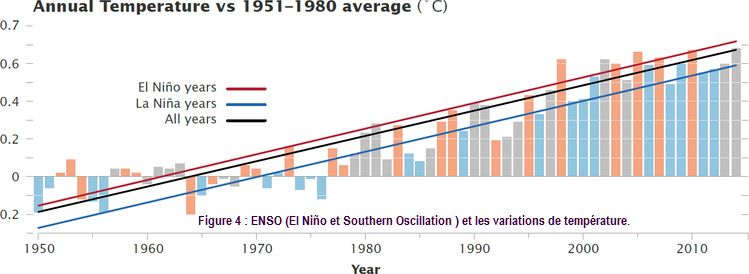

Un exemple de cette variabilité pluriannuelle est le phénomène El Niño qui induit une augmentation temporaire importante de la température globale et son inverse la Niña qui joue la température à la baisse. La figure 4 illustre ce phénomène : l’année 1998 et l’année 2005 qui la détrôna sont des années à El Niño très marqué et correspondent à des pics de température.

À l’inverse l’épisode Niña de 2011-2012 se traduit par une baisse sensible de la température pouvant accréditer l’idée d’un «hiatus» remettant en cause la réalité du réchauffement.

On peut dire avec James

Hansen que le record de 2014 montre qu’il n’y a pas de «hiatus»

puisque, bien qu’annoncé régulièrement au long de l’année 2014 , El Niño comme

l’Arlésienne ne s’est pas manifesté et donc que l’année 2014, pour battre le

record de température, n’a pas eu besoin de son coup de pouce.

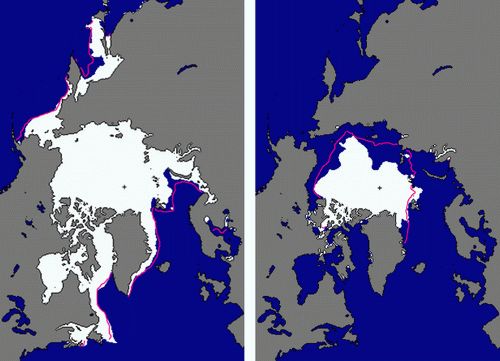

3 - La banquise

En Arctique l’extension maximale eut lieu le 21 mars 2014 : 14,91 millions de km2 soit 5% en dessous de la moyenne de la période 1981-2010 (figure 5).

jjjjj

jjjjj

Figure 5: Extension de la banquise arctique en 2014. Maximum en Mars ;

minimum en septembre.

Les lignes magenta indiquent les moyennes d’extension sur la période

1981-2010. Arctic Report Card

2014

C’est la cinquième plus faible extension sur la période de l’observation satellitaire (1978- 2014). Le minimum eut lieu en 2006. Cela représente une diminution de 2,6% par décennie depuis 1981.

Le minimum d’extension de la banquise dans l’Arctique fut

atteint le 17 septembre 2014 : 5,02 millions de km2 (voir figure 4), c’est 80 000 Km2 de moins qu’en

2013, mais reste loin du minimum absolu de 2012 (3,4 millions de

Km2). C’est néanmoins la sixième extension la plus faible depuis

1978 et représente une décroissance de 13,3% par décennie.

On l’a dit dans une news de

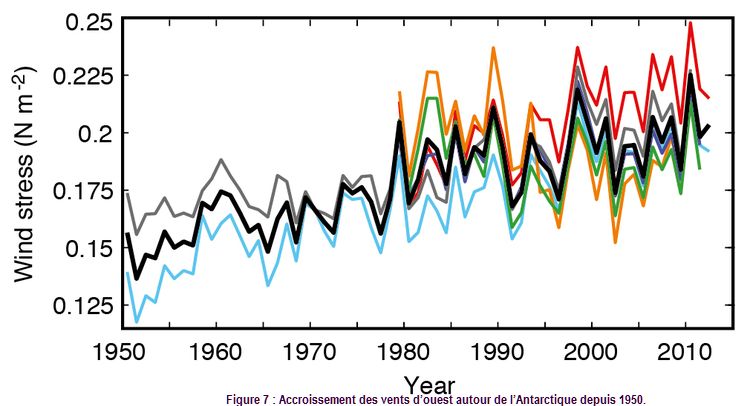

décembre 2014 la banquise antarctique tient à se démarquer de sa consoeur

boréale en affichant une légère augmentation de son extension maximale. Pour la

première fois, à son extension maximum le 22 septembre 2014 elle a dépassé la

surface de 20 millions de km2 ce qui représente une augmentation de

1% par décennie depuis 1978. Une des explications comme il est dit dans la news

de décembre est l’accroissement du vent d’ouest autour de l’Antarctique

illustré par la figure 7 tirée du 5ème rapport du Giec.

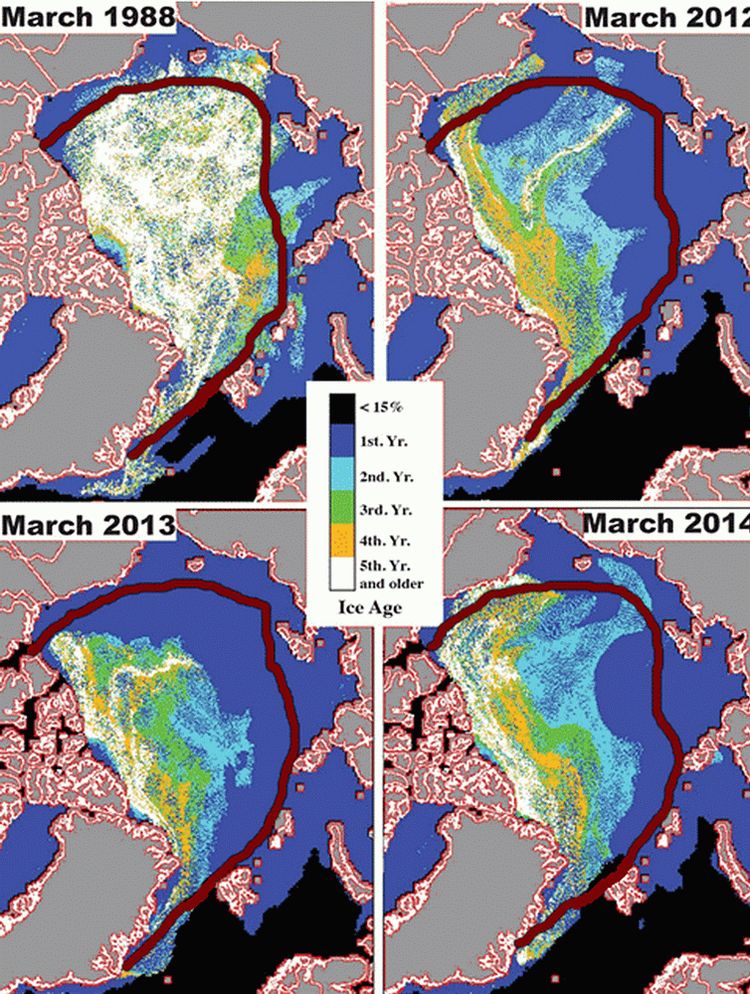

Dans la news de mars 2014 nous rappelions que :

«Il existe deux propriétés de la banquise qui atténue cette variabilité interannuelle de l’extension de la banquise et intègre le plus long terme : l’âge de la glace d’une part et son épaisseur d’autre part. La glace dite de première année est celle qui ne survit pas à la saison de fonte en été. C’est aussi la moins épaisse et, par définition, elle ne contribue pas au maintien du stock de glace de l’Arctique qui, pour se maintenir, doit être alimenté par des glaces qui survivent au dégel et passent le cap des années.».

L’extension des glaces avec leur âge est représentée sur la figure 8.

Figure 8 :

Extension des glaces avec leur âge en mars (extension maximum) dans

l’Arctique.

La ligne rouge foncée indique l'extension moyenne de la glace pluriannuelle

sur la période 1981-2010.

Elle s’est accrue significativement entre 2013 et 2014. Mais elle est très éloignée de ce qu’elle était en 1988. La proportion de glace de première année a diminué passant de 78% du pack en 2013 à 69% du pack en 2014. À l’inverse les glaces de deuxième année ont augmenté de 8 à 14% du pack. Ce qui signifie qu’une part importante de la glace de première année a résisté à la fusion de l’été 2013. La part des plus vieilles glaces (4 ans et plus) a également connu un sursaut passant de 7 à 10 % du pack. Cela reste dans la norme de la variabilité interannuelle : en 1988 les glaces de 4 ans et plus représentaient 26% du pack (près de trois fois plus qu’en 2014). L’épaisseur moyenne de la banquise dans la partie centrale de l’Arctique mesurée grâce au satellite européen Cryosat s’est aussi accrue en 2014 : 2,35 mètres contre 1,97 en 2012 et 2013.

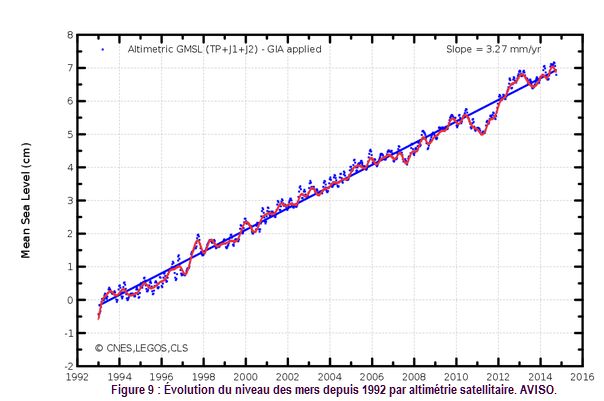

4 - Le niveau de la mer

Rien à signaler : on l’a dit plus haut les années 2013-2014 furent des années neutres vis-à-vis d’ENSO (ni Niño ni Niña perturbateurs) aussi le niveau de la mer a-t-il évité de provoquer des polémiques et évolué en se situant sagement sur la pente moyenne : 3,27 mm/an.

Pour finir, la température de surface moyenne de l’océan qui est aussi à son maximum : 0,57°C au dessus de la moyenne du 20ème siècle (16,1°C) soit 0,05°C au-dessus des records précédents de 1998 et 2003 (http://www.ncdc.noaa.gov/sotc/global/), pourtant deux années El Niño fig(4).

En conclusion : l’année 2014 s’est située dans la norme du changement climatique en cours, de l’irréprochable accroissement des teneurs de l’atmosphère en CO2 à l’exemplarité de l’élévation du niveau de la mer en passant par le retour de la température qui revient à sa bonne valeur (la plus élevée), quelques fantaisies glaciaires et l’océan qui méprise ces échelles de temps.