Les News

Mois de Novembre 2010

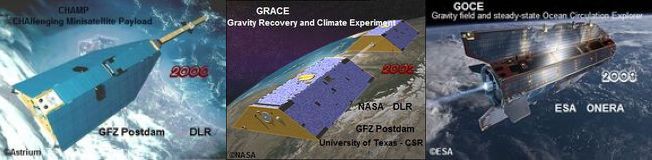

1/1 Pourquoi la connaissance précise du champ de gravité terrestre est-elle si importante pour le climat ? Quels sont les moyens de mesures actuels ? Résultats obtenus depuis 10 ans avec les satellites CHAMP, GRACE, GOCE.

La connaissance du champ de gravité de la Terre et son amélioration constante a été un objectif majeur et permanent depuis le début de l’ère spatiale.

Dans une première phase jusqu’aux environs des années 2000, le satellite était un simple détecteur des forces en présence dans le milieu spatial, servant à l’identification des forces gravitationnelles et donc ainsi à la détermination du champ de gravité terrestre. L’objectif était en premier lieu d’améliorer la trajectographie des satellites artificiels pour les situer dans l’espace de manière de plus en plus précise.

Au début, la précision était de niveau kilométrique, puis on est passé d’étape en étape au niveau hectométrique, décamétrique, métrique... et aujourd’hui centimétrique !

Indissociable des premiers objectifs, était aussi la détermination des repères terrestres de référence, dont la précision a été en s’améliorant, tant dans leur étendue spatiale (pour devenir mondiale et couvrant toute la Terre) que dans leur précision pour atteindre aujourd’hui le niveau millimétrique.

Ces progrès ont ouvert progressivement des applications nouvelles dans les géosciences. Compte tenu des précisions atteintes, il a fallu prendre en compte la partie temporellement variable des grandeurs et des phénomènes observés : position des stations d’observations en liaison avec les mouvements induits par la tectonique des plaques, paramètres de la rotation terrestre, rebond postglaciaire, marées océaniques et terrestres, effets de charge (d'origine hydrologique ou atmosphérique) sur la position des stations etc.…

Pour bien apprécier la situation actuelle, il faut d’abord souligner plusieurs progrès technologiques majeurs réalisés au siècle dernier ; ils concernent les systèmes de positionnements GPS et DORIS, l'altimétrie spatiale avec le lancement de Seasat en 1978, puis celui de TOPEX-Poséïdon en 1992, le succès de l’accéléromètre spatial mis au point en France depuis 1975 par l’ONERA et de la coopération internationale dans le cadre de l’Association Internationale de Géodésie pour les systèmes de poursuite. Ces progrès sont à la base du développement devenu possible, à partir de l’an 2000, d’une nouvelle génération de satellites spécifiquement dédiés à la détermination du champ de gravité de la Terre, avec une résolution spatiale et temporelle encore jamais atteintes au siècle dernier.On a ainsi lancé trois satellites depuis l’an 2000 :

CHAMP satellite développé par le GFZ en Allemagne lancé le 15 juillet 2000,

GRACE satellites américano-allemands lancées le 17 mars 2002,

GOCE satellite européen lancé le 17 mars 2009.

La décennie 2000-2010 s’appelle pour cette raison la décennie du champ de gravité.

Le satellite CHAMP est retombé dans l’atmosphère le 19 septembre 2010.

S’appuyant sur les technologies de CHAMP, on a, en parallèle, développé une mission GRACE en utilisant deux satellites de ce type se suivant dans le même plan orbital avec un écart d'environ 200 km ; une liaison de type micro-onde permet de déterminer la distance entre les deux satellites et ses variations avec une précision micrométrique.

Avec GRACE, on a pu alors obtenir le champ de gravité avec une résolution de 200 à 300 km calculable avec des données récoltées sur un seul mois, voire moins. Ceci a ouvert un vaste domaine de recherches géophysiques reliées notamment aux transferts de masse entre les composantes du système Terre : cryosphère, hydrosphère, atmosphère, océans, et cela d’une région géographique à un autre. Ce sont ces transferts qui modifient la valeur du champ.

À l’heure ou l’on observe un processus de déglaciation des calottes polaires et des zones glacées des hautes montagnes, ces observations quantitatives sont devenues cruciales sur le plan du changement climatique et il est impensable de ne pas suivre ces évolutions temporelles. Il en est de même des transferts à caractère saisonnier, ou interannuel dans l’hydrosphère et dans les grands bassins fluviaux comme l’Amazone, le Congo, l’Indus ou le Gange.

On voit aussi se développer des zones de sécheresse ou au contraire soumises à des graves inondations. Tout cela est préoccupant sur le plan sociétal. Leur suivi est indispensable.

Un article intéressant publié en 2010 par Anny Cazenave et Juili Chen fait la synthèse de tous ces travaux.

L’importance de GRACE, devenu désormais un moyen incontournable du suivi de l’évolution de l’environnement terrestre, a justifié la décision de poursuivre jusqu’au bout l'exploitation de cette mission, décision prise par les Allemands et les Américains en juin 2010.On peut également espérer qu’une mission de même nature va suivre et être décidée dans les meilleurs délais pour éviter une interruption du suivi de ces grandeurs liées aux variations du champ de gravité de la Terre.

En parallèle, côté européen, un nouveau satellite GOCE a été lancé par l’ESA en 2009. Ce satellite utilise un nouvel instrument qu’on appelle un gradiomètre et qui permet de déterminer le champ de gravité avec une résolution spatiale encore meilleure que celle de GRACE, de l’ordre de 100 km.

Les premiers modèles de champ de gravité établis en exploitant aussi les mesures de GRACE ont été publiés en septembre 2010.On dispose ainsi d'une résolution dans l'espace et dans le temps qui permettra d'améliorer encore notre connaissance des transferts de masse, avec les applications que l’on vient d’indiquer en glaciologie et en hydrologie donnant accès à des informations cruciales pour la climatologie.

D’un point de vue français, il faut souligner le rôle majeur de l’accéléromètrie spatiale développée à l’ONERA en France dans ces trois missions.Les responsables de ces développements ont

d'ailleurs reçu en novembre 2010 un grand prix décerné par l'Académie de l'air

et de l'espace, Pierre Touboul (ONERA) et Bernard Foulon (ONERA) ;

Christoph Reigber (GFZ), principal investigateur sur CHAMP et GRACE, partage

aussi ce grand prix en raison des ses responsabilités et d’une très ancienne

collaboration franco-allemande infiniment fructueuse dans tous ces domaines

depuis 40 ans.

Pour en savoir plus, voir FAQ

Mois d'Octobre 2010

1/1 Pearn Niiler, océanographe américain, nous a quittés le 15 octobre 2010

Nombre

de scientifiques océanographes connaissent bien Pearn Niiler sans uu jamais

l'avoir vu, grâce à sa contribution pionnière à la compréhension de la

circulation océanique mondiale. Ceux qui ont eu la chance de le fréquenter ont

aussi apprécié ses qualités humaines, enthousiasme, ténacité, générosité...

Nombre

de scientifiques océanographes connaissent bien Pearn Niiler sans uu jamais

l'avoir vu, grâce à sa contribution pionnière à la compréhension de la

circulation océanique mondiale. Ceux qui ont eu la chance de le fréquenter ont

aussi apprécié ses qualités humaines, enthousiasme, ténacité, générosité...

Jacques Merle qui l'a bien connu lorsqu'il était à la Nova University en Floride, écrit dans son livre "Océan et Climat" :

" La communauté scientifique doit beaucoup à Pearn Niiler de la Scripps, qui, en physicien expérimental rigoureux, s'attacha à étudier la capacité des bouées dérivantes à mesurer le courant océanique. Il conçut des bouée droguées ( c'est à dire munies d'une ancre flottante ou drogue) immergées dans la couche homogène superficielle de l'océan et soumise au courant. Il testa ces prototypes de bouées par de nombreuses expériences pour déterminer l'ancre flottante idéale et connaître la précision de la mesure du courant déduite de la dérive de la bouée".

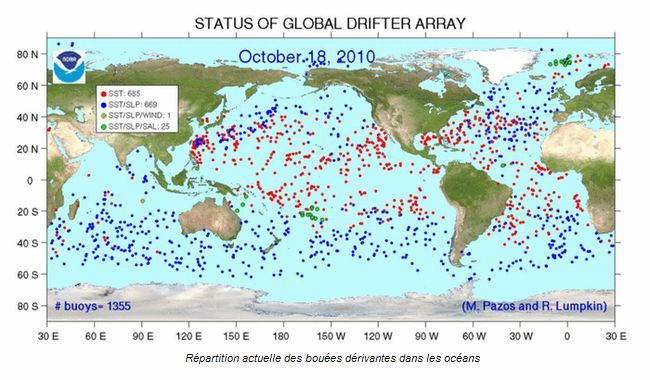

Pearn Niiler a compris très tôt le rôle que joue la circulation océanique dans le climat et l'intérêt d'avoir un réseau mondial d'observation des courants marins. Avant les années 80, il existait un réseau de bouées dérivantes soumises au vent, mais qui ne permettait pas de distinguer dans leur dérive la composante due au vent de la composante représentant le courant. L'idée de Pearn a été de concevoir des bouées dérivantes de surface avec des instruments de mesure capable d'éliminer les effets du vent et des vagues, soient très fiable et produites au moindre coût. Il a aussi compris que pour étudier la circulation océanique et sa relation avec le climat, il fallait avoir une vue mondiale de l'océan. Ainsi est né en 1982, le "Global Dritfter Program" (réseau mondial de bouées dérivantes) en collaboration avec la NOAA, qui comprend aujourd'hui 1355 flotteurs.

Ce réseau de bouées dérivantes en surface semble bien avoir franchi l'étape décisive de la pérennisation et est devenu un élément essentiel du système mondial d'observation des océans (GOOS).

Il a été le précurseur des autres éléments du système mondial comme :

le réseau de flotteurs de sub surface Argo,

le réseau de bouées ancrées PIRATA dans l'Atlantique, TAO TRITON dans le Pacifique, et son homologue dans l'Océan Indien

la filière de satellites altimétriques de haute précision,

les satellites de mesure des petites variations locales, saisonnières ou interannuelle du champ de gravité

Un rêve est en train de devenir réalité : une Veille Mondiale Océan et Climat qui permette en permanence de décrire et de prévoir l’océan en temps réel, grâce à un réseau global d'observation des océans, à l'aide de mesures in situ et depuis l'espace, analogue à celui utilisé par les météorologues depuis plusieurs décennies.

Pearn Niiler est né en 1937 à Tartu en Estonie. Il est venu aux Etats Unis à l'âge de 11 ans.

Après un parcours universitaire, il rejoint

l'Université de Nova en 1966 où il étudie le courant de Floride et le Gulf

Stream. Il enseigne à l'Oregon State University, avant de rejoindre la Scripps Institution of Oceanography.

Pearn avait d'autres centres d'intérêt que la science. Il se passionnait pour l'architecture et a conçu de nombreux bâtiments. C'était aussi un artiste peintre, un grand chef cuisinier et un amateur de vin et de voyages.

En savoir plus :

http://oceanmotion.org/html/research/niiler.htm

Mois de Septembre 2010

1/1 Exploration de la biodiversité des karsts de Papouasie-Occidentale

Du 2

octobre au 19 novembre, une quarantaine de chercheurs français et indonésiens

vont étudier l’une des régions du monde les moins connues d’un point de vue

biologique, archéologique et géographique : le massif de Lengguru, en

Papouasie-Occidentale. Cette région est caractérisée d’une part, par des

reliefs karstiques accidentés et isolés par de profondes vallées et, d’autre

part, par des écosystèmes forestiers encore intacts et extrêmement développés,

typiques des zones tropicales humides.

Du 2

octobre au 19 novembre, une quarantaine de chercheurs français et indonésiens

vont étudier l’une des régions du monde les moins connues d’un point de vue

biologique, archéologique et géographique : le massif de Lengguru, en

Papouasie-Occidentale. Cette région est caractérisée d’une part, par des

reliefs karstiques accidentés et isolés par de profondes vallées et, d’autre

part, par des écosystèmes forestiers encore intacts et extrêmement développés,

typiques des zones tropicales humides.

Bernard Pouyaud, membre du Club des Argonautes participera à

cette campagne scientifique organisée par l’IRD,

l’association Caracol

et le bureau d’étude CENOTE.

Une telle aventure scientifique sera aussi l’occasion d’informer et de

communiquer vers le grand public notamment à travers un film documentaire et la

mise en place d’un site web ainsi qu'un blog destiné aussi aux élèves et

professeurs des écoles, collèges et lycées.

Pour en savoir plus :

Site de l'expédition avec son journal de bord

Mois d'Août 2010

1/1 Que penser de l’article : "Déclin du phytoplancton global depuis un siècle" ? Guy Jacques

La presse a

donné une certaine publicité à l’article de trois chercheurs de l’université

Dalhousie d’Halifax (Canada), Global phytoplankton decline over the past

century, paru dans la revue Nature, le 29 juillet 2010.

La presse a

donné une certaine publicité à l’article de trois chercheurs de l’université

Dalhousie d’Halifax (Canada), Global phytoplankton decline over the past

century, paru dans la revue Nature, le 29 juillet 2010.

Quelle analyse peut-on en faire ?

Si la renommée de cette université et des trois océanographes impliqués, Daniel Boyce, Marlon Lewis et Boris Worm ne peut être mise en cause, on peut se demander si la « cote » que représente une publication dans Nature ou dans Science ne les a pas entraîné vers quelques excès. Je suis convaincu que la nécessité d’un titre attractif pour ce type de revue mène de plus en plus de chercheurs à magnifier les observations et à exagérer les conclusions.

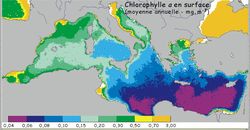

Il me semble que la seule base valable pour une comparaison à

l’échelle océanique (les auteurs compartimentent l’océan mondial en dix zones

biogéographiques) est la compilation des données satellitaires dont on dispose

pour la période 1979-1986 et de 1997 à nos jours. Encore doit-on rappeler que

le premier capteur, CZCS, en service entre 1979 et

1986 n’avait pas été prévu pour une collecte globale. On pourrait bien sur

discuter de la représentativité de la chlorophyllea comme marqueur de

biomasse, ergoter sur les difficultés de comparaison d’un capteur à l’autre

surtout quand ils n’ont pas été utilisés simultanément, etc.

Mais la critique majeure est de faire porter cette étude sur cent ans alors que

les mesures pionnières de la teneur en chlorophylle des eaux par méthode

spectrophotométrique sont dues à Kreps & Verjbinskaya en 1930 puis à Harvey

en 1934. Encore doit-on indiquer, et c’est capital, que jusque vers les années

1960, ces mesures se limitèrent à quelques zones côtières et sont probablement

un peu surestimées, pour des raisons techniques. Historique, la carte de

production primaire marine établie par Steemann-Nielsen lors du tour du monde

de la Galathea en 1951 en se basant sur la méthode au carbone 14,

souffre du même mal : la rareté des points de mesure alors que le phytoplancton

est un écosystème à la dynamique rapide. Pour compenser ce manque, les auteurs

se fondent sur une relation empirique entre richesse en phytoplancton et

« transparence » de la couche superficielle par la méthode du disque de Secchi,

ce qui est à la limite du sérieux, même s’il n’y avait guère le choix.

Pour ces raisons, les auteurs de cet article auraient du se limiter à la

période couverte par des données satellitaires de chlorophylle a. Mais dans ce cas, il n’est pas certain que le

léger déclin et la période plus limitée d’observation eussent conduit à un

titre aussi accrocheur.

Ne nous trompons cependant pas. Point n’est besoin d’être un expert international en écologie marine pour être convaincu que le réchauffement de la couche superficielle entraînant une diminution des apports d’eau profondes à la couche où se déroule la photosynthèse conduira globalement à un abaissement de la production primaire même si certains évoquent un renforcement des vents générateurs des remontées côtières.

De là à dire que les données du dernier siècle le prouvent, il y a un pas que ces auteurs ont peut-être rapidement franchi.

Mois de Juillet 2010

1/1 Lancement du satellite Picard

Le satellite Picard (125 kg) a été lancé

avec succès le 15 juin 2010 à 16h42, par une fusée Dniepr depuis la base de

Dombarovsky, près de la ville de Yasny en Russie.

Le satellite Picard (125 kg) a été lancé

avec succès le 15 juin 2010 à 16h42, par une fusée Dniepr depuis la base de

Dombarovsky, près de la ville de Yasny en Russie.

Ce satellite a été conçu et réalisé par le CNES et le laboratoire associé LATMOS/IPSL ; il faut yajouter le rôle d’instituts européens en Belgique et en et en Suisse.

Le satellite a été placé en orbite héliosynchrone à une altitude de 725 km et donc avec une inclinaison du plan de l’orbite sur l’équateur terrestre de l’ordre de 98 degrés, permettant ainsi que l’angle entre le plan de l’orbite et le soleil demeure constant.

Ce satellite est dédié à :

la métrologie solaire,

l’irradiance solaire totale et spectrale, (l'irradiance totale, caractéristique de la luminosité du soleil, est définie comme l'énergie rayonnante, émise dans toutes les longueurs d'onde, arrivant chaque seconde sur une surface de 1 m2 à l'extérieur de l'atmosphère terrestre, tandis que l'irradiance spectrale correspond à une partie de cette grandeur, mesurée sur telle ou telle portion du spectre électro-magnétique),

le diamètre du Soleil, sa forme, ses corrélations avec les variations de l’activité solaire,

la rotation du Soleil,

les relations Soleil-Terre et leur impact sur l’environnement terrestre et le climat,

la structure interne de notre astre, grâce à des mesures d’héliosismologie.

Pour en savoir plus, voir le site CNES : le satellite et les instruments.

La séparation a eu lieu comme prévu. Le premier contact avec le satellite à été obtenu à partir de la station de Kiruna en Suède, peu après 18h15, à la position et au moment précis prévus. Tout est nominal, et l’orbite est parfaite. Les instruments ontétémis sous tension fin juin. La première lumière est prévue pour fin juillet. Le satellite devrait être totalement opérationnel d’ici la fin de l’année 2010.

Le nom de la mission a été choisi en hommage à l’abbé Jean Picard (1620-1682), académicien qui fit les premières mesures du diamètre solaire durant le minimum d’activité solaire entre 1645-1710, aujourd’hui appelé minimum de Maunder, en hommage à cet astronome de l’observatoire de Greenwich (1851-1928) qui le mit en valeur.

Le satellite Picard est le troisième de la filière Myriade; il fait suite au lancement des satellites Demeter et Parasol.

Il a été lancé avec les deux satellites Mango et Tango de la

mission Suèdoise Prisma, pour préparer les instruments

spatiaux de demain, et étendre aux microsats la maîtrise du vol en formation,

démontrée par le Cnes en déc. 2001, (Jason-1).

Les mesures de Picard seront exploitées en synergie avec les autres données

disponibles, en provenance soit d’autres missions spatiales, soit des mesures,

variées et nombreuses, faites depuis le sol.

Ces études porteront en particulier sur:

les travaux théoriques en cours, et les importants efforts de modélisation du fonctionnement du soleil, actuellement développés en France et dans le monde,

la connaissance des relations Soleil-Terre,

le climat

A titre d’exemple, pour mieux comprendre les relations entre climat et activité solaire, les mesures de Picard seront utilisées par les équipes de l'IPSL pour simuler, (dans leur modèle "LMDZ-REPROBUS"),l’effet des variations de l'éclairement ultraviolet solaire sur la couche d'ozone et le couplage entre la stratosphère et la troposphère.

Ce programme ambitieux s'inscrit dans la continuité de

mesures entamées au 17ème siècle. Un archivage soigné des données et un accès

facilité sont prévus.

Au cours des siècles, l’étude et l’observation du Soleil ont toujours été,

pour des raisons assez évidentes, un objectif majeur avec des observations

faites de façon pérenne et continue.

Un peu d'histoire...

Le Soleil est en effet l’étoile qui nous chauffe, nous éclaire, et a permis le développement de la vie terrestre. Toutes les variations de ses émissions, ondes ou particules, peuvent avoir des conséquences importantes pour l’homme, la vie en société, le fonctionnement de nos systèmes de communication, de transport, et beaucoup d’autres aspects.

Certes, depuis la formation du Soleil qui a débuté il y a environ 4,55 milliards d’années, beaucoup de propriétés physiques ont changé. L’irradiance solaire était à titre d’exemple, et d’après les modèles existants, plus faible d’environ 30% par rapport à ce qu’elle est aujourd’hui.

Cependant, de nos jours, à l’échelle des temps humains, les variations mesurées de cette irradiance totale sont faibles, de l’ordre de 0,1%. (de sorte que l'irradiance totale s'appelle aussi la constante solaire). Toutefois, des variations beaucoup plus importantes des émissions électromagnétiques sont observées dans le domaine des courtes longueurs d’onde, (UV, EUV, X) et dans le domaine radio. Comme l’énergie émise dans ces longueurs d’onde est petite par rapport à ce qui est émis dans le domaine visible, ces variations apparaissent peu susceptibles de modifier sensiblement un aspect de grande actualité, le climat, sauf à mettre en évidence des effets amplificateurs inconnus, ce qui fait l’objet de recherches actuellement.

Entre 1645 et 1710, le très long minimum d’activité solaire,

dit de Maunder, s'est traduit par la rigueur des hivers en Europe du Nord, un

phénomène qui a toujours questionné les scientifiques, d’autant qu’à cette

époque il n’y avait ni pollution ni gaz à effet de serre d’origine anthropique,

susceptibles de modifier le climat (mais ceci peut être un avantage pour des

études modernes sur le sujet). Même si ce qui s'est passé au 17 éme siècle

reste exceptionnel, la longueur du dernier minimum solaire, (qui vient de

s’achever), intrigue aussi les chercheurs. L’étude des effets de l’activité

solaire sur notre environnement continue ainsi d’être très importante, et

bénéficie d'immenses progrès technologiques sur la précision, sur l’exactitude,

et sur l’échantillonnage des données.

Il y a une activité solaire avec un cycle principal d’environ 11 ans, de durée

variable. En hommage à un astronome amateur, pharmacien de profession, Heinrich

Schwabe (1789-1875) qui le découvrit, on l'a appelé cycle de Schwabe.

L’activité solaire est caractérisée par l’apparition de taches et de groupe de

taches à la surface du Soleil, ainsi que par l’éjection de particules (protons,

ions, électrons) à grande vitesse, qui peuvent générer des orages

géomagnétiques au niveau terrestre, avec souvent le déclenchement de belles

aurores dans le ciel polaire. Lorsque l’on prend en compte la polarité du champ

magnétique, c'est en fait un cycle solaire de 22 ans qui est observé. Ces

taches solaires, découvertes par Galilée, sont observées depuis le 17 ème

siècle, mais les cycles ne sont suivis de manière fiable que depuis le 18 ème

siècle, Celui qui a débuté en 1761, correspondant à un maximum d’activité, a

reçu le numéro 1, de sorte que le cycle 24 a débuté en 2008.

Pour des raisons encore mal connues, la durée du dernier minimum solaire a été particulièrement longue. Le prochain maximum est attendu en principe vers 2013-2014.

La mission Picard va donc faire des mesures dans un moment très intéressant correspondant à la phase croissante du cycle solaire et devrait pouvoir contribuer à répondre à de nombreuses questions toujours existantes tant au niveau du fonctionnement du Soleil que dans les relations Soleil-Terre.

Les apports du satellite Picard...

Trois instruments scientifiques à bord dont deux développés en Belgique et en

Suisse, vont fournir des données aux laboratoires de recherche :

SOVAP comprend un radiomètre différentiel absolu (Institut royal météorologique de Belgique) avec un capteur bolométrique pour déterminer l’irradiance totale

.

PREMOS : Cette expérience développée en Suisse comprend trois photomètres et un radiomètre pour déterminer l’irradiance spectrale solaire. Il y a deux canaux dans l’UV pour étudier les variations de l’ozone stratosphérique, un canal dans le visible et deux canaux dans l’IR. L’objectif est de déterminer la variabilité de l’ozone, d’observer les oscillations solaires (pour faire des mesures d’heliosismologie) ; elle est aussi de déterminer l’irradiance absolue totale grâce à un radiomètre absolu fourni par l’Observatoire de Davos en Suisse.

SODISM : Il s’agit d’un télescope de 11 cm de diamètre (mesure du rayon du soleil, - environ 959,5 seconde de degré, à la milli-arcseconde près, de la forme du Soleil et de sa non-sphéricité). Cette expérience a été développée au LATMOS à l’Institut Pierre Simon Laplace avec des mesures permettant de faire aussi de l’héliosismologie ; SODISM est un télescope imageur associé à un CCD de 2048x2048 pixels.

Compte tenu de l’important effort international d’observation du Soleil, les mesures de Picard ne seront pas traitées de manière isolée. Elles s’intègreront dans un effort continu à long terme, en France, en Europe, et dans le monde (USA et Japon en particulier).

Dans un passé récent, on a

fait beaucoup de mesures sur le spectre du rayonnement solaire, et sur la

constante solaire, à commencer par le satellite SOHO, lancé en 1995, et qui est toujours en

activité, ainsi que la mission SORCE (à 640 km d’altitude lancé en 2003 par les

USA).

Dans un passé récent, on a

fait beaucoup de mesures sur le spectre du rayonnement solaire, et sur la

constante solaire, à commencer par le satellite SOHO, lancé en 1995, et qui est toujours en

activité, ainsi que la mission SORCE (à 640 km d’altitude lancé en 2003 par les

USA).

D’autres mesures de ces grandeurs sont faites à partir de la

station habitée, "l’International Space Station" depuis le début de 2008 ;

c’est l’expérience SOLSPEC du

LATMOS (spectre de 170-21024 nm), qui complète le domaine de longueur d’ondes

observées avec les expériences SOL-ACES (spectre 17-140 nm), et SEE

(spectre140-170 nm).

Il faut citer aussi les missions, Solar B (22 septembre 2006, lancée par

le Japon pour l’étude du champ magnétique solaire), et la mission STEREO (25 octobre 2006), lancée par les USA avec

deux satellites qui se suivent (pour obtenir des images stéréoscopiques des

éruptions solaires), et observer ainsi les couches extérieures de l’atmosphère

solaire avec des instruments américains et européens, dont des instruments

français. Le projet STEREO est la troisième mission du programme scientifique

international de l'étude des relations Soleil-Terre STP.

Mais de nouvelles technologies de surveillance du Soleil continuent de se développer, d‘où un nouvel effort aux USA avec la mission SDO, lancé le 11 février 2010 sur une orbite géosynchrone pour la mesure de la distribution du champ magnétique, et effectuer un sondage profond de l’intérieur solaire, mission dans laquelle deux laboratoires spatiaux français, sont associé. De son coté, l’ESA a lancé le satellite Proba-2 (novembre 2009), développé en Belgique avec une collaboration de l’Académie des sciences tchèque sur les instruments d’observation.

Dans quelques années, la mission Solar Orbiter étudiée

par l’ESA devrait être lancée, (à partir de 2015), pour succéder à la mission

Ulysse arrivée en fin de vie le 4 juin 2008, après 17 ans de service, et qui

tournait autour du Soleil pour permettre l'observation de ses pôles Nord et

Sud.

En dehors de l’Espace, l’Observatoire de la Côte d’Azur au plateau de Calern,

mesure depuis 30 ans le diamètre du Soleil, pour étudier sa variabilité au

cours du cycle solaire (Instrument Astrolabe solaire, puis l’instrument

Doraysol, et maintenant l’instrument SODISM-II, réplique de l’instrument en

orbite, avec en plus l’instrument Misolfa pour l’étude de la turbulence

atmosphérique). Le diamètre, de l’ordre de 1920 seconde de degré, est le plus

grand au moment du minimum solaire. Les variations sont de l’ordre de quelques

dixièmes de seconde à une demi-seconde de degré. Les mesures au sol sont

délicates et peuvent être perturbées par la traversée de l’atmosphère par les

rayons solaires; l’apport de la technologie spatiale permet de s’affranchir de

cette perturbation atmosphérique.

En complément de la mission spatiale sera menée la mission

Picard-sol pour faire des études comparatives de la mesure du diamètre solaire

depuis le plateau de Calern à l’Observatoire de la Côte d’Azur, et ainsi tirer

profit des 30 ans de mesures passées de cette grandeur. D’autres mesures au sol

seront associées à ces études.

Beaucoup de recherches sont en cours, particulièrement en Europe et en France

comme l’a montré la journée du 11 juin 2010 sur les relations Soleil-Terre,

organisée par l’Institut Pierre Simon Laplace.

En conclusion, Picard s’insère dans un plan de surveillance du Soleil, de l’environnement solaire et terrestre. Il marque notre contribution à un programme extrêmement ambitieux et pointu, avec de nouvelles technologies de plus en plus précises. Elles autorisent de grands espoirs, mais l’approche demeure complexe car la discipline inclue des aspects modélisation, des mesures à plusieurs satellites, ou issues de plusieurs expériences, dont des mesures au sol. Sur le plan du climat, l'objectif est de contribuer à reconstruire le passé, reproduire le présent, et tenter de se projeter dans le futur.

Mois de Juin 2010

1/1 Plainte de Claude Allègre : le point de vue d'Édouard Brézin.

Suite à une plainte déposée par Claude Allègre, le directeur de l'hebdomadaire Politis et sept personnalités du monde économique et scientifique dont un membre du Club des Argonautes, viennent d'être mis en examen pour "diffamation publique". Le délit : la publication en juin 2009 d'un article : «Claude Allègre, question d’éthique».

Le mardi 15 juin, s'est tenu au Théâtre de l'Est Parisien une réunion publique de protestation sur le thème : «Allègre politique, media et science» organisée par Mediapart, Politis et Terra Eco.

A cette occasion, a été lu un message d'Edouard Brézin, physicien, ancien président de l'Académie des Sciences et président du CNRS de 1992 à 2000.

On trouve le texte sur le blog de Sylvestre Huet, le voici reproduit ci-dessous :

«La science est engagée dans un processus collectif où, si

la confrontation des idées est indispensable, seule l'honnêteté

intellectuelle permet en définitive de corriger les erreurs temporaires

inévitables. Le choix des données, leur analyse, les modes de publication,

appartiennent à l'exigence d'intégrité des professions scientifiques.

Lorsque des scientifiques reconnus pour leurs contributions à un domaine où ils

ont fait preuve de leurs capacités, se servent de leur prestige pour asseoir

sur leur autorité des assertions non justifiées dans des domaines qui leur sont

étrangers, lorsque l'insulte, le mépris, l'intimidation, viennent au secours

des erreurs d'analyse, les scientifiques ne sont pas dupes, la science n'est en

rien affectée. En revanche la perception par la société de la science et de ce

que l'on peut en attendre, est complètement piétinée par cette attitude.

Les déclarations de C. Allègre sur les mathématiques ou la relativité générale

ont eu pour simple effet de ridiculiser leur auteur aux yeux de la communauté

scientifique. Mais lorsque le pouvoir politique, hélas de tous les bords, lui

donne les moyens d'agir ; lorsque la négation a priori de l'effet

anthropique sur le climat renforce le pouvoir de nuisance de ceux qui protègent

leurs intérêts et ne souhaitent que prolonger leur "business as usual", ce

n'est pas la science qui est en danger, mais tout notre avenir».

Un point de vue qu'il est réconfortant de lire tout comme l'article de Bruno Voituriez paru dans Le Monde du 1er juin 2010.

Mois de Mai 2010

1/1 - Prix Christian Le Provost, Océanographe - Deuxième édition

Le prix Christian Le Provost, créé à l'initiative de l’association "Christian Le Provost Océanographe" est destiné à promouvoir l’œuvre scientifique de l’océanographe Christian Le Provost.

Il vise à récompenser un jeune chercheur dont les travaux concernent la recherche en dynamique océanique dans toutes ses dimensions, qu’il s’agisse d’applications au climat, aux écosystèmes marins, à l’exploitation des ressources minérales, vivantes ou énergétiques dans les systèmes côtiers et hauturiers, ou qu’il s’agisse d’études de processus, expérimentales ou de modélisation.

La premier prix a été mis en place en 2009 avec l'aide du Conseil Général des Cotes d'Armor.

L'appel a candidature de la deuxième édition de ce prix est lancé.

Comme l'année dernière, le prix est doté d'un montant de 7 000 euros. La date limite de dépôt des dossiers est le 1er juin 2010.

Mois d'avril 2010

1/2 - La jeune fille et la mer

Marion Corre Labat, chargée de mission "énergies de la mer" à l'Agence Régionale de l'Énergie Réunion (ARER) nous a quittés le 26 Avril 2010 à l'âge de 24 ans.

Marion s'était résolument engagée dans le secteur des énergies

marines, co-auteur du document sur "Les

projets énergies de la mer en cours à l’île de La Réunion", elle avait un

contact assez étroit avec le Club.

Après avoir fait un stage chez Total sur l'Energie Thermique des Mers (ETM),

elle avait repris les activités de Matthieu Hoarau (correspondant du Club des

Argonautes) à l'ARER.

Depuis plusieurs années, elle suivait avec intérêt les nouvelles du Club des Argonautes , l'ETM étant, sur l'un des côtés du triangle Océan-Climat-Énergie, une de nos préoccupations principales.

Lors d'une rencontre récente avec David Levrat (aussi correspondant du Club), de passage à l'Île de la Réunion, elle avait manifesté sa volonté de devenir à son tour membre correspondant du Club.

C'est avec beaucoup d'intérêt que nous l'aurions accueillie.

Le Club des Argonautes s'associe à la douleur de sa famille et de ses amis.

2/2 - En bonne posture pour observer la Terre sur le long terme, pendant la tempête les travaux continuent...

Le satellite Cryosat-2 de l’ESA a été lancé avec succès le jeudi 8 avril 2010 par une fusée Dnepr depuis la base de Baïkonour au Kazakhstan.

Ce satellite développé par EADS Astrium, consacré à l’étude des glaces comme son nom l’indique et d’un poids de 700 kg a été placé sur une orbite circulaire et quasi-polaire à 700 km d’altitude.

Le dimanche 11

avril le nouvel instrument de base, l’altimètre SIRAL a été mis sous tension avec succès et les

mesures obtenues ont été conformes à tout ce qui avait été programmé et

attendu.

Le dimanche 11

avril le nouvel instrument de base, l’altimètre SIRAL a été mis sous tension avec succès et les

mesures obtenues ont été conformes à tout ce qui avait été programmé et

attendu.

Les premières données des échos radar furent recueillis sur la banquise en mer de Ross en Antarctique et permirent de voir clairement la couverture de la glace et les réflexions des échos radar sur les couches sous-jacentes.

On pourra désormais faire des observations jusqu’à la latitude de 88°, valeur qu'il n’avait encore jamais été possible d’atteindre avec les altimètres mis en orbite à ce jour. Ceci correspond à l’observation d’une surface additionnelle de 4,6 millions de km2 par rapport aux mesures altimétriques faites précédemment, à comparer aux 14 millions de km2 du seul continent Antarctique, ce qui est considérable et permettra d’observer les calottes glaciaires et la banquise c’est-à-dire des zones glacées encore jamais couvertes à ce jour par ce genre d’instrument.

Cet instrument SIRAL, travaillant à la fréquence à 13,7 Ghz dans la bande Ku et aussi en bande C vers 4 GHz pour permettre des corrections ionosphériques, est développé par Thales Alénia Space (en double sur Cryosat-2).

Il a plusieurs modes de mesure :

soit un mode radar à synthèse d’ouverture effectuant une mesure haute résolution, par exemple pour les glaces flottant sur la mer, utilisé pour la mesure indirecte de l’épaisseur de la banquise,

soit un mode interférométriquequi donne accès à la topographie de part et d’autre de la trace au sol du satellite, utilisé pour l’étude des reliefs avec des changements très importants comme la jonction banquise-continents Antarctique ou Groenland.

On pourra aussi utiliser un mode altimètre plus classique et conventionnel en pleine mer comme celui de Jason, ou dans des zones glacées avec un relief faiblement accidenté comme on peut le trouver en Antarctique.

Mais ces mesures ne

pourraient être utilement réalisées sans une connaissance préalable de la

topographie du littoral ainsi que la position précise du satellite par rapport

à ce littoral.

Mais ces mesures ne

pourraient être utilement réalisées sans une connaissance préalable de la

topographie du littoral ainsi que la position précise du satellite par rapport

à ce littoral.

Ceci peut être fait grâce à l’instrument développé par le CNES et qui fête ses 20 ans : le système DORIS qui donne le positionnement précis du satellite sur son orbite au cm près.

Parallèlement à ces orbites, traitées au sol à Toulouse par des équipes toulousaines, DORIS peut aussi mesurer en temps réel l’altitude de Cryosat-2 et aider ainsi le satellite à maintenir sa position, ce qui est une autre exigence pour faire des mesures côtières de qualité et de transition mer-continent ou banquise-continent.

Cryosat-2 va compléter une gamme très riche de satellites d’observation de

la terre au niveau européen sans oublier tout ce qui se fait par ailleurs au

niveau international.

CryoSat-2 est le troisième satellite européen (ESA) de la série des satellites d’exploration de la Terre mis en orbite depuis environ un an, auquel s'ajoutent :

le satellite GOCE lancé en mars 2009 et dédié à la détermination du géoïde terrestre et océanique avec une résolution spatiale de l’ordre de 100 à 200 km, qui n’avait encore jamais été obtenue directement.

et le satellite SMOS lancé en novembre 2009 et dédié à la mesure de la salinité des océans et l’humidité des sols.

L’ensemble, avec les satellites toujours en fonctionnement :

Jason-1 (lancé en décembre 2001 avec à bord l’altimètre Poséidon-2),

Jason-2 (lancé en juin 2008 avec l’altimètre à bord Poséidon-3),

Envisat (ESA)

donnent donc une capacité tout à fait remarquable pour l’observation continue de certains paramètres de la Terre et de son environnement.

À titre d’exemple depuis 1992, date de lancement du satellite franco-américain Topex-Poséïdon (CNES-NASA), on a pu suivre de manière continue le niveau moyen de la mer et des océans avec une précision de l’ordre de 0,5 mm/an et réaliser ainsi une série de bientôt 20 ans de données mettant en évidence une augmentation annuelle et continue de l’ordre de 3 mm/an.

D’une façon générale, on a appris dans ces deux dernières décennies une foule de choses sur les océans, en surface et en profondeur tant avec les moyens spatiaux (par exemple mesure de la bathymétrie des profondeurs à partir de la détermination de la surface de la mer) qu’avec des moyens in situ comme ceux du réseau Argo d'un peu plus de 3000 profileurs qui peuvent sonder la mer jusqu’à 2000 mètres de profondeur.

Ce sont tous ces moyens de mesure qui ont permis d’aboutir à l’océanographie opérationnelle (programme MERCATOR et My Ocean) comme cela existe depuis longtemps en météorologie opérationnelle et aussi à la mise en évidence de toute l’activité méso-échelle des océans et des tourbillons, phénomènes jusqu’alors largement ignorés.

Cryosat-2 doit fonctionner pendant 3 ans, mais plusieurs mois seront nécessaires pour la validation et la mise en œuvre de toutes ces performances potentielles.

Au niveau international, tous ces programmes rentrent parfaitement dans le cadre d’un effort concerté et initié avec l’année polaire internationale (2007-2008).

À cela il faut ajouter l’observation du Soleil, de l’environnement solaire et des relations soleil-terre, avec le lancement de l’instrumentation SOLSPEC en février 2008. Cet instrument initié par le CNES, développé par le service d’aéronomie du CNRS en collaboration avec l’Institut d’aéronomie spatiale de Belgique et l’Observatoire d’Heidelberg, à bord de la station spatiale internationale permettra la mesure de la distribution de l’énergie spectrale du Soleil en IR, visible et UV.

Puis il faut noter le lancement réussi de SDO en février 2010. Il s'agit d'un satellite de la NASA sur une orbite géosynchrone pour la mesure de l'EUV solaire, l’imagerie du Soleil dans dix longueurs d’onde et la mesure du champ magnétique du Soleil.

En juin 2010 devrait avoir lieu le lancement du satellite du CNES Picard qui permettra notamment la mesure du diamètre et et de l'irradiance solaire. Ces données sont essentielles dans toute étude climatologique.

En 2011 devrait être lancé la constellation de satellites SWARM de l’ESA. Cette constellation de 3 satellites semblables en orbite de type polaire mais à des altitudes différentes allant de 400 à 550 km devrait permettre d'étudier la magnétosphère et de mesurer le champ magnétique terrestre.

Le satellite ADM-EOLUS de l'ESA, mesurera des profils verticaux des vents horizontaux à l’échelle de la planète, les vents à la surface de la mer et sur terre.

Dans les années suivantes, devraient être lancés :

fin 2010, le satellite Saral/Altika, franco-indien, pour la mesure du niveau de la mer à partir d’un radar altimètre utilisant la bande de fréquence Ka vers 30 Ghz et devant permettre des mesures d’altimétrie très près des côtes

en 2016, le satellite SWOT, NASA-CNES comprenant une interférométrie à large fauchée, spécialement dédié à l’hydrographie continentale,

ainsi que :

JASON-3 actuellement prévu en 2013 (successeur de Jason-1 et Jason-2),

les trois premiers satellites «SENTINEL» à partir de 2011, dans la continuité et en remplacement des satellites de l’ESA, ERS-1 (lancé en 1991) et ERS-2 (lancé en 1995), Envisat (lancé en 2002 mais toujours en activité),

GRACE-FOLLOW ON, satellite successeur du satellite GRACE (lancé en 2003 mais toujours en activité) pour l’étude des variations temporelles du champ de gravité de la Terre.

Il y a aussi le projet américain GRAL qui reprendrait l’idée de ce qui a été fait avec le satellite ERS-1 placé sur une orbite dérivante dite «géodésique» avec une période de répétitivité de 168 jours, pour une étude très fine de la bathymétrie des océans.

C’est donc toute une batterie de satellites en fonctionnement ou à lancer dont on va disposer pour l’observation continue de la Terre, des Océans, de la cryosphère, de l’hydrologie continentale. Cette liste n’est pas exhaustive, il faut y ajouter les contributions des diverses agences spatiales mondiales (Russie, Japon, Chine, Inde, Brésil…).

Cependant ce serait une erreur de penser que tout cela va de

soi dans des moments où les crises financières et économiques secouent notre

monde. Il faut se battre chaque jour pour que tout cela aboutisse mais il faut

le dire heureusement avec un certain succès grâce à la volonté de beaucoup.

Mois de mars 2010

1/1 - À propos de l'appel des scientifiques du climat...

Une vive polémique s’est installée récemment autour des recherches sur le climat de la Terre et son évolution possible. Impliqué dans cette polémique, Claude Allègre revendique sa liberté de parole et n’est, dit-il, sous la tutelle de personne. Ainsi en est-il aussi des membres du Club des Argonautes qui tous, chercheurs et ingénieurs, ont travaillé et exercé des responsabilités dans les domaines d’étude de ce que nous appelons le «triangle océan, climat, énergie».

Retraités, les membres du Club entendent s’exprimer librement. Leur action se situe à la transition entre Science et Société et vise à transmettre au plus grand nombre le savoir scientifique dans les domaines de l’évolution climatique et des énergies marines :

en diffusant des informations pédagogiques d’une grande rigueur scientifique, issues de publications scientifiques validées et,

en apportant des explications claires sur les résultats actuels de la recherche et les différents scénarios possibles.

S’ils se sont choisis comme «sponsors» Jason et ses compagnons, c’est que comme les antiques Argonautes, ils sont à la recherche de quelque chose de précieux : la connaissance, qui passe par la passion de la recherche et la joie de la découverte.

Les nouveaux Argonautes ont conscience que la Terre est leur

vaisseau, et ils aiment à se dire « géonautes », persuadés qu’il faut

apprendre à piloter la Terre, non pas qu’elle soit menacée : elle en a vu

d’autres ! Mais elle est notre unique habitat, et il importe d’y maintenir les

meilleures conditions de vie possibles pour l’homme. Pour ce faire, il faut

bien la connaître et particulièrement la biosphère, cette mince couche

superficielle qui abrite la vie, dont l’homme est une composante, et dont le

fonctionnement dépend de manière interactive du climat.

Car si le monde vivant dépend du climat, le climat est aussi façonné par la

vie, depuis son apparition sur Terre. Que l’homme, cette nouvelle espèce,

transforme à son tour la biosphère et son climat est dans l’ordre naturel des

choses, et n’a rien d’anormal ou de sacrilège.

A lui d’en prendre toute la mesure en cherchant à comprendre le fonctionnement

du système climatique pour proposer des scénarios probables d’évolution. C’est

ce que font les climatologues qui, n’en déplaise à Claude Allègre, sont de

vrais scientifiques : physiciens, mathématiciens, météorologues, océanographes,

chimistes, biologistes, glaciologues, hydrologues ou géologues.

Ils prennent évidemment en compte une nouvelle perturbation que le monde vivant

introduit dans le système climatique : la production par l’homme de gaz à effet

de serre qui s’accumulent dans l’atmosphère. La physique expérimentale de base

dit qu’il s’ensuit nécessairement un accroissement de la quantité de chaleur

contenue dans l’atmosphère, et donc une élévation de sa température, à moins

que l’on invente une nouvelle physique. Les climatologues prennent en

compte ce phénomène et en évaluent l’impact sur les climats à venir suivant

différents scénarios d’accroissement des gaz à effet de serre, en précisant

bien les marges d’incertitude de ces différents scénarios.

Démarche éminemment scientifique, les climatologues s’appuient sur la meilleure

source d’information dont on puisse disposer, les mesures et les observations

qui seules, permettent de valider les modèles qu’ils utilisent et qui prennent

en compte tous les acteurs du climat.

Le Club des Argonautes a volontiers apporté son soutien à l’initiative des

climatologues, lancée par Valérie Masson Delmotte et 12 collègues, de faire

parvenir aux instances scientifiques une lettre ouverte les interpellant face

aux accusations mensongères lancées à l’encontre de la communauté des

climatologues.

Le club n’a aucun doute quant à la qualité scientifique de cette communauté à

travers le monde et, en la matière, le consensus ne peut être suspect qu’à ceux

qui, laissés pour compte de la climatologie, voudraient en tirer argument pour

se faire valoir, (semblables en cela aux créationnistes adversaires du

Darwinisme « consensuel »).

Pour assurer aux chercheurs leur liberté et leur indépendance vis-à-vis de

leurs tutelles, le Club a pris à son compte, via son site web, l’organisation

du processus de recueil des signatures de cette lettre ouverte,

lettre signée par des membres du club ayant eu à connaître de la climatologie.

Sur le fond, voir aussi :

Réponses aux arguments de ceux qui doutent de la réalité d’un changement climatique anthropique (Michel Petit - mars 2010)

La déclaration des onze académies (News 2005)

Mois de janvier 2010

1/3 - The Copenhagen Diagnosis : Climate Science Report

Dans la perspective de la

conférence de Copenhague l’Université New South Wales de Sidney a publié un

rapport «The Copenhagen Diagnosis : Climate Science Report».

Rédigé par 26 spécialistes de différents pays il constitue une mise à jour de la première partie «The physical science basis» du 4ème rapport du Giec qui date de 2007 sur la base des résultats scientifiques obtenus depuis sa rédaction.

Il couvre l’ensemble des sujets traités dans le rapport du Giec et inclut :

une analyse des émissions des gaz à effet de serre et de leur concentration dans l’atmosphère ainsi que du cycle du carbone ;

un examen des différentes composantes du système climatique : atmosphère, océans, surface terrestre, cryosphère

les projections pour le futur

les paléoclimats, évènements extrêmes, niveau de la mer, changements brutaux, effets de seuil etc…

Le rapport comporte aussi de nombreux encarts pour expliquer les erreurs d’interprétation et de compréhension couramment rencontrées à propos du changement climatique : la saturation en CO2, l’importance de l’activité solaire, le refroidissement supposé des dix dernières années etc...

Destiné aux «décideurs», parties prenantes, media, c’est un rapport «grand public» très accessible, si ce n’est que seul le «résumé exécutif» d’une page est traduit en français.

Le Club des Argonautes recommande cet excellent rapport que l’on trouve en libre accès :

The Copenhagen diagnosis

2/3 - Le Conseil Interministériel de la Mer (Cimer) du 8 décembre 2009 adopte le Livre Bleu : «Stratégie nationale pour la mer et les océans»

Un Conseil Interministériel de la Mer s’est tenu le 8 décembre 2009 sous la présidence du Premier Ministre François Fillon. La discrétion politique et médiatique de cet évènement est aux antipodes de son annonce le 16 juillet 2009 au Havre par le Président de la République dans son discours «sur la politique maritime de la France».

L’objectif assigné était alors de valider un «Livre Bleu» définissant la stratégie maritime française à partir des travaux du «Grenelle de la Mer».

Sans doute, passant du niveau présidentiel à l’humble niveau primo ministériel, le sujet s’est-t-il trouvé automatiquement dévalué et la «politique maritime de la France» y a-t-elle perdu de son poids politique potentiel et donc de sa valeur médiatique.

Ce Cimer a pourtant bien eu lieu et il a adopté le

«Livre bleu : stratégie nationale pour la mer et les océans»

construit en piochant dans la «remarquable boîte à outils» que «fournissent les conclusions du Grenelle de la mer» comme le dit François Fillon dans sa présentation du Livre Bleu.

Il serait sans doute malvenu de s’étonner que sur le site du «Grenelle de la mer» au Ministère de l’Ecologie de l’Energie du Développement Durable et de la Mer (MEEDDM), il ne soit fait aucune mention de la réunion du Cimer et de l’adoption du Livre Bleu. L’explication tient sans doute au fait que Jean-Louis Borloo n’était pas présent à la réunion du Cimer… Il est vrai que le 6 novembre Jean-Louis Borloo avait déjà lancé de son côté les «Chantiers opérationnels du Grenelle de la Mer» destinés à définir les modalités concrètes de mise en œuvre des engagements du Grenelle de la Mer.

Soyons optimistes et parions que les deux démarches

convergeront et qu’il ne s’agit que de la mise en pratique de l’adage marin

bien connu : «trop fort n’a jamais manqué».

Quoiqu’il en soit... «Livre Bleu» il y a maintenant, et son adoption

avait été précédée le 2 décembre par le discours

de clôture du Premier Ministre aux 5ème Assises «Economies de la

Mer» de Brest.

Qu’en retiennent les Argonautes particulièrement de leur

point de vue triangulaire : «Climat, Océan, Energie» ?

Une volonté politique

D’abord l’affirmation volontariste d’une politique maritime pour la

France qui «doit être une politique intégrée inscrite dans le

développement durable».

Il ne pouvait en être autrement et, soyons encore optimistes,

au-delà des mots convenus, prenons acte de cette volonté affirmée qui ouvre des

perspectives politiques nouvelles. Tout dépend évidemment de la manière dont

cette politique sera mise en œuvre et des moyens qui pourront lui être

affectés. Etant donnée la conjoncture, on peut être inquiet de ce point de vue

et l’insistance à évoquer l’intégration, la mutualisation, la rationalisation

des moyens et la coordination des acteurs peut laisser craindre que cette

«politique ambitieuse» ne se réduise à mimer le mouvement en multipliant

Conseils et Comités.

Un souci d’intégration

Ensuite la prise en compte de tous les aspects qui relient la mer à l’homme

:

l’environnement et le climat,

les ressources vivantes, minérales et énergétiques,

les transports, les ports,

la construction navale,l

la plaisance et les loisirs,

la sécurité en mer ,

la «gouvernance» aux différents niveaux de responsabilité, la formation et l’enseignement.

Tout y est et l’on ne peut qu’approuver.

Mais l’on peut se demander aussi si l’organisation «intégrée» d’un tel ensemble peut vraiment se contenter, pour être efficace, de simples structures de coordination même quand on leur donne un joli nom comme «Conseil National de l’Archipel France», l’instance nationale de concertation qui couronne l’édifice.

Il y a dans ce Livre Bleu, face à l’affirmation d’une volonté

stratégique facilement médiatisable, un grand souci de maintenir le paysage

institutionnel en l’état comme si, au prétexte que la mer est l’affaire de tous

elle ne devait être de la responsabilité de personne….

Océan et Climat

Les relations océans climat sont un l'un des enjeux d’une politique maritime

pour la France explicités dans le Livre Bleu :

modification de la circulation océanique,

élévation du niveau de la mer,

acidification des océans,

évolution des écosystèmes marins

etc...

Il en découle logiquement l’affirmation de la priorité donnée à la nécessité de «Mieux connaître pour mieux gérer».

D’où une recherche marine qui «devra constituer le cœur d’une véritable politique océanographique». On applaudit sans réserve. Mais ici encore on ne fait que coordonner : les «opérateurs de premier rang» cette fois dans une «Alliance des Sciences de la mer» annoncée par Valérie Pécresse au colloque organisé par l’Ifremer pour son 25ème anniversaire les 28-29 septembre 2009. Comme d’habitude, on ne touche à rien et l’on crée une nouvelle structure de coordination des acteurs qui ajoute à la complexité…

D'où aussi dans les priorités au titre de la connaissance l’«importance particulière qui sera portée à l’observation de l’océan».

C’est un point qui tient particulièrement à cœur au Club des Argonautes qui a insisté sur la nécessité de pérenniser les systèmes d’observation spatiaux et in situ en vue d’une océanographie opérationnelle dans le cadre du programme européen GMES dont le groupement français Mercator-Ocean assure la coordination du volet océan (My Ocean).

On ne peut que se réjouir de voir le Livre Bleu reprendre cet objectif, quasiment dans les mêmes termes, et le «Relevé de décisions du CIMER du 8 décembre 2009» annoncer l’évolution rapide du statut de Mercator-Océan «vers une structure de société civile compatible avec une mission opérationnelle pérenne de service public».

C’est un point très positif, mais on est encore loin du système opérationnel d’observations dont on a besoin si l’on en juge par le montage qui se dessine :

d’une part, au niveau des moyens qui «découleront de leur «mutualisation renforcée» entre les nombreux acteurs et cette mutualisation serarecherchée à travers des programmes pilotés et financés en commun» ;

d’autre part, à celui de l’organisation : «Un programme national de surveillance de la mer et du littoral sera établi par l’État en concertation avec le Conseil National de l’Archipel France. Piloté par une maîtrise d’ouvrage interministérielle, il sera développé sous la maîtrise d’œuvre d’un consortium d’organismes publics.»

Imagine-t-on un service opérationnel de météorologie sous maîtrise d’œuvre d’un consortium d’organismes publics et dépendant d’une mutualisation des moyens d’une dizaine d’organismes pour assurer la pérennité d’un système d’observations ?

Optimisme toujours : nous faisons le pari que la prise en compte de la nécessité d’une océanographie opérationnelle dans le Livre Bleu débouchera nécessairement sur une organisation responsable.

Les énergies marines

Au titre des enjeux, le Livre Bleu affirme : «L’exploitation des mers

comme source d’énergies nouvelles entièrement renouvelables n’en est qu’à ses

balbutiements, mais les connaissances actuelles font déjà entrevoir un

potentiel immense».

Un long paragraphe est consacré aux ressources énergétiques dans le chapitre« Développer une économie durable de la Mer», avec l’affirmation que le développement des énergies marines est un axe prioritaire de la politique maritime française.

Il s’agit nommément dans l’ordre de citation :

énergie thermique,

cinétique(courants et vent),

potentielle barrages ou lagons,

chimique (énergie osmotique),

biologique (micro algues).

Il est précisé aussi qu’hormis l’éolien en mer, les procédés ne sont pas matures et que la France établira une stratégie de recherche et de développement grâce à la mise en place d’une plateforme technologique des énergies renouvelables en mer et au financement de démonstrateurs, en particulier outre-mer.

François Fillon dans son discours de Brest du 2 décembre 2009 insistant sur la nécessité de l’intervention de la puissance publique pour le développement de ces énergies «encore balbutiantes» avait annoncé la création de cette plate-forme technologique avec pour chef de file l’Ifremer.

C’est confirmé très explicitement dans le relevé de décisions du Cimer du 8 décembre 2009 : elle sera lancée en 2010 pour conduire des études et développer les démonstrateurs nécessaires pour valider les diverses technologies.

C’est une suite logique à l’initiative « Ipanema » (Initiative Partenariale Nationale pour l’émergence des Energies Marines) signée le 17 octobre 2008 qui associe plusieurs régions, EDF, DCNS, Ademe, MEEDDM et à laquelle participent de nombreux partenaires économiques, industriels et académiques qui s’est donnée comme objectifs :

de promouvoir le développement d’une filière scientifique et industrielle «Energies des Mers»,

de développer des sites d’essais en mer adaptés aux différentes technologies et de faciliter le développement de démonstrateurs.

C’est certainement un des points les plus positifs car très concrets du Livre Bleu et du Cimer. Manifestement les choses bougent en ce qui concernent les énergies marines. En témoigne l’Appel à manifestation d’Intérêt sur les énergies marines de l’Ademe du 2 septembre 2009 qui vise à valider les options technologiques possibles sur quatre filières :

hydroliennes,

éolien flottant,

houlomotrices,

énergie thermique des mers (ETM),

Cette dernière énergie marine a fait l'objet d'une convention de partenariat entre DCNS et la Région Réunion signée en Avril 2009 pour la réalisation d'une étude de faisabilité sur la mise en place d'un démonstrateur ETM de 1,5 MW en 2014 à La Réunion. Avant son échéance, une seconde convention a été signée, en Octobre 2009, entre ces mêmes partenaires et l'Etat Français, dans le cadre du plan de relance, pour la réalisation d'un "Prototype à Terre" ETM, visant à tester à échelle réduite le système énergie de l'ETM, pour étudier la canalisation d'eau froide profonde et réaliser des mesures environnementales sur le site d'implantation.

Conclusions

L’océan a de l’avenir et le Gouvernement semble l’avoir compris, qui

affiche une stratégie globale.

C’est un bon point de départ mais le plus difficile reste à faire.

Comme il est dit dans la postface du «Livre Bleu» : «il

reste désormais à définir dans les très nombreux domaines concernés des

objectifs précis et le calendrier associé, mais aussi à préciser les

responsabilités et les moyens à mettre en œuvre : ce travail mobilisera le

Gouvernement, en liaison avec les collectivités territoriales, le monde

maritime et la société civile.»

Nous faisons le pari de l’optimisme ; rendez vous au prochain Cimer qui doit se

réunir d’ici la fin de 2010 pour «valider le plan d’action

correspondant».

3/3 - Georges Claude, le génie fourvoyé, créateur d'Air Liquide, du tube au néon, de l'Énergie Thermique des Mers....

Georges Claude, 1870-1960, a marqué son époque de nombreuses et

géniales inventions qui prospèrent encore dans l’industrie. Il est sans doute

l’inventeur français le plus fécond. Comment peut-il être ignoré du grand

public aujourd’hui ?

À l’origine d’Air Liquide (dont la raison sociale demeure : société anonyme

pour l’étude et l’exploitation des procédés Georges Claude), des Lampes Claude,

de la Société Chimique de La Grande Paroisse, du tube au néon, de nombreuses

armes de guerre en 14, de la synthèse de l’ammoniaque par hyper-pression, de

l’Énergie Thermique des Mers… “l’homme aux 250 inventions” fut un chercheur

infatigable et opiniâtre contre l’avis des scientifiques dominants. Il était

mondialement connu et admiré avant le dernier conflit mondial.

Il fut élu à l’Académie des Sciences en 1924, honoré par quantité d’Universités

et d’organismes internationaux. Les Américains l’appellent l’Edisoève de

l’École Municipale de Chimes de Paris, électricien, jounaliste, physicien,

chimiste, ingénieur, économiste, ce génie a voulu devenir tribun et il s’est

noyé dans le chaudron hautement toxique de la politique. Le Cassandre des

années 30 s’est entêté pour soutenir son ami Pétain dans un collaborationnisme

suicidaire et s’est commis dans les excès de l’extrême droite. Le rival des

scientifiques allemands ne voyait d’avenir que dans la grande Europe… d’Adolf

Hitler. Trop d’intérêts et une histoire trop manichéenne le condamnent à

l’oubli.

Rémi Baillot, avec la même ténacité que l’inventeur, a reconstitué et cherché à

comprendre ce parcours fourmillant d’aventures, de combats et de conquêtes.

À l’appui de nombreuses illustrations originales, il a replacé dans l’histoire

de la science et de la politique au XXe siècle, la tragédie de ce gaulois

intrépide, courageux, savant, inspiré, fier, mais aussi terriblement sourd et

follement jusqu’au boutiste. Il sort de l’oubli un génie qui s’est fourvoyé.

Pour en savoir plus : Blog de Rémi Baillot : http://rbaillot.blogspot.com

On peut y voir un film réalisé dans les années 30 où Georges Claude raconte

lui-même ses aventures à la conquête de l’Energie Thermique des Mers, à Cuba et

à Rio de Janeiro,

Voir aussi l'article du site sur l'expérience de Georges Claude à Cuba.